DIG Digital Corner

Alles wat je altijd al over computers, hardware, software, internet en elektronische gadgets had willen weten, maar niet op Tweakers.net durft te vragen.

Club nVidia 8800 topic

GeForce 8-Series Tech Demos

Leuk om te zien wat voor kracht je wel niet in je PC heb hangen, met deze demo\'s speciaal voor de 8800 kan je realtime renders uitvoeren op de G80 core.

Human Head

Adrianne

Cascades DirectX10

Box of Smoke

Froggy

Voor de niet 8800 bezitters kunnen hier ook een demo bekijken van nVidia Human Head

Met PureVideo kan je realtime je video/dvd films laten verbeteren (te gebruiken op elke 6/7/8 series nVidia kaart)

G80 Processing Architecture (8800GTX/Ultra)

De GTS heeft dezelfde architecture maar dan met 6 streaming processors i.p.v. 8

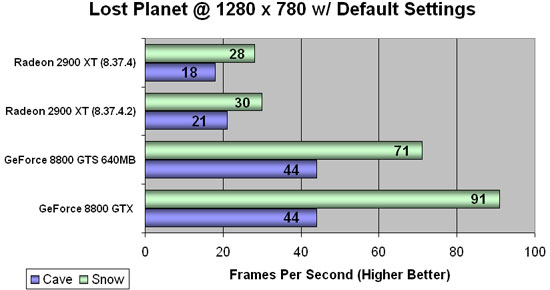

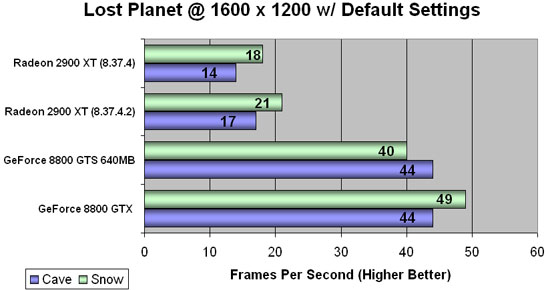

Enkele benchmark resultaten van de 8800 vs. Radeon 2900XT

Lost Planet DirectX10

Meld hier je 8800 aan

Inspiratiebron [Club E6600] Meld je hier!

nvidia driver update

update is vereist wanneer je Bioshock demo wil kunnen spelen!

163.44 BETA

Windows Vista 32-bit

Windows Vista 64-bit

Windows XP/2000 32-bit

Windows XP Pro 64-bit

De GTS is in feite een kapotte GTX waarvan de niet werkende onderdelen zijn uitgezet.quote:Op zaterdag 11 augustus 2007 15:40 schreef Biogarde het volgende:

Voor de peeps met een 8*** serie en die hun klassieke controlpanel-weergave weer terug willen hebben:

Ga naar regedit.exe te vinden in de map Windows.

Daarna HKEY_LOCAL_MACHINE/SOFTWARE/NVIDIA Corporation/Global/NvCplApi/Policies.

Maak vervolgens een nieuwe DWORD-waarde aan en noem deze: sedonadisable.

Vervolgens dubbelklik je erop en vul je bij waardegegevens: 2 in.

Nu ga je weer naar je NVIDIA configuratiescherm en kun je bovenin bij Beeld klassiek controlepaneel weer aanzetten.

© dikkedorus.

[ Bericht 2% gewijzigd door Biogarde op 23-08-2007 00:57:55 ]

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Mocht er wat missen dan hoor ik dat graag.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

8800GTS Prima kaart. Lekker snel, Battlefield 2 draait op hoogste settings op 1680x1050.

Alleen als ik Quicktime Player wil updaten, krijg ik een runtime error bij Quicktime. Schijnt meer voor te komen bij de 8xxx serie en de XP-drivers.

Alleen als ik Quicktime Player wil updaten, krijg ik een runtime error bij Quicktime. Schijnt meer voor te komen bij de 8xxx serie en de XP-drivers.

"The greatest distance in the universe is that between two minds"

Da's een 8600. 8800-serie is te koop vanaf 250 ergens..quote:Op donderdag 23 augustus 2007 00:10 schreef Devrim_ het volgende:

Is het raar dat ik een nVidia 8800 GT voor 110 euro heb zien liggen?

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Misschien leuk om er bij te zetten dat een GTS eigenlijk een kapotte GTX is waarvan de kapotte onderdelen zijn uitgezet.

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

Oke

-edit-

Done

-edit-

Done

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Oh, en voor de Bioshock fans: Bioshock gaat als een raket op de GTS. Alles vloeiend op max detail en resolutie.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Ja dat is raar, hij bestaat namelijk nietquote:Op donderdag 23 augustus 2007 00:10 schreef Devrim_ het volgende:

Is het raar dat ik een nVidia 8800 GT voor 110 euro heb zien liggen?

@Bio: Dat Bioshock, je bent er zo lovend over, wat is er nou precies zo geweldig aan? Ik ken het spel niet verder, dus wat uitleg wordt op prijs gesteld

I have the cape. I make the fucking Whoosh noise.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Wel DX10 neem ik aan?quote:Op donderdag 23 augustus 2007 00:59 schreef Biogarde het volgende:

Oh, en voor de Bioshock fans: Bioshock gaat als een raket op de GTS. Alles vloeiend op max detail en resolutie.

A.F.C. Ajax

Battlefield 2 draait bij mij ook op max. met een 7600GT.quote:Op woensdag 22 augustus 2007 23:36 schreef FritsFlits het volgende:

8800GTS Prima kaart. Lekker snel, Battlefield 2 draait op hoogste settings op 1680x1050.

Alleen als ik Quicktime Player wil updaten, krijg ik een runtime error bij Quicktime. Schijnt meer voor te komen bij de 8xxx serie en de XP-drivers.

A.F.C. Ajax

En werkt de 8600 een beetje fatsoenlijk?quote:Op donderdag 23 augustus 2007 00:23 schreef Biogarde het volgende:

[..]

Da's een 8600. 8800-serie is te koop vanaf 250 ergens..

Ik moet echt een nieuwe kaart hebben (budget is rond de 110 euro)

Ik heb zelf nog een Ati X600

Sorry, niet echt. Dan kun je beter voor een dikke Dx9-kaart gaan.quote:Op donderdag 23 augustus 2007 07:39 schreef Devrim_ het volgende:

[..]

En werkt de 8600 een beetje fatsoenlijk?

A.F.C. Ajax

mooie OP

tevens tvp

tevens tvp

Op donderdag 4 oktober 2007 09:50 schreef staticdata het volgende:

- Alle Milfen zullen zich, gesorteerd op cup maat, in rijen van 10 staan en zich bereidwillig opstellen

- Alle Milfen zullen zich, gesorteerd op cup maat, in rijen van 10 staan en zich bereidwillig opstellen

[Xbox 360, PC] Bioshockquote:Op donderdag 23 augustus 2007 06:39 schreef Merovingian het volgende:

[..]

Ja dat is raar, hij bestaat namelijk niet

@Bio: Dat Bioshock, je bent er zo lovend over, wat is er nou precies zo geweldig aan? Ik ken het spel niet verder, dus wat uitleg wordt op prijs gesteld

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Is de 8600GT dan geen dikke Dx9-kaart?quote:Op donderdag 23 augustus 2007 09:06 schreef SoupNazi het volgende:

[..]

Sorry, niet echt. Dan kun je beter voor een dikke Dx9-kaart gaan.

Ik dacht namelijk van wel

[ Bericht 13% gewijzigd door Devrim_ op 23-08-2007 15:40:50 ]

Welke reso? Lost planet ging echt niet lekker op 1900x1200 (24 inch wide) met alles Full, haalde soms maar 15 Fps .quote:Op donderdag 23 augustus 2007 00:59 schreef Biogarde het volgende:

Oh, en voor de Bioshock fans: Bioshock gaat als een raket op de GTS. Alles vloeiend op max detail en resolutie.

A gentle wave of heat flows over the FOK! forum

Get woke, go broke!

Get woke, go broke!

1680 x 1050.quote:Op donderdag 23 augustus 2007 17:06 schreef HeatWave het volgende:

[..]

Welke reso? Lost planet ging echt niet lekker op 1900x1200 (24 inch wide) met alles Full, haalde soms maar 15 Fps .

Bij 1900 x 1200 gaat ie idd hakkelen. Wanneer er veel te zien is in een omgeving heb je een drop van 20 frames soms. 1600 liep wel lekker.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

OK, kan ik mee leven dan .quote:Op donderdag 23 augustus 2007 17:13 schreef Biogarde het volgende:

[..]

1680 x 1050.

Bij 1900 x 1200 gaat ie idd hakkelen. Wanneer er veel te zien is in een omgeving heb je een drop van 20 frames soms. 1600 liep wel lekker.

Toch jammer dat je relatief snel alweer spellen hebt die je niet op max kan pompen. Ga niet over 3 maanden weer een 9800GTS kopen ofzo .

A gentle wave of heat flows over the FOK! forum

Get woke, go broke!

Get woke, go broke!

WOW. Sinds zojuist mijn 8800GTS 320MB binnen en werkelijk ALLES draait op max. Cod2, Bioshock, Rainbow Six Vegas, Dirt, Call of Juarez, TDU. Op een resolutie van 1440x900. Dus ik ben blij dat ik die extra 80 euro niet heb uitgegeven aan de 640MB-versie. En klopt het trouwens dat ik met de nieuwe nVidia-drivers Test Drive Unlimited met HDR én AA kan draaien?

A.F.C. Ajax

Geen idee eik. Wellicht proberen? Nieuwe drivers is sowieso altijd beter.quote:Op donderdag 23 augustus 2007 20:59 schreef SoupNazi het volgende:

WOW. Sinds zojuist mijn 8800GTS 320MB binnen en werkelijk ALLES draait op max. Cod2, Bioshock, Rainbow Six Vegas, Dirt, Call of Juarez, TDU. Op een resolutie van 1440x900. Dus ik ben blij dat ik die extra 80 euro niet heb uitgegeven aan de 640MB-versie. En klopt het trouwens dat ik met de nieuwe nVidia-drivers Test Drive Unlimited met HDR én AA kan draaien?

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Ja het kan bij mij dus wel nu. Maar ik meen me dus te herinneren dat HDR+AA helemaal niet kon, dus vandaar.quote:Op donderdag 23 augustus 2007 22:02 schreef Biogarde het volgende:

[..]

Geen idee eik. Wellicht proberen? Nieuwe drivers is sowieso altijd beter.

A.F.C. Ajax

quote:Op donderdag 23 augustus 2007 22:02 schreef Biogarde het volgende:

[..]

Geen idee eik. Wellicht proberen? Nieuwe drivers is sowieso altijd beter.

Regelmatig met nVidia gehad bij de drivers tussen januari en juni dat als je weer een nieuwe versie nam, er een probleem met een spel verholpen was, maar dat er vervolgens 3 andere games weer kut draaiden of er niet uitzagen ofzo.

I have the cape. I make the fucking Whoosh noise.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Eens, over het algemeen is het nog steeds aan te raden. Zodra je problemen krijgt met games even roll-backen. Daar is het voor.

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

Nou, ik moet idd bekennen dat ik ooit een 7900GS had waarvan de bijgeleverde driver op cd de beste was dan al die updates die er na die tijd kwamen.quote:Op donderdag 23 augustus 2007 22:15 schreef Merovingian het volgende:

[..]

Regelmatig met nVidia gehad bij de drivers tussen januari en juni dat als je weer een nieuwe versie nam, er een probleem met een spel verholpen was, maar dat er vervolgens 3 andere games weer kut draaiden of er niet uitzagen ofzo.

Wat dat betreft moet ik je idd gelijk geven.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Maar goed, mocht Soup het zeker willen weten dan zal hij het moeten testen.

En daar hebben wij ook wat aan

En daar hebben wij ook wat aan

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Lezen. Het werkt bij mij dus al, maar ik zocht even confirmatie.quote:Op donderdag 23 augustus 2007 22:18 schreef Biogarde het volgende:

Maar goed, mocht Soup het zeker willen weten dan zal hij het moeten testen.

En daar hebben wij ook wat aan

A.F.C. Ajax

Ik kan niet lezen.quote:Op donderdag 23 augustus 2007 23:07 schreef SoupNazi het volgende:

[..]

Lezen. Het werkt bij mij dus al, maar ik zocht even confirmatie.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Net Bioshock gekocht

Loopt als een trein

Loopt als een trein

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

beetje offtopic maar toch wel ontopic

Ik krijg dus een lappie met een 8600M GT erin, waar kan ik die vergelijken met de 8800 GT?

Wat ik wel weet dat op die laptop Battlefield 2124 op max smooooooth draaide (video vinden..)

Ik krijg dus een lappie met een 8600M GT erin, waar kan ik die vergelijken met de 8800 GT?

Wat ik wel weet dat op die laptop Battlefield 2124 op max smooooooth draaide (video vinden..)

[quote][img=12,12]http://i.fokzine.net/templates/new/i/p/1.gif[/img] Op dinsdag 2 juni 2009 02:28 schreef 8D het volgende:

Netzoals die mensen die nog aan het posten zijn rond deze tijd op Fok! Kansloos gewoon :') !

[/quote]

Netzoals die mensen die nog aan het posten zijn rond deze tijd op Fok! Kansloos gewoon :') !

[/quote]

3Dmark?quote:Op vrijdag 24 augustus 2007 18:06 schreef Sjibble het volgende:

beetje offtopic maar toch wel ontopic

Ik krijg dus een lappie met een 8600M GT erin, waar kan ik die vergelijken met de 8800 GTS?

A.F.C. Ajax

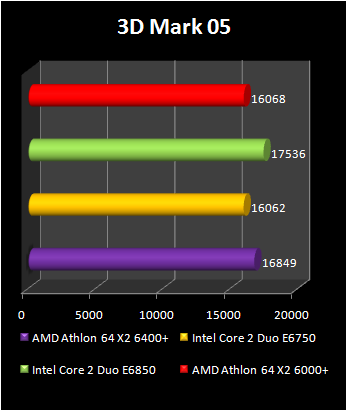

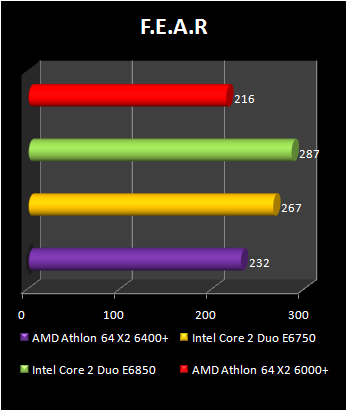

Ik zit nu trouwens met mijn 8800GTS en Athlon X2 5600+ op 9700 3DMarks (06), dus dat lijkt me wel een mooi resultaat.

A.F.C. Ajax

Het zal misschien al wel aan de orde zijn geweest, maar stel m'n vraag toch:

De laatste tijd lees ik allemaal verhalen dat allerlei computergebruikers wachten tot november met het upgraden van het systeem, omdat dan de 9800gts/gtx uitkomen en deze een veel betere ondersteuning voor directx 10(.1) geven.

Nu geloof ik dat graag, maar is het verschil nu werkelijk zo groot dat je ineens een jaar langer mee vooruit kan vóór de volgende upgrade of is het weer een opgelaaide hype door bijvoorbeeld tweakers (zoals ook werd gesproken over de 8800 serie) en dat het enkel wat grafische verbeteringen/ondersteuningen zijn?

Dus als ik een 8800 gts zou kopen, doe ik er dan werkelijk verkeerd aan om geen 2 maanden te wachten voor een (volgens nieuwsberichten 2x(!?) ) zo snellere kaart.

De laatste tijd lees ik allemaal verhalen dat allerlei computergebruikers wachten tot november met het upgraden van het systeem, omdat dan de 9800gts/gtx uitkomen en deze een veel betere ondersteuning voor directx 10(.1) geven.

Nu geloof ik dat graag, maar is het verschil nu werkelijk zo groot dat je ineens een jaar langer mee vooruit kan vóór de volgende upgrade of is het weer een opgelaaide hype door bijvoorbeeld tweakers (zoals ook werd gesproken over de 8800 serie) en dat het enkel wat grafische verbeteringen/ondersteuningen zijn?

Dus als ik een 8800 gts zou kopen, doe ik er dan werkelijk verkeerd aan om geen 2 maanden te wachten voor een (volgens nieuwsberichten 2x(!?) ) zo snellere kaart.

Ehm... ok

Daar ben ik ook benieuwd naarquote:Op maandag 27 augustus 2007 03:25 schreef Frumzel het volgende:

Het zal misschien al wel aan de orde zijn geweest, maar stel m'n vraag toch:

De laatste tijd lees ik allemaal verhalen dat allerlei computergebruikers wachten tot november met het upgraden van het systeem, omdat dan de 9800gts/gtx uitkomen en deze een veel betere ondersteuning voor directx 10(.1) geven.

Nu geloof ik dat graag, maar is het verschil nu werkelijk zo groot dat je ineens een jaar langer mee vooruit kan vóór de volgende upgrade of is het weer een opgelaaide hype door bijvoorbeeld tweakers (zoals ook werd gesproken over de 8800 serie) en dat het enkel wat grafische verbeteringen/ondersteuningen zijn?

Dus als ik een 8800 gts zou kopen, doe ik er dan werkelijk verkeerd aan om geen 2 maanden te wachten voor een (volgens nieuwsberichten 2x(!?) ) zo snellere kaart.

Ik heb nu een 8800gtx, maarja, als die kaart echt 2x zo snel is en het verschil is echt aanzienlijk, ben ik toch ban dat ik weer zo'n drang krijg om hem te kopen

The One And Only

nou dan wil ik je wel van je oude kaart afhelpen tegen die tijdquote:Op maandag 27 augustus 2007 07:25 schreef Kyller het volgende:

[..]

Daar ben ik ook benieuwd naar

Ik heb nu een 8800gtx, maarja, als die kaart echt 2x zo snel is en het verschil is echt aanzienlijk, ben ik toch ban dat ik weer zo'n drang krijg om hem te kopen

Op donderdag 4 oktober 2007 09:50 schreef staticdata het volgende:

- Alle Milfen zullen zich, gesorteerd op cup maat, in rijen van 10 staan en zich bereidwillig opstellen

- Alle Milfen zullen zich, gesorteerd op cup maat, in rijen van 10 staan en zich bereidwillig opstellen

Zelf nu eindelijk ook een 8800GTS, alles draait als een trein .. prima kaart..quote:Op zondag 26 augustus 2007 13:40 schreef SoupNazi het volgende:

Ik zit nu trouwens met mijn 8800GTS en Athlon X2 5600+ op 9700 3DMarks (06), dus dat lijkt me wel een mooi resultaat.

alleen jammer dat ik ook 'maar' iets van 9500 3dmarks scoor, terwijl ik een Athlon x2 6000+ heb..

Heb jij misschien meer ram?(2gig) Of heb je het een en ander gewoon getweaked?

..non est vivere sed valere vita est ..

Zou er niet van uitgaan dat die 98-serie daadwerkelijk aan het eind van het jaar verkrijgbaar is.quote:Op maandag 27 augustus 2007 03:25 schreef Frumzel het volgende:

Het zal misschien al wel aan de orde zijn geweest, maar stel m'n vraag toch:

De laatste tijd lees ik allemaal verhalen dat allerlei computergebruikers wachten tot november met het upgraden van het systeem, omdat dan de 9800gts/gtx uitkomen en deze een veel betere ondersteuning voor directx 10(.1) geven.

Nu geloof ik dat graag, maar is het verschil nu werkelijk zo groot dat je ineens een jaar langer mee vooruit kan vóór de volgende upgrade of is het weer een opgelaaide hype door bijvoorbeeld tweakers (zoals ook werd gesproken over de 8800 serie) en dat het enkel wat grafische verbeteringen/ondersteuningen zijn?

Dus als ik een 8800 gts zou kopen, doe ik er dan werkelijk verkeerd aan om geen 2 maanden te wachten voor een (volgens nieuwsberichten 2x(!?) ) zo snellere kaart.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Videokaart op z'n flikker geven denk ik? Gewoon overclocken. Meeste GTS'en draaien 650/2000.quote:Op maandag 27 augustus 2007 17:52 schreef Augustus_Thijs het volgende:

[..]

Zelf nu eindelijk ook een 8800GTS, alles draait als een trein .. prima kaart..

alleen jammer dat ik ook 'maar' iets van 9500 3dmarks scoor, terwijl ik een Athlon x2 6000+ heb..

Heb jij misschien meer ram?(2gig) Of heb je het een en ander gewoon getweaked?

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Dat is zeer netjes. Ik heb ook 2 gieg, maar ik had mijn videokaart wel een stuk hoger dan standaard draaien. Helaas zit nu op een clean install van Vista en krijg ik hem niet eens meer over de 8700 heen met dezelfde clocks, en met dezelfde (163.11) drivers. Duizend punten lager dus. Iemand enig idee waar dit aan kan liggen?quote:Op maandag 27 augustus 2007 17:52 schreef Augustus_Thijs het volgende:

[..]

Zelf nu eindelijk ook een 8800GTS, alles draait als een trein .. prima kaart..

alleen jammer dat ik ook 'maar' iets van 9500 3dmarks scoor, terwijl ik een Athlon x2 6000+ heb..

Heb jij misschien meer ram?(2gig) Of heb je het een en ander gewoon getweaked?

A.F.C. Ajax

Is de driver-ondersteuning voor Vista al optimaal? Las ergens dat het nog steeds niet helemaal geweldig was.quote:Op maandag 27 augustus 2007 18:32 schreef SoupNazi het volgende:

[..]

Dat is zeer netjes. Ik heb ook 2 gieg, maar ik had mijn videokaart wel een stuk hoger dan standaard draaien. Helaas zit nu op een clean install van Vista en krijg ik hem niet eens meer over de 8700 heen met dezelfde clocks, en met dezelfde (163.11) drivers. Duizend punten lager dus. Iemand enig idee waar dit aan kan liggen?

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Ik haal met een testsyteem bestaande uit een: E4500 op 3Ghz, een P5B, MSI 8800GTS (650/2000) en 2 gig 800Mhz Corsair ram rond de 11.000. Da's met XP en de laatste beta-driver.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Die 9700 was ook gewoon op Vista, dus dat zou geen verschil moeten maken.quote:Op maandag 27 augustus 2007 18:52 schreef Biogarde het volgende:

[..]

Is de driver-ondersteuning voor Vista al optimaal? Las ergens dat het nog steeds niet helemaal geweldig was.

A.F.C. Ajax

Na even wat research gedaan te hebben:

Hoe lang zal het duren voordat er games verschijnen die directx 10 only zijn? Of directx 10.1 only (dus niet meer onder directx 9 draaien)?

Crysis is bijvoorbeeld weliswaar een directx 10 spel, echter deze draait zover ik begrepen heb ook gewoon onder directx 9.

Aangezien in tegenstelling tot directx 9, directx 10 niet meer backwards compatible is en directx 10.1 niet meer backwards compatible is (met directx 10), is dus mijn vraag over hoeveel jaar dat is (2 jaar, 3 jaar, 4 jaar?)

Als iemand daar ook een bron bij heeft, zou het helemaal top zijn

Hoe lang zal het duren voordat er games verschijnen die directx 10 only zijn? Of directx 10.1 only (dus niet meer onder directx 9 draaien)?

Crysis is bijvoorbeeld weliswaar een directx 10 spel, echter deze draait zover ik begrepen heb ook gewoon onder directx 9.

Aangezien in tegenstelling tot directx 9, directx 10 niet meer backwards compatible is en directx 10.1 niet meer backwards compatible is (met directx 10), is dus mijn vraag over hoeveel jaar dat is (2 jaar, 3 jaar, 4 jaar?)

Als iemand daar ook een bron bij heeft, zou het helemaal top zijn

Ehm... ok

Ik denk zelf dat DX10(1) pas over een jaar of anderhalf mainstream is. En ik denk dat we over 4 jaar een aantal versie's verder zijn, omdat ze steeds sneller kaarten uitbrengen die de volgende generatie DX ook al ondersteunen.quote:Op dinsdag 28 augustus 2007 01:24 schreef Frumzel het volgende:

Na even wat research gedaan te hebben:

Hoe lang zal het duren voordat er games verschijnen die directx 10 only zijn? Of directx 10.1 only (dus niet meer onder directx 9 draaien)?

Crysis is bijvoorbeeld weliswaar een directx 10 spel, echter deze draait zover ik begrepen heb ook gewoon onder directx 9.

Aangezien in tegenstelling tot directx 9, directx 10 niet meer backwards compatible is en directx 10.1 niet meer backwards compatible is (met directx 10), is dus mijn vraag over hoeveel jaar dat is (2 jaar, 3 jaar, 4 jaar?)

Als iemand daar ook een bron bij heeft, zou het helemaal top zijn

Voorlopig blijft het gros op 9 hangen ivm de overstap naar Vista. Een hoop mensen blijven voorlopig (aantal jaar) op XP hangen als ik de diverse fora mag geloven.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Mja, waar ik eigenlijk op doelde:quote:Op dinsdag 28 augustus 2007 01:27 schreef Biogarde het volgende:

[..]

Ik denk zelf dat DX10(1) pas over een jaar of anderhalf mainstream is. En ik denk dat we over 4 jaar een aantal versie's verder zijn, omdat ze steeds sneller kaarten uitbrengen die de volgende generatie DX ook al ondersteunen.

Voorlopig blijft het gros op 9 hangen ivm de overstap naar Vista. Een hoop mensen blijven voorlopig (aantal jaar) op XP hangen als ik de diverse fora mag geloven.

Ik heb nu nog een Geforce 4. Met deze kaart (volgens mij ontworpen voor direct 7x of 8 (daar wil ik even vanaf zijn)) kan ik zonder problemen moeiteloos een hoop directx 9 spellen mee spellen. Weliswaar op lagere resoluties/instellingen enzo, maar het werkt wel. Maar ik begreep dus dat directx 10.1-spellen niet kunnen worden gespeeld op een directx 10(.0)-kaart.

Maar goed, ik begrijp natuurlijk wel dat het een aantal jaar zal duren, voordat gameproducers een groot aantal spellen maken die niks anders ondersteunen lager dan directx 10.1 (en dat de 88xx serie dus niet werkt i.c.m. die spellen).

Dus nu een 8800 gts kopen bijvoorbeeld en ik kan er zonder problemen weer 3, 4 jaar tegenaan voordat spellen niet meer werken (net zoals spellen met shader model 2.0 bij mij niet willen opstarten met een geforce 4 ti4600).

Ehm... ok

Ik denk dat je nog niet aan DX 10.1 moet denken.

Het duurt nog een tijdje voordat alle spellen alleen op DX 10 draaien laatstaan DX 10.1.

Als je een kaart wilt die 3-4 jaar meegaat moet je denken aan een 8800 ultra denk ik (van rond de 700 euro). Maar ik denk dat een 8800GTS 320mb wel lang meegaat als je kijkt hoelang het duurt voordat de spellen allemaal DX10 ondersteunen.

Het duurt nog een tijdje voordat alle spellen alleen op DX 10 draaien laatstaan DX 10.1.

Als je een kaart wilt die 3-4 jaar meegaat moet je denken aan een 8800 ultra denk ik (van rond de 700 euro). Maar ik denk dat een 8800GTS 320mb wel lang meegaat als je kijkt hoelang het duurt voordat de spellen allemaal DX10 ondersteunen.

Mja, ik zat zelf te denken aan de 640MB versie (o.a. vanwege schermresolutie van 1680x1050). Maar goed, dit haalt me wel over om niet tot november (of later) te wachten. Nu nog even overtuigd zijn van mezelf dat ik het echt wil (geld groeit niet op m'n rug ) en dan maar eens een keer naar de alternate.quote:Op dinsdag 28 augustus 2007 11:42 schreef nigel2 het volgende:

Ik denk dat je nog niet aan DX 10.1 moet denken.

Het duurt nog een tijdje voordat alle spellen alleen op DX 10 draaien laatstaan DX 10.1.

Als je een kaart wilt die 3-4 jaar meegaat moet je denken aan een 8800 ultra denk ik (van rond de 700 euro). Maar ik denk dat een 8800GTS 320mb wel lang meegaat als je kijkt hoelang het duurt voordat de spellen allemaal DX10 ondersteunen.

Ehm... ok

Hmm.. het lijkt er op alsof mijn CPU de bottleneck is (X2 5600+), mijn GTS draait nu op 620/910, en komt tot de 9700. Als ik hem nog verder klok blijft hij zo rond de 9700 zitten. Zijn er nog meer mensen die dit probleem hebben?

A.F.C. Ajax

Wat voor geheugen heb je?quote:Op dinsdag 28 augustus 2007 20:52 schreef SoupNazi het volgende:

Hmm.. het lijkt er op alsof mijn CPU de bottleneck is (X2 5600+), mijn GTS draait nu op 620/910, en komt tot de 9700. Als ik hem nog verder klok blijft hij zo rond de 9700 zitten. Zijn er nog meer mensen die dit probleem hebben?

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Corsair TwinX XMS2 6400 2 GB (4-4-4-12)quote:

Ik heb nu mijn processor op 2850 mhz draaien ipv 2800, en mijn 3DMark-score is meteen van 9700 naar 9860 gegaan, dus probleem opgelost.

A.F.C. Ajax

Ah, ik heb hetzelfde geheugen in dit systeem. Is ook redelijk te overclocken.quote:Op dinsdag 28 augustus 2007 21:18 schreef SoupNazi het volgende:

[..]

Corsair TwinX XMS2 6400 2 GB (4-4-4-12)

Ik heb nu mijn processor op 2850 mhz draaien ipv 2800, en mijn 3DMark-score is meteen van 9700 naar 9860 gegaan, dus probleem opgelost.

Heb je die rambankjes wel in Dual-channel geplaatst? Scheelt ook weer iets.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Uiteraard. Hoever heb je ze overgeclockt (timings/voltage/freq)?quote:Op dinsdag 28 augustus 2007 21:20 schreef Biogarde het volgende:

[..]

Ah, ik heb hetzelfde geheugen in dit systeem. Is ook redelijk te overclocken.

Heb je die rambankjes wel in Dual-channel geplaatst? Scheelt ook weer iets.

A.F.C. Ajax

Niet.quote:Op dinsdag 28 augustus 2007 21:39 schreef SoupNazi het volgende:

[..]

Uiteraard. Hoever heb je ze overgeclockt (timings/voltage/freq)?

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Yes.quote:Op dinsdag 28 augustus 2007 22:06 schreef SoupNazi het volgende:

[..]

Ah ok. Je hebt ze wel op 4-4-4-12 gezet hoop ik? De timings waarop ze horen?

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Mooi.quote:

Mijn videokaart draait nu op 630/1850, en processor op 2960mhz. En hiermee kom ik op 10030 punten uit, dus dat is voorlopig wel voldoende.

A.F.C. Ajax

Beetje moeilijk discussieren zonder goede benchmark...punker *proest*

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

3Dmark 06 is alleen geen goede benchmark.quote:Op dinsdag 28 augustus 2007 23:13 schreef dikkedorus het volgende:

Beetje moeilijk discussieren zonder goede benchmark...punker *proest*

DX10.1 is echt drie keer niets nieuws. Als het ooit wordt gebruikt zullen de games gemakkelijk BC kunnen draaien.

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

Grote gamemakers houden 't voorlopig nog bij DX9.quote:Op dinsdag 28 augustus 2007 23:49 schreef dikkedorus het volgende:

DX10.1 is echt drie keer niets nieuws. Als het ooit wordt gebruikt zullen de games gemakkelijk BC kunnen draaien.

http://core.tweakers.net/nieuws/49104/Valve:-DirectX-10-is-nog-nergens-voor-nodig.html

Dus omdat Valve zegt dat DirectX10 nog niet nodig is houden alle grote game-makers het voorlopig nog bij DX9.quote:Op dinsdag 28 augustus 2007 23:51 schreef schvvmert het volgende:

[..]

Grote gamemakers houden 't voorlopig nog bij DX9.

http://core.tweakers.net/nieuws/49104/Valve:-DirectX-10-is-nog-nergens-voor-nodig.html

A.F.C. Ajax

DX10 is heel krachtig, moet je alleen wel de ballen hebben om een DX10-only pipeline met geoshaders te maken.

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

Weet je een betere?quote:Op dinsdag 28 augustus 2007 23:15 schreef schvvmert het volgende:

[..]

3Dmark 06 is alleen geen goede benchmark.

A.F.C. Ajax

Goed benchmarken is niet 1 tool voor, dat doe je met verschillende proggies. 3Dmark is er 1 van.quote:

Klinkt stoer maar zolang 90% nog een DX9 kaart heeft en de vraag is hoe goed de nieuwste DX10 kaarten zijn dan blijft elke game ontwikkelaar zeker DX9 versie ook uitbrengen.quote:Op dinsdag 28 augustus 2007 23:55 schreef dikkedorus het volgende:

DX10 is heel krachtig, moet je alleen wel de ballen hebben om een DX10-only pipeline met geoshaders te maken.

Het zal nog wel even duren idd. Het is wachten op een goede DX10 engine

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

Crysis?quote:Op woensdag 29 augustus 2007 00:38 schreef dikkedorus het volgende:

Het zal nog wel even duren idd. Het is wachten op een goede DX10 engine

A.F.C. Ajax

Doe het dan ook met een fatsoenlijke benchmark. Aan 3dmark heb je 0,0 , het is namelijk veelste systeem afhankelijk. Het test niet alleen je graka of alleen je CPU. Het test de combinatie ervan.quote:Op dinsdag 28 augustus 2007 23:13 schreef dikkedorus het volgende:

Beetje moeilijk discussieren zonder goede benchmark...punker *proest*

Je hebt helemaal gelijk, met spellen gebruik je namelijk ook alleen je videokaart of alleen je CPU, nooit samen.quote:Op woensdag 29 augustus 2007 08:28 schreef punkjunk het volgende:

[..]

Doe het dan ook met een fatsoenlijke benchmark. Aan 3dmark heb je 0,0 , het is namelijk veelste systeem afhankelijk. Het test niet alleen je graka of alleen je CPU. Het test de combinatie ervan.

A.F.C. Ajax

Je gebruikt toch ook je hele systeem om een spel te spelen Ik wel, tenminste.quote:Op woensdag 29 augustus 2007 08:28 schreef punkjunk het volgende:

[..]

Doe het dan ook met een fatsoenlijke benchmark. Aan 3dmark heb je 0,0 , het is namelijk veelste systeem afhankelijk. Het test niet alleen je graka of alleen je CPU. Het test de combinatie ervan.

V.

Ja inderdaad, V. ja.

En DX10 is ook onder XP te doen?quote:Op dinsdag 28 augustus 2007 01:27 schreef Biogarde het volgende:

Voorlopig blijft het gros op 9 hangen ivm de overstap naar Vista. Een hoop mensen blijven voorlopig (aantal jaar) op XP hangen als ik de diverse fora mag geloven.

V.

Ja inderdaad, V. ja.

Nee.quote:Op woensdag 29 augustus 2007 09:54 schreef Verbal het volgende:

[..]

En DX10 is ook onder XP te doen?

V.

I have the cape. I make the fucking Whoosh noise.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Crysis draait nog steeds een DX9 pipeline ernaast dacht ik? Dus ze kunnen te al te gekke DX10 dingen inbouwen zonder letterlijk twee verschillende engines te schrijven. Het zag er igg niet heel erg boeiend uit. Crysis hangt meer op physics en goede culling/LoD, niet op grafische effecten.quote:

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

Ik ben nu met Lost Planet bezig. Beetje jammerlijk. Ziet er netjes uit, maar qua gameplay een beetje bagger. Zowel de GTS als de GTX trekken het makkelijk btw.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Draait ook zeer goed in DX10. Maar omdat de omgeving erg druk is, zijn de verschillen die opvallen erg minimaal. Videokaart heeft het er wel een stuk drukker mee iig

Kaarten beginnen gewoon te piepen/krijsen

Kaarten beginnen gewoon te piepen/krijsen

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

In het bezit van de 8800 GTX 768mb werkt uitstekend!

"Strange times are these in which we live

when old and young are taught in falsehoods school.

And the one man that dares to tell the truth is called at once a lunatic and fool"

when old and young are taught in falsehoods school.

And the one man that dares to tell the truth is called at once a lunatic and fool"

We weten wel hoeveel geheugen die kaart heeft hoorquote:Op woensdag 29 augustus 2007 14:18 schreef Killaht het volgende:

In het bezit van de 8800 GTX 768mb werkt uitstekend!

[nerd modus] En het is geen 768 millibit [/nerd modus]

I have the cape. I make the fucking Whoosh noise.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Bij spellen gebruik je het wel, maar op een hele andere manier. Bij spellen kun je met een gare CPU maar een dikke graka en veel ram nog veel FPS halen terwijl dat in 3dmark niet mogelijk is. Vandaar.quote:Op woensdag 29 augustus 2007 09:02 schreef SoupNazi het volgende:

[..]

Je hebt helemaal gelijk, met spellen gebruik je namelijk ook alleen je videokaart of alleen je CPU, nooit samen.

3DMark benched wel het gemiddelde van wat games vragen qua systeem-eisen.quote:Op woensdag 29 augustus 2007 17:23 schreef punkjunk het volgende:

[..]

Bij spellen gebruik je het wel, maar op een hele andere manier. Bij spellen kun je met een gare CPU maar een dikke graka en veel ram nog veel FPS halen terwijl dat in 3dmark niet mogelijk is. Vandaar.

Ze geven een beeld hoe ver je kunt gaan qua games en je huidige systeem.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Nogal wat onzin wat je vertelt. Verder mag je het ook wel onderbouwen met wat voorbeelden, want ik ben erg nieuwsgierig waarop je dit baseert.quote:Op woensdag 29 augustus 2007 17:23 schreef punkjunk het volgende:

[..]

Bij spellen gebruik je het wel, maar op een hele andere manier. Bij spellen kun je met een gare CPU maar een dikke graka en veel ram nog veel FPS halen terwijl dat in 3dmark niet mogelijk is. Vandaar.

A.F.C. Ajax

Als ik game op een P4 of een C2D dan scheelt dat 30 frames met gemak.

Zelfde systeem op de CPU na.

Zelfde systeem op de CPU na.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Nu geef je ook gelijk 2 extremen heh, dat is niet eerlijk. Terwijl wanneer je tussen een budget en een 6600 C2D een 3dmark zou draaien je een vreselijk ongelijke score zou krijgen terwijl het in game een klein aantal fps scheeld.quote:Op woensdag 29 augustus 2007 17:46 schreef Biogarde het volgende:

Als ik game op een P4 of een C2D dan scheelt dat 30 frames met gemak.

Zelfde systeem op de CPU na.

Van 3dmark is het algemeen bekend dat het héél erg cpu gerelateerd is wat voor scoren je krijgt, daar hoef ik geen voorbeelden van te geven.quote:Op woensdag 29 augustus 2007 17:43 schreef SoupNazi het volgende:

[..]

Nogal wat onzin wat je vertelt. Verder mag je het ook wel onderbouwen met wat voorbeelden, want ik ben erg nieuwsgierig waarop je dit baseert.

Even iets leuks te melden (als het spam is, modereer het dan maar weg), maar zag bij Alternate een XFX 8800GTS 320MB te koop mét de game Lost Planet. Echter nu baal ik daar wel van, want ik wil juist de 640MB versie (die ook nog eens ¤100,= duurder is).

Nou is mijn vraag ook, zit zo'n game in de verpakking of wordt dat er los bij gegeven? (aangezien dit volgens mij enkel dus bij Alternate is) en kan je bij zo'n shop afdingen of ik dat spel ook kan krijgen bij de 640MB versie?

Nou is mijn vraag ook, zit zo'n game in de verpakking of wordt dat er los bij gegeven? (aangezien dit volgens mij enkel dus bij Alternate is) en kan je bij zo'n shop afdingen of ik dat spel ook kan krijgen bij de 640MB versie?

Ehm... ok

Alle CPU's VOOR de C2D zijn al budget. Zou niet weten met wat ik het anders moet vergelijken.quote:Op woensdag 29 augustus 2007 17:49 schreef punkjunk het volgende:

[..]

Nu geef je ook gelijk 2 extremen heh, dat is niet eerlijk. Terwijl wanneer je tussen een budget en een 6600 C2D een 3dmark zou draaien je een vreselijk ongelijke score zou krijgen terwijl het in game een klein aantal fps scheeld.

[..]

Van 3dmark is het algemeen bekend dat het héél erg cpu gerelateerd is wat voor scoren je krijgt, daar hoef ik geen voorbeelden van te geven.

Er zijn games waar je idd het verschil niet merkt. Maar de HUIDIGE games adviseren als minimale eis een C2D omdat je van alle eye-candy gebruik kunt maken. Kijk, doom 3 loopt op een Pentium 3 zelfs soepel

Maar qua renderen van frames zit je beter met een C2D omdat deze veel meer kan berekenen dan een singlecore.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Waarom de 640 versie? De MSI OC versie (320) is veel sneller dan die 640 versie.quote:Op woensdag 29 augustus 2007 17:52 schreef Frumzel het volgende:

Even iets leuks te melden (als het spam is, modereer het dan maar weg), maar zag bij Alternate een XFX 8800GTS 320MB te koop mét de game Lost Planet. Echter nu baal ik daar wel van, want ik wil juist de 640MB versie (die ook nog eens ¤100,= duurder is).

Nou is mijn vraag ook, zit zo'n game in de verpakking of wordt dat er los bij gegeven? (aangezien dit volgens mij enkel dus bij Alternate is) en kan je bij zo'n shop afdingen of ik dat spel ook kan krijgen bij de 640MB versie?

640 is alleen hendig wanneer je op hoge resolutie gaat gamen. Alles vanaf de 24".

Ga je op hoge reso gamen?

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Mja, dat is juist het lastige. Maximale resolutie van mijn scherm is 1680x1050. En wil wel even doen met de kaartquote:Op woensdag 29 augustus 2007 17:55 schreef Biogarde het volgende:

[..]

Waarom de 640 versie? De MSI OC versie (320) is veel sneller dan die 640 versie.

640 is alleen hendig wanneer je op hoge resolutie gaat gamen. Alles vanaf de 24".

Ga je op hoge reso gamen?

Maar die 640 van XFX is toch ook over te klokken?

Ehm... ok

Dan heb je in feite niks aan de 640-versie. 320 trekt het makkelijk.quote:Op woensdag 29 augustus 2007 17:57 schreef Frumzel het volgende:

[..]

Mja, dat is juist het lastige. Maximale resolutie van mijn scherm is 1680x1050. En wil wel even doen met de kaart

Je hebt sowieso lang zat wat aan die kaart, want DX10 zal nog lang niet mainstream worden

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Ja, maar dan is ie nog steeds niet sneller. Alleen meer geheugen (buffer).quote:Op woensdag 29 augustus 2007 17:57 schreef Frumzel het volgende:

[..]

Mja, dat is juist het lastige. Maximale resolutie van mijn scherm is 1680x1050. En wil wel even doen met de kaart

Maar die 640 van XFX is toch ook over te klokken?

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Ik lees op diverse fora dat een 640MB wordt aangeraden vanaf een resolutie van 1280x1024. Maar aan de andere kant, het scheelt wel 100 ¤uries...quote:Op woensdag 29 augustus 2007 17:59 schreef Biogarde het volgende:

[..]

Dan heb je in feite niks aan de 640-versie. 320 trekt het makkelijk.

Je hebt sowieso lang zat wat aan die kaart, want DX10 zal nog lang niet mainstream worden

Dilemma!

Ehm... ok

Het is het verschil 100% niet waard.quote:Op woensdag 29 augustus 2007 18:05 schreef Frumzel het volgende:

[..]

Ik lees op diverse fora dat een 640MB wordt aangeraden vanaf een resolutie van 1280x1024. Maar aan de andere kant, het scheelt wel 100 ¤uries...

Dilemma!

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Ik bedoel een 6600 tov bijvoorbeeld een 6200.quote:Op woensdag 29 augustus 2007 17:53 schreef Biogarde het volgende:

[..]

Alle CPU's VOOR de C2D zijn al budget. Zou niet weten met wat ik het anders moet vergelijken.

Er zijn games waar je idd het verschil niet merkt. Maar de HUIDIGE games adviseren als minimale eis een C2D omdat je van alle eye-candy gebruik kunt maken. Kijk, doom 3 loopt op een Pentium 3 zelfs soepel

Maar qua renderen van frames zit je beter met een C2D omdat deze veel meer kan berekenen dan een singlecore.

Je bedoelt dat het verschil in snelheid van een stock 320MB-oc of een 640MB (zelf oc) in het voordeel is van de stock 320MB-oc is? Of bazel ik nu maar wat?quote:Op woensdag 29 augustus 2007 17:59 schreef Biogarde het volgende:

[..]

Ja, maar dan is ie nog steeds niet sneller. Alleen meer geheugen (buffer).

Ehm... ok

Niet die 100 euro dus...quote:Op woensdag 29 augustus 2007 18:06 schreef Biogarde het volgende:

[..]

Het is het verschil 100% niet waard.

Ehm... ok

Die 320 is in veel gevallen sneller. Zelfs stock en zelfs wanneer die 640 is overclocked en die 320 niet.quote:Op woensdag 29 augustus 2007 18:09 schreef Frumzel het volgende:

[..]

Je bedoelt dat het verschil in snelheid van een stock 320MB-oc of een 640MB (zelf oc) in het voordeel is van de stock 320MB-oc is? Of bazel ik nu maar wat?

320 is in veel gevallen dus in het voordeel.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

http://www23.tomshardware.com/graphics_2007.html?modelx=33&model1=707&model2=778&chart=318

Dit als overall genomen. Je kan ook per game kiezen. Dan zal je zien dat die 320 op stock sneller is.

En zelfs sneller dan dat pareltje ( ) van ATI. Die 2900

Gaan we nu bier drinken van die ¤100 die je in je zak houdt?

Dit als overall genomen. Je kan ook per game kiezen. Dan zal je zien dat die 320 op stock sneller is.

En zelfs sneller dan dat pareltje ( ) van ATI. Die 2900

Gaan we nu bier drinken van die ¤100 die je in je zak houdt?

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Wat apart. Waar ligt dat eigenlijk aan?quote:Op woensdag 29 augustus 2007 18:15 schreef Biogarde het volgende:

[..]

Die 320 is in veel gevallen sneller. Zelfs stock en zelfs wanneer die 640 is overclocked en die 320 niet.

320 is in veel gevallen dus in het voordeel.

-edit-

Oeps, had je 2e post nog niet gelezen Nu wel

Ehm... ok

Tjonge, die 320MB is écht in veel gevallen sneller. Thx! Die grafieken had ik nog niet gezien.quote:Op woensdag 29 augustus 2007 18:17 schreef Biogarde het volgende:

http://www23.tomshardware.com/graphics_2007.html?modelx=33&model1=707&model2=778&chart=318

Dit als overall genomen. Je kan ook per game kiezen. Dan zal je zien dat die 320 op stock sneller is.

En zelfs sneller dan dat pareltje ( ) van ATI. Die 2900

Gaan we nu bier drinken van die ¤100 die je in je zak houdt?

Mijn keus is wel gemaakt. En jij raad MSI (de oc-versie) aan? Of maakt het niet zoveel verder?

(Tja, je kan er wel heel veel bier voor kopen ja... )

-edit-

Overigens dat ATI flink achterbleef, had ik al wel begrepen

Ehm... ok

Die MSI OC versie geeft iets meer weg dan een gewone versie. Die KO-versie van EVGA is ook uber btw.quote:Op woensdag 29 augustus 2007 18:27 schreef Frumzel het volgende:

[..]

Tjonge, die 320MB is écht in veel gevallen sneller. Thx! Die grafieken had ik nog niet gezien.

Mijn keus is wel gemaakt. En jij raad MSI (de oc-versie) aan? Of maakt het niet zoveel verder?

(Tja, je kan er wel heel veel bier voor kopen ja... )

-edit-

Overigens dat ATI flink achterbleef, had ik al wel begrepen

Beide kaarten draaien met gemak 650Mhz op de GPU en 2000 Mhz op het geheugen.

Ze hebben simpelweg 9 van de 10 keer iets meer overclockruimte dan bijvoorbeeld een standaard XFX.

Ik heb het iig nog nooit voor elkaar gekregen om een normale versie op 650/2000 te laten lopen zonder dat je een ei kan bakken op de kaart

En daar komt bij dat ze NIET stabiel draaien en dus vastlopen.

Kaarten worden btw met gemak 70 a 80 graden in games. Overclocked. Zorg dus wel voor voldoende afzuiging en airflow in je kast.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

EVGA KO-version:

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Hmmm, die is wel de duurste van allemaalquote:

En de MSI is bij de winkel waar ik 'm wil kopen uitverkocht

Ehm... ok

Bij resoluties >1280x1024 is de 640-versie wel degelijk beter, zeker als AA ook nog aangezet wordt.quote:Op woensdag 29 augustus 2007 17:59 schreef Biogarde het volgende:

[..]

Dan heb je in feite niks aan de 640-versie. 320 trekt het makkelijk.

Je hebt sowieso lang zat wat aan die kaart, want DX10 zal nog lang niet mainstream worden

A.F.C. Ajax

Dezequote:Op woensdag 29 augustus 2007 18:53 schreef SoupNazi het volgende:

[..]

Bij resoluties >1280x1024 is de 640-versie wel degelijk beter, zeker als AA ook nog aangezet wordt.

link zegt dus anders...quote:

Of moet ik dat niet serieus nemen dan?

(Enkel in 3dmark06 geeft de 640MB meer punten en in sommige spellen met resoluties hoger dan 1600x1200, maar dat verschil (1 a 2 fps) is mij toch geen 50 tot 75 euro verschil waard met een 320MB oc versie... )

Ehm... ok

Hmm, de 8500 GT (512MB) is qua 3Dwerk eigenlijk best wel het mongoloïde broertje van de rest van de serie

en een standaard overclockte XFX? (die is namelijk wel weer snel binnen bij Alternate als ik de "voorraadtijd" mag geloven).quote:Op woensdag 29 augustus 2007 18:33 schreef Biogarde het volgende:

[..]

Die MSI OC versie geeft iets meer weg dan een gewone versie. Die KO-versie van EVGA is ook uber btw.

Beide kaarten draaien met gemak 650Mhz op de GPU en 2000 Mhz op het geheugen.

Ze hebben simpelweg 9 van de 10 keer iets meer overclockruimte dan bijvoorbeeld een standaard XFX.

Ik heb het iig nog nooit voor elkaar gekregen om een normale versie op 650/2000 te laten lopen zonder dat je een ei kan bakken op de kaart

En daar komt bij dat ze NIET stabiel draaien en dus vastlopen.

Kaarten worden btw met gemak 70 a 80 graden in games. Overclocked. Zorg dus wel voor voldoende afzuiging en airflow in je kast.

Ehm... ok

Die is ook goed.quote:Op woensdag 29 augustus 2007 19:09 schreef Frumzel het volgende:

[..]

en een standaard overclockte XFX? (die is namelijk wel weer snel binnen bij Alternate als ik de "voorraadtijd" mag geloven).

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Qua frames te verwaarlozen en die ¤100 echt niet waard.quote:Op woensdag 29 augustus 2007 18:53 schreef SoupNazi het volgende:

[..]

Bij resoluties >1280x1024 is de 640-versie wel degelijk beter, zeker als AA ook nog aangezet wordt.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Oh okquote:

Das mooi, want daar krijg je ook nog het spel Ghost Recon bij

(niet dat het me persé daar om gaat, maar is wel mooi mee genomen )

[ Bericht 2% gewijzigd door Frumzel op 29-08-2007 19:33:19 ]

Ehm... ok

Idd juist het leukste pakketje nemen.quote:Op woensdag 29 augustus 2007 19:21 schreef Frumzel het volgende:

[..]

Oh ok

Das mooi, want daar krijg je ook nog het spel Ghost Recon bij

(niet dat het me persé daar om gaat, maar is wel mooi mee genomen )

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

In die benchmarks van Tom's Hardware is inderdaad bijna geen verschil gezien, maar ik meen er toch echt aardig wat gezien te hebben waarin er op hogere resoluties veel verschil in zat.quote:Op woensdag 29 augustus 2007 19:13 schreef Biogarde het volgende:

[..]

Qua frames te verwaarlozen en die ¤100 echt niet waard.

A.F.C. Ajax

In DX10 wellicht.quote:Op woensdag 29 augustus 2007 19:36 schreef SoupNazi het volgende:

[..]

In die benchmarks van Tom's Hardware is inderdaad bijna geen verschil gezien, maar ik meen er toch echt aardig wat gezien te hebben waarin er op hogere resoluties veel verschil in zat.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Deze grafiek is apart. De beide GTS en de 7900GTX presteren beter dan de 8800GTX? . Weliswaar een halve frame p/s, maar verschil is er dus amper tot niet?

Ehm... ok

Nope. P4 hier en ik kreeg het niet fatsoenlijk lopend.quote:Op woensdag 29 augustus 2007 17:53 schreef Biogarde het volgende:

Kijk, doom 3 loopt op een Pentium 3 zelfs soepel

V.

Ja inderdaad, V. ja.

Er zijn games zat waar budgetkaarten beter weten te presteren dan high-end zoals de Ultraquote:Op woensdag 29 augustus 2007 19:50 schreef Frumzel het volgende:

Deze grafiek is apart. De beide GTS en de 7900GTX presteren beter dan de 8800GTX? . Weliswaar een halve frame p/s, maar verschil is er dus amper tot niet?

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

P3 icm met (laten we gek doen) een GTS.quote:Op woensdag 29 augustus 2007 19:53 schreef Verbal het volgende:

[..]

Nope. P4 hier en ik kreeg het niet fatsoenlijk lopend.

V.

Bij wijze van.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Heb jij nou al een nieuwe kaart of is gij nog aan het sparen voor de nieuwe generatie?

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Ik kreeg het op mijn 8800GTX en C2D E6600 zelfs niet fatsoenlijk lopendquote:Op woensdag 29 augustus 2007 19:53 schreef Verbal het volgende:

[..]

Nope. P4 hier en ik kreeg het niet fatsoenlijk lopend.

V.

I have the cape. I make the fucking Whoosh noise.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

quote:Op woensdag 29 augustus 2007 20:12 schreef Merovingian het volgende:

[..]

Ik kreeg het op mijn 8800GTX en C2D E6600 zelfs niet fatsoenlijk lopend

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Serieus... Zal wel aan de drivers hebben gelegen, was december 2006, of misschien januari 2007. Maar toch, ik kreeg er met 1280*1024 met settings op medium niet meer dan 20 fps uitquote:

Volgens mij lag het aan de shadows... Binnenkort maar weer eens opnieuw installeren en kijken wat ie doet.

I have the cape. I make the fucking Whoosh noise.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Doom3 -> OpenGL -> problemen

Vooral onder Vista moet je geen Doom3 willen spelen (tenzij je drivers zelf openGL wrappen of hacken)

Vooral onder Vista moet je geen Doom3 willen spelen (tenzij je drivers zelf openGL wrappen of hacken)

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

Ik denk dat het nu echt wel zou lukken hoor.quote:Op woensdag 29 augustus 2007 20:31 schreef Merovingian het volgende:

[..]

Serieus... Zal wel aan de drivers hebben gelegen, was december 2006, of misschien januari 2007. Maar toch, ik kreeg er met 1280*1024 met settings op medium niet meer dan 20 fps uit

Volgens mij lag het aan de shadows... Binnenkort maar weer eens opnieuw installeren en kijken wat ie doet.

A.F.C. Ajax

Argh. Toch nog dilemma

Zit nog steeds te twisten met mezelf of ik vandaag ga en dan voor de XFX 8800GTS op 500Mhz (standaard dus) voor ¤259,= mét het spel Lost Planet of tot morgen moet wachten en dan gaan voor de ¤40,= of ¤60,= duurdere XFX 8800GTS op 560Mhz of de XXX-versie op 580Mhz (standaard overklokt dus). Maar goed, bij die laatste krijg je géén Lost Planet erbij (net nagevraagd).

Ik bedoel dus, is het 't wachten en die 40 tot 60 euro wérkelijk waard?

En zelf overklokken moet toch ook lukken, ook al krijg je 'm dan niet zo hoog als de standaard overclockte versies dat zouden kunnen (waarbij ie mij dan standaard overklokt toch wel snel genoeg is).

Zit nog steeds te twisten met mezelf of ik vandaag ga en dan voor de XFX 8800GTS op 500Mhz (standaard dus) voor ¤259,= mét het spel Lost Planet of tot morgen moet wachten en dan gaan voor de ¤40,= of ¤60,= duurdere XFX 8800GTS op 560Mhz of de XXX-versie op 580Mhz (standaard overklokt dus). Maar goed, bij die laatste krijg je géén Lost Planet erbij (net nagevraagd).

Ik bedoel dus, is het 't wachten en die 40 tot 60 euro wérkelijk waard?

En zelf overklokken moet toch ook lukken, ook al krijg je 'm dan niet zo hoog als de standaard overclockte versies dat zouden kunnen (waarbij ie mij dan standaard overklokt toch wel snel genoeg is).

Ehm... ok

Ik zou de XXX versie nemen en Lost Planet downloaden

I have the cape. I make the fucking Whoosh noise.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Mja, dat kan wel, maar die is wel 60 euro duurder dus...quote:Op donderdag 30 augustus 2007 13:06 schreef Merovingian het volgende:

Ik zou de XXX versie nemen en Lost Planet downloaden

downloaden heb ik sowieso geen problemen mee daarentegen, maar tis mooi meegenomen hè

Ehm... ok

Gewoon de goedkopere nemen en dan overclocken.quote:Op donderdag 30 augustus 2007 13:00 schreef Frumzel het volgende:

Argh. Toch nog dilemma

Zit nog steeds te twisten met mezelf of ik vandaag ga en dan voor de XFX 8800GTS op 500Mhz (standaard dus) voor ¤259,= mét het spel Lost Planet of tot morgen moet wachten en dan gaan voor de ¤40,= of ¤60,= duurdere XFX 8800GTS op 560Mhz of de XXX-versie op 580Mhz (standaard overklokt dus). Maar goed, bij die laatste krijg je géén Lost Planet erbij (net nagevraagd).

Ik bedoel dus, is het 't wachten en die 40 tot 60 euro wérkelijk waard?

En zelf overklokken moet toch ook lukken, ook al krijg je 'm dan niet zo hoog als de standaard overclockte versies dat zouden kunnen (waarbij ie mij dan standaard overklokt toch wel snel genoeg is).

A.F.C. Ajax

Wanneer komt de opvolger van de 8800 moet een upgrade hebben ?

I'm sick of all this pooping stuff i'm getting my buttcheeks pierced together .

Er wordt gesproken over november. Maar dat zal inderdaad wel volgend jaar worden...quote:Op donderdag 30 augustus 2007 13:58 schreef Steve-O het volgende:

Wanneer komt de opvolger van de 8800 moet een upgrade hebben ?

Ehm... ok

Hmm dan wacht ik maar ff mijn 9800 doet het immers al 3 primaquote:Op donderdag 30 augustus 2007 14:08 schreef Frumzel het volgende:

[..]

Er wordt gesproken over november. Maar dat zal inderdaad wel volgend jaar worden...

I'm sick of all this pooping stuff i'm getting my buttcheeks pierced together .

En dan te bedenken dat ze na deze serie bij Nvidia overtappen op de 9800 seriequote:Op donderdag 30 augustus 2007 14:24 schreef Steve-O het volgende:

[..]

Hmm dan wacht ik maar ff mijn 9800 doet het immers al 3 prima

Heb je weer een 9800

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

En dan verkoop ik mijn oude ATi 9800 op Marktplaats voor het geld van een NVidia 9800. Vast wel iemand die erin trapt.

Ik ben aan het wachten op een kleine financiële injectie die ik een dezer dagen ontvang. En dan ga ik mij op het grootste gemak goed oriënteren op wat ik wil: een behoorlijk geoutfitte computer met een 8800 GTS opdat ik straks lekker kan Crysisen, of -hernieuwde mogelijkheid- een klein, fijn laptopje, waarop ik niet echt kan gamen, maar waar ik wel een hoop andere dingen mee kan.quote:Op woensdag 29 augustus 2007 20:00 schreef Biogarde het volgende:

Heb jij nou al een nieuwe kaart of is gij nog aan het sparen voor de nieuwe generatie?

Keuzes, keuzes.

Maar da's offtopic.

V.

Ja inderdaad, V. ja.

Zo, besteld

Toch maar even wachten dus en gekozen voor de MSI-oplossing (¤270,=)

(Zal dan wel helaas pas minimaal maandag worden vrees ik, maar goed...)

Toch maar even wachten dus en gekozen voor de MSI-oplossing (¤270,=)

(Zal dan wel helaas pas minimaal maandag worden vrees ik, maar goed...)

Ehm... ok

Wachten.quote:Op donderdag 30 augustus 2007 18:36 schreef Frumzel het volgende:

Zo, besteld

Toch maar even wachten dus en gekozen voor de MSI-oplossing (¤270,=)

(Zal dan wel helaas pas minimaal maandag worden vrees ik, maar goed...)

A.F.C. Ajax

Och, morgen ga ik m'n voeding, geheugen en CPU-koeler halen in Ridderkerk, dus dan kan ik die vast mooi zo bij elkaar leggenquote:

Ehm... ok

Alternate. Mooie winkel. Neem wel ff de tijd, want het is daar altijd drukquote:Op donderdag 30 augustus 2007 22:31 schreef Frumzel het volgende:

[..]

Och, morgen ga ik m'n voeding, geheugen en CPU-koeler halen in Ridderkerk, dus dan kan ik die vast mooi zo bij elkaar leggen

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Ik ben er even geleden geweest. Op een zaterdag...quote:Op donderdag 30 augustus 2007 23:05 schreef Biogarde het volgende:

[..]

Alternate. Mooie winkel. Neem wel ff de tijd, want het is daar altijd druk

Ik ga morgenochtend wel

Ehm... ok

uhhm bij alternate heb je nu een aanbieding Intel® Core 2 Quad Q6600 voor 259 euro klopt dat wel?

Want je hebt een core 2 duo E6600 voor 219 euro dacht ik en nu ineens voor 40 euro meer een quad core.

En dat spel lost planet die je bij de 8800gts krijgt is dat wel een mooi en leuk spel?

Want je hebt een core 2 duo E6600 voor 219 euro dacht ik en nu ineens voor 40 euro meer een quad core.

En dat spel lost planet die je bij de 8800gts krijgt is dat wel een mooi en leuk spel?

Prijzen kloppen gewoon hoor! Een quad heeft nog weinig voordeel tegenover een duo. En ze zijn veel te vlot geweest met releasen.quote:Op vrijdag 31 augustus 2007 14:15 schreef nigel2 het volgende:

uhhm bij alternate heb je nu een aanbieding Intel® Core 2 Quad Q6600 voor 259 euro klopt dat wel?

Want je hebt een core 2 duo E6600 voor 219 euro dacht ik en nu ineens voor 40 euro meer een quad core.

En dat spel lost planet die je bij de 8800gts krijgt is dat wel een mooi en leuk spel?

Als je gewoon een nette processor wil, kijk dan eens naar de E6750. Kost bij Alternate 179 geloof ik. Die kun je ruim overclocken en kan nog jaren mee.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Oke bedankt ik kijk naar de 8800gts.

Maar ik zie dat de E6750 goedkoper is dan de E6600 hoe zit dat precies?

Ik heb een voeding van 500 watt denk je dat een quad core processor en een 8800 de voeding de voeding aankan? Ik heb een acer T660 socket 775 ik zie maar 1 plek voor de processor kan er dan ook z'n quad core in?

alvast bedankt.

Maar ik zie dat de E6750 goedkoper is dan de E6600 hoe zit dat precies?

Ik heb een voeding van 500 watt denk je dat een quad core processor en een 8800 de voeding de voeding aankan? Ik heb een acer T660 socket 775 ik zie maar 1 plek voor de processor kan er dan ook z'n quad core in?

alvast bedankt.

Voeding trekt het wel. En zoals eerder uitgelegd, een quad core is vier processors in één. Deze heeft dus ook maar 1 socket nodig. Anders had het ook geen quad core geheten, maar gewoon vier processors.quote:Op vrijdag 31 augustus 2007 20:38 schreef nigel2 het volgende:

Oke bedankt ik kijk naar de 8800gts.

Maar ik zie dat de E6750 goedkoper is dan de E6600 hoe zit dat precies?

Ik heb een voeding van 500 watt denk je dat een quad core processor en een 8800 de voeding de voeding aankan? Ik heb een acer T660 socket 775 ik zie maar 1 plek voor de processor kan er dan ook z'n quad core in?

alvast bedankt.

I have the cape. I make the fucking Whoosh noise.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Jouw moederboard zal geen quadcore ondersteunen. Ook geen Core2Duo's.quote:Op vrijdag 31 augustus 2007 20:38 schreef nigel2 het volgende:

Oke bedankt ik kijk naar de 8800gts.

Maar ik zie dat de E6750 goedkoper is dan de E6600 hoe zit dat precies?

Ik heb een voeding van 500 watt denk je dat een quad core processor en een 8800 de voeding de voeding aankan? Ik heb een acer T660 socket 775 ik zie maar 1 plek voor de processor kan er dan ook z'n quad core in?

alvast bedankt.

Je bord is gemaakt voor Pentium 4 ondersteuning. En aan een Pentium 4 zou ik sowieso geen al te dikke videokaart hangen omdat dan je videokaart sneller is dan je processor.

Lang verhaal kort: Wil je gaan upgraden, dan zal je moeten uitkijken naar een nieuw moederboard en geheugen.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Voor een 6 a 700 Euro kun je een hele nette PC in elkaar jassen!

En de reden dat die 6750 goedkoper is, is omdat hij een FSb van 1333 heeft tegenover de 1066 van de E6600. 1066 = 'oude' chipset (p965) en 1333 is de nieuwe variant (P35).

En aangezien fabrikanten waarschijnlijk liever zien dat je zo snel mogelijk met de meute meeloopt, maken ze die goedkoper. En daar komt bij dat de 6600 zich wel bewezen heeft als overclocker bij uitstek.

En de reden dat die 6750 goedkoper is, is omdat hij een FSb van 1333 heeft tegenover de 1066 van de E6600. 1066 = 'oude' chipset (p965) en 1333 is de nieuwe variant (P35).

En aangezien fabrikanten waarschijnlijk liever zien dat je zo snel mogelijk met de meute meeloopt, maken ze die goedkoper. En daar komt bij dat de 6600 zich wel bewezen heeft als overclocker bij uitstek.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Ik las her en der dat men de 6750 moeiteloos tot 4Ghz hadden gekloktquote:Op vrijdag 31 augustus 2007 21:00 schreef Biogarde het volgende:

Voor een 6 a 700 Euro kun je een hele nette PC in elkaar jassen!

En de reden dat die 6750 goedkoper is, is omdat hij een FSb van 1333 heeft tegenover de 1066 van de E6600. 1066 = 'oude' chipset (p965) en 1333 is de nieuwe variant (P35).

En aangezien fabrikanten waarschijnlijk liever zien dat je zo snel mogelijk met de meute meeloopt, maken ze die goedkoper. En daar komt bij dat de 6600 zich wel bewezen heeft als overclocker bij uitstek.

Ehm... ok

Het probleem is juist dat ik 5 maanden geleden deze pc met 19" scherm heb gekocht en een grafische kaart voor 170 euro ondertussen de 1gb naar 2 gb verhoogd voeding vervangen.

dat komt ongeveer neer op een kleine 1200 euro dus k wil nu niet veel geld uit geven.

Maar mijn moederbord is toch een 775 socket en die moet dus togh ook core 2 duo ondersteunen?

Ik heb nu een pentium D 2.8 ghz.

Ik wil in ieder geval dat aankomende spellen het goed gaan doen met de 8800 zonder te haperen.

dat komt ongeveer neer op een kleine 1200 euro dus k wil nu niet veel geld uit geven.

Maar mijn moederbord is toch een 775 socket en die moet dus togh ook core 2 duo ondersteunen?

Ik heb nu een pentium D 2.8 ghz.

Ik wil in ieder geval dat aankomende spellen het goed gaan doen met de 8800 zonder te haperen.

775 ondersteunt inderdaad gewoon C2Dquote:Op vrijdag 31 augustus 2007 23:23 schreef nigel2 het volgende:

Het probleem is juist dat ik 5 maanden geleden deze pc met 19" scherm heb gekocht en een grafische kaart voor 170 euro ondertussen de 1gb naar 2 gb verhoogd voeding vervangen.

dat komt ongeveer neer op een kleine 1200 euro dus k wil nu niet veel geld uit geven.

Maar mijn moederbord is toch een 775 socket en die moet dus togh ook core 2 duo ondersteunen?

Ik heb nu een pentium D 2.8 ghz.

Ik wil in ieder geval dat aankomende spellen het goed gaan doen met de 8800 zonder te haperen.

A.F.C. Ajax

Hm, alle moederborden die 775 hebben?quote:Op zaterdag 1 september 2007 00:17 schreef SoupNazi het volgende:

[..]

775 ondersteunt inderdaad gewoon C2D

Ehm... ok

Qua socket wel. Niet qua chipset.quote:Op zaterdag 1 september 2007 00:17 schreef SoupNazi het volgende:

[..]

775 ondersteunt inderdaad gewoon C2D

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Nee. Chipset moet het ondersteunen. 775 was er ver voor de C2Dquote:Op zaterdag 1 september 2007 00:36 schreef Frumzel het volgende:

[..]

Hm, alle moederborden die 775 hebben?

Maar, er zijn mobo's die het na een bios-update en/of flash gewoon ondersteunen.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Hey ja je heb gelijk Ff afwachten iig heb nog flink wat games in tehalen tegen die tijd ,quote:Op donderdag 30 augustus 2007 14:57 schreef Biogarde het volgende:

[..]

En dan te bedenken dat ze na deze serie bij Nvidia overtappen op de 9800 serie

Heb je weer een 9800

I'm sick of all this pooping stuff i'm getting my buttcheeks pierced together .

Daar hebben ze 1232MB meer en DDR4 voor nodigquote:Op dinsdag 4 september 2007 00:53 schreef Dibble het volgende:

btw,

[afbeelding]

deze Ati walst toch wel over alle Nvidia's heen

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Valt wel mee, hij heeft alleen veel RAM. Loopt wel één enkele GTX, maar voor dat geld heb je een hele serverkast aan GTX kaarten.

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

Wat is het verschil tussen de socket en de chipset? Hoe kun je checken of de chipset ook C2D ondersteunt?quote:Op zaterdag 1 september 2007 02:12 schreef Biogarde het volgende:

[..]

Nee. Chipset moet het ondersteunen. 775 was er ver voor de C2D

Maar, er zijn mobo's die het na een bios-update en/of flash gewoon ondersteunen.

V.

Ja inderdaad, V. ja.

Derde poging (ik word steeds uit FOK! geknald als ik op 'invoeren' druk.

Niet om te vloeken in de kerk, maar omdat mijn nieuwe systeem langzaamaan steeds meer realiteit dreigt te worden, toch de volgende vraag. Ik heb besloten vooralsnog niet over te gaan op Vista, ivm de nodige onbestendigheid en nodeloze belasting van geheugen en processor, alleen al 33% tijdens idlen, heb ik mij laten vertellen

Dus omdat ik in XP blijf, zal ik vooralsnog toch niet boven DX9 komen, en dus wil ik weten of ergens terug te vinden is hoe een ATI X1950 (?) zich verhoudt tot een 8800GTS 320 onder DX9. Iemand tips of zelf enig idee?

V.

Niet om te vloeken in de kerk, maar omdat mijn nieuwe systeem langzaamaan steeds meer realiteit dreigt te worden, toch de volgende vraag. Ik heb besloten vooralsnog niet over te gaan op Vista, ivm de nodige onbestendigheid en nodeloze belasting van geheugen en processor, alleen al 33% tijdens idlen, heb ik mij laten vertellen

Dus omdat ik in XP blijf, zal ik vooralsnog toch niet boven DX9 komen, en dus wil ik weten of ergens terug te vinden is hoe een ATI X1950 (?) zich verhoudt tot een 8800GTS 320 onder DX9. Iemand tips of zelf enig idee?

V.

Ja inderdaad, V. ja.

Mijne is in idle toch maar 10% cpu belasting.... tevens staan er onnoembare progammas aanquote:Op dinsdag 4 september 2007 10:22 schreef Verbal het volgende:

Derde poging (ik word steeds uit FOK! geknald als ik op 'invoeren' druk.

Niet om te vloeken in de kerk, maar omdat mijn nieuwe systeem langzaamaan steeds meer realiteit dreigt te worden, toch de volgende vraag. Ik heb besloten vooralsnog niet over te gaan op Vista, ivm de nodige onbestendigheid en nodeloze belasting van geheugen en processor, alleen al 33% tijdens idlen, heb ik mij laten vertellen

Dus omdat ik in XP blijf, zal ik vooralsnog toch niet boven DX9 komen, en dus wil ik weten of ergens terug te vinden is hoe een ATI X1950 (?) zich verhoudt tot een 8800GTS 320 onder DX9. Iemand tips of zelf enig idee?

V.

Geheugengebruik is wel_wat_hoger dan XP.... Xp gebruikt clean zo'n 250mb fysiek geheugen, Vista daarintegen al zo'n 450 tot 500mb.

Met 2gb geheugen is er bijna geen probleem.

Wel gebruikt vista(Aero) in idle wat meer van je gpu dan normaal... al is dat niet zo gek veel.

De 8800GTS is natuurlijk sneller, veel sneller... maar de X1950 ga je nog steeds elke game op high spelen, want dat kan nóg met een 7800GT

Ja... echt!

Mijn CPU draait 95% idle onder Vista. Als je een leuke videokaart hebt is Vista sneller dan XP. Dus voor performance is Vista aan te raden, mits je hardware hebt waar Vista iets mee kan. (Ikzelf een 3500+ en een 6800GT)

Oudere games draaien vaak wel iets minder onder Vista, vooral slechte ports zoals RSV hebben het extra lastig.

Oudere games draaien vaak wel iets minder onder Vista, vooral slechte ports zoals RSV hebben het extra lastig.

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

95% idle? Nou dan weet ik niet wat voor troep jij op je pc hebt staanquote:Op dinsdag 4 september 2007 10:47 schreef dikkedorus het volgende:

Mijn CPU draait 95% idle onder Vista. Als je een leuke videokaart hebt is Vista sneller dan XP. Dus voor performance is Vista aan te raden, mits je hardware hebt waar Vista iets mee kan. (Ikzelf een 3500+ en een 6800GT)

Oudere games draaien vaak wel iets minder onder Vista, vooral slechte ports zoals RSV hebben het extra lastig.

Ja... echt!

Ingewikkeld he, compjoetersquote:Op dinsdag 4 september 2007 12:11 schreef KopieerMachine het volgende:

[..]

95% idle? Nou dan weet ik niet wat voor troep jij op je pc hebt staan

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

Socket is puur het processorvoetje, als een socket en processor hetzelfde zijn, past de cpu dus fysiek op het moederbord. De aansturing van de cpu gebeurt echter door de chipset (northbridge), die op het moederbord zit. Als deze chipset niet weet hoe hij met een bepaald type cpu om moet gaan, zal het dus niet werken, ook al past de cpu gewoon in de socket. Mogelijk zal het na een firmware upgrade wel werken, omdat de chipset dan "leert" hoe het nieuwe type processor aangestuurd moet worden.quote:Op dinsdag 4 september 2007 08:47 schreef Verbal het volgende:

[..]

Wat is het verschil tussen de socket en de chipset?

Handleiding moederbord.quote:Hoe kun je checken of de chipset ook C2D ondersteunt?

V.

I have the cape. I make the fucking Whoosh noise.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Ik heb nu een acer T660 2.8ghz pentium D.

Welke processor moet ik nemen om het beste uit de 8800gts te halen ?

Welke processor moet ik nemen om het beste uit de 8800gts te halen ?

OMG .quote:Op dinsdag 4 september 2007 12:11 schreef KopieerMachine het volgende:

[..]

95% idle? Nou dan weet ik niet wat voor troep jij op je pc hebt staan

Ik stel voor dat je snel terug naar ONZ gaat ok?

A gentle wave of heat flows over the FOK! forum

Get woke, go broke!

Get woke, go broke!

Wablief? ik snap niet wat je bedoeldquote:Op dinsdag 4 september 2007 16:09 schreef HeatWave het volgende:

[..]

OMG .

Ik stel voor dat je snel terug naar ONZ gaat ok?

Ja... echt!

Een C2D is het beste. E4300 icm een 8800 loopt als een raket. En zo'n 4300 kost een drol.quote:Op dinsdag 4 september 2007 16:05 schreef nigel2 het volgende:

Ik heb nu een acer T660 2.8ghz pentium D.

Welke processor moet ik nemen om het beste uit de 8800gts te halen ?

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Kan ik mijn drollen bij jou inleveren dan?quote:Op dinsdag 4 september 2007 16:30 schreef Biogarde het volgende:

[..]

Een C2D is het beste. E4300 icm een 8800 loopt als een raket. En zo'n 4300 kost een drol.

Maare daj moet je die E4300 wel flink overclocken natuurlijk

Ja... echt!

Maar zijn er ergens vgl warenonderzoeken tussen de verschillende kaarten, als in antwoord op mijn vraag?

V.

V.

Ja inderdaad, V. ja.

http://www23.tomshardware.com/graphics_2007.htmlquote:Op dinsdag 4 september 2007 17:13 schreef Verbal het volgende:

Maar zijn er ergens vgl warenonderzoeken tussen de verschillende kaarten, als in antwoord op mijn vraag?

V.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Vergelijk tussen een Mercedes en een Fiat Panda.

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Ik vind 95% eigenlijk best veel... Ik heb, weliswaar onder XP, een idle van 99%. Of is 95% normaal onder Vista?quote:Op dinsdag 4 september 2007 10:47 schreef dikkedorus het volgende:

Mijn CPU draait 95% idle onder Vista. Als je een leuke videokaart hebt is Vista sneller dan XP. Dus voor performance is Vista aan te raden, mits je hardware hebt waar Vista iets mee kan. (Ikzelf een 3500+ en een 6800GT)

Oudere games draaien vaak wel iets minder onder Vista, vooral slechte ports zoals RSV hebben het extra lastig.

I have the cape. I make the fucking Whoosh noise.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Op donderdag 12 juli 2012 19:56 schreef Lithia het volgende:

Ik durf hier niets over te zeggen. Bart is koning hier.

Heb je toevallig Volkswagen?quote:Op dinsdag 4 september 2007 17:25 schreef Biogarde het volgende:

Vergelijk tussen een Mercedes en een Fiat Panda.

Ja... echt!

Lees mijn post nog maar eens.quote:Op dinsdag 4 september 2007 16:29 schreef KopieerMachine het volgende:

[..]

Wablief? ik snap niet wat je bedoeld

psst 95% idle is dus 5% belasting

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

Vista zelf doet uiteraard niks.quote:Op dinsdag 4 september 2007 20:04 schreef Merovingian het volgende:

[..]

Ik vind 95% eigenlijk best veel... Ik heb, weliswaar onder XP, een idle van 99%. Of is 95% normaal onder Vista?

Het is oa taskmgr en mijn virusscanner die soms wat wegsnoepen. Ik zit nu op 92%, met Taskmgr op 8%. Dus het OS zelf doet niks. De Window Manager komt sporadisch naar voren (elke minuut een seconde of wat) met 2%. Is wel te verwachten. Zoiezo niks om je druk over te maken.

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

In combinatie met?quote:Op donderdag 6 september 2007 17:52 schreef Frumzel het volgende:

9569

Bio is baas. Ik ben niet meer op straat. Ik rij alleen langs om te kijken hoe het gaat.

Zo das veel...knikkers?quote:Op donderdag 6 september 2007 17:52 schreef Frumzel het volgende:

9569

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

E6750quote:

2GB Kingston HyperX 800Mhz

MSI 8800GTS OC

Asus P5KC

Recom Powerstation Window (maar dat boeit natuurlijk niet )

Ehm... ok

Dus mijn 5600+ @ 6000+ presteert beter dan jouw E6750?quote:Op donderdag 6 september 2007 21:08 schreef Frumzel het volgende:

[..]

E6750

2GB Kingston HyperX 800Mhz

MSI 8800GTS OC

Asus P5KC

Recom Powerstation Window (maar dat boeit natuurlijk niet )

A.F.C. Ajax

Geen idee. Heb de jouwe niet getestquote:Op donderdag 6 september 2007 21:12 schreef SoupNazi het volgende:

[..]

Dus mijn 5600+ @ 6000+ presteert beter dan jouw E6750?

Maar, ga eens gauw naar tweakers, opscheppert

Ehm... ok

De 6000+ presteert vaak nog onder de E6600 (bijv. transcoden), dus ik gok dat een 5600+ OC de E6750 er niet uittrekt, zeker niet als je de E6750 ook nog eens overklokt.

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

Blijkbaar wel dus, aangezien ik met dezelfde videokaart op 10200 zit.quote:Op donderdag 6 september 2007 22:03 schreef dikkedorus het volgende:

De 6000+ presteert vaak nog onder de E6600 (bijv. transcoden), dus ik gok dat een 5600+ OC de E6750 er niet uittrekt.

A.F.C. Ajax

Welke benchmark? Elke nieuwere versie geeft lagere cijfers.

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

Vreemd dat 3Dmark zulke hoge cijfers geeft.

Op Toms Hardware staan wat transcoding stats en daar trekt de E6750 de 6000+ er uit en in games blijkbaar ook.

Op Toms Hardware staan wat transcoding stats en daar trekt de E6750 de 6000+ er uit en in games blijkbaar ook.

Mini smilies tool voor alle [sub] en [sup] liefhebbers.

AMD loopt nog steeds iedere keer een stap achter op Intel.

Komt AMD met iets nieuws, dan heeft Intel dat al een jaar op de plank liggen.

Goed voorbeeld is het procédé waarop de chips gebakken worden. Het lukt AMD maar niet deze op 65nm te bakken.

Voor de fanboys die gaan roepen; en de GPU's dan

Ja, da's een heel ander soort processor. Veel minder complex.

Komt AMD met iets nieuws, dan heeft Intel dat al een jaar op de plank liggen.