SES School, Studie en Onderwijs

Wiskunde in de brugklas, Frans voor het examen of een studie Personeel en Arbeid? Moeilijke formulieren van DUO? Iets weten over studiefinanciering of studentenverenigingen? Dit is het forum voor leerkrachten, scholieren en studenten, van brugklas tot uni

Bleh, shoot me.

Nog wat aan het zoeken en puzzelen geweest.

Is dit enigszins juist?:

Volgende syntax gedraaid:

Om te beoordelen of Multi Model wel nodig is aan de hand van intraclass correlation (ICC) op basis van de Clubs

Heb dit gedaan per stakeholder groep en volgende output:

Local Government:

0.071456 / (0.071456 + 0.855686) = 0.077 = 7.7%

Sponsors:

0.027478 / (0.027478 + 0.955224) = 0.027 = 2.7%

Fans:

0.031911 / (0.031911+0.795851) = 0.038 = 3.8%

Deze lijken me niet genoeg impact te hebben om over te gaan op Multi Model als ik per stakeholder groep de relaties wil testen met regressieanalyse?

Ook gekeken naar de -2 Log Likelihood van het model met de random component Club en zonder. Het is bij Local Government bijvoorbeeld 1138.8 ten opzichte van 1150.

Nu zag ik het volgende in een voorbeeld:

Chi2 is toch in mijn geval:

Ofwel niet significant?

Welke is het in dit geval? Bij laatste bevestigd het dat one-level volstaat, maar als de waarde 11.2 is dan is het <0.01 en wijst dat op two-level

Voor hele sample is ICC voor clubs trouwens 15% maar dat lijkt me meer verklaard worden door de stakeholder groepen. Als ik bovenstaande ICC test met de stakeholder groep als random component dan is de ICC 28% dus dat is wel aanzienlijk met een p<0.001 bij Likelihood vergelijking welk getal ik ook pak.

Maar voor clubs dus twijfel

Nog wat aan het zoeken en puzzelen geweest.

Is dit enigszins juist?:

Volgende syntax gedraaid:

| 1 2 3 4 5 | mixed OrganizationalIdentification with DomainInvolvement RegionalAffiliation PerceivedCSR OrgPrestige OrgDistinctiveness ContactFrequency /fixed = /method = ml /random = intercept | subject(ClubID) /print = solution. |

Om te beoordelen of Multi Model wel nodig is aan de hand van intraclass correlation (ICC) op basis van de Clubs

Heb dit gedaan per stakeholder groep en volgende output:

Local Government:

0.071456 / (0.071456 + 0.855686) = 0.077 = 7.7%

Sponsors:

0.027478 / (0.027478 + 0.955224) = 0.027 = 2.7%

Fans:

0.031911 / (0.031911+0.795851) = 0.038 = 3.8%

Deze lijken me niet genoeg impact te hebben om over te gaan op Multi Model als ik per stakeholder groep de relaties wil testen met regressieanalyse?

Ook gekeken naar de -2 Log Likelihood van het model met de random component Club en zonder. Het is bij Local Government bijvoorbeeld 1138.8 ten opzichte van 1150.

Nu zag ik het volgende in een voorbeeld:

Maar daar slaan ze stukje over toch? Chi2 is toch niet puur het verschil tussen de 2 getallen en dan bij df=1 kijken of het hoger is dan 3.84?quote:Chi square=203 026.467 - 196 165.706 = 6860.76, with 1 df, p=0.000. The outcome is highly significant and indicates that a two-level model is necessary.

Chi2 is toch in mijn geval:

| 1 2 3 | (1150-1138.8)[sup]2[/sup] ---------------------------------- = 0.109 1150 |

Ofwel niet significant?

Welke is het in dit geval? Bij laatste bevestigd het dat one-level volstaat, maar als de waarde 11.2 is dan is het <0.01 en wijst dat op two-level

Voor hele sample is ICC voor clubs trouwens 15% maar dat lijkt me meer verklaard worden door de stakeholder groepen. Als ik bovenstaande ICC test met de stakeholder groep als random component dan is de ICC 28% dus dat is wel aanzienlijk met een p<0.001 bij Likelihood vergelijking welk getal ik ook pak.

Maar voor clubs dus twijfel

Ik heb een vraagje. In mijn thesis doe ik onderzoek naar 'gerrymandering' in the USA (het herverdelen van kiesdistricten om een meerderheid te verkrijgen). ik heb zelf de data over gerrymandering verzameld tussen 1961 en nu en heb van mijn begeleider de data gekregen met wie er in welk district de verkiezingen heeft gewonnen en met hoeveel procent vd stemmen. Mijn eigen data werkt helemaal met cijfers (geen gerrymandering is een nul, wel een 1). Maar die van mijn begeleider werkt uiteraard met namen. Nu bestaat zijn data uit meet dan 20.000 records, dus handmatig overzetten in werkbare cijfers gaat een tijd duren. Is er nog een andere manier waarop ik met beide datasets een regressie kan uitvoeren (in eviews of SPSS, want daar heb ik ervaring mee. we hebben op de uni evt ook Stata) zonder dat ik alles handmatig in cijfers hoef te veranderen.

Het gaat dus vooral om het transformeren van de begeleider zijn data in iets wat SPSS of eviews begrijpt. Als ik dat eenmaal heb lukt het uitvoeren van een regressie wel. Ik kan dit ook aan mijn begeleider vragen, maar die is er tot maandag niet meer en maandag heb ik een afspraak met hem waarbij ik eigenlijk hoop al wat resultaten te kunnen overleggen.

Het gaat dus vooral om het transformeren van de begeleider zijn data in iets wat SPSS of eviews begrijpt. Als ik dat eenmaal heb lukt het uitvoeren van een regressie wel. Ik kan dit ook aan mijn begeleider vragen, maar die is er tot maandag niet meer en maandag heb ik een afspraak met hem waarbij ik eigenlijk hoop al wat resultaten te kunnen overleggen.

life is what happens to you, while you're busy making other plans.

Zijn dat 20 000 verschillende namen of maar een paar? Je kunt wel een scriptje schrijven waarin je alle namen een nummer geeft, waarna je met dat nummer gaat rekenen en er na afloop weer die naam aan koppelt. In R is dat niet bijzonder moeilijk weet ik, Stata zou ook wel te doen zijn. SPSS en eviews heb ik niet genoeg kennis van.quote:Op donderdag 11 juni 2015 09:32 schreef superkimmi het volgende:

Ik heb een vraagje. In mijn thesis doe ik onderzoek naar 'gerrymandering' in the USA (het herverdelen van kiesdistricten om een meerderheid te verkrijgen). ik heb zelf de data over gerrymandering verzameld tussen 1961 en nu en heb van mijn begeleider de data gekregen met wie er in welk district de verkiezingen heeft gewonnen en met hoeveel procent vd stemmen. Mijn eigen data werkt helemaal met cijfers (geen gerrymandering is een nul, wel een 1). Maar die van mijn begeleider werkt uiteraard met namen. Nu bestaat zijn data uit meet dan 20.000 records, dus handmatig overzetten in werkbare cijfers gaat een tijd duren. Is er nog een andere manier waarop ik met beide datasets een regressie kan uitvoeren (in eviews of SPSS, want daar heb ik ervaring mee. we hebben op de uni evt ook Stata) zonder dat ik alles handmatig in cijfers hoef te veranderen.

Het gaat dus vooral om het transformeren van de begeleider zijn data in iets wat SPSS of eviews begrijpt. Als ik dat eenmaal heb lukt het uitvoeren van een regressie wel. Ik kan dit ook aan mijn begeleider vragen, maar die is er tot maandag niet meer en maandag heb ik een afspraak met hem waarbij ik eigenlijk hoop al wat resultaten te kunnen overleggen.

Op dinsdag 23 november 2010 02:22 schreef Braddie het volgende:

Haal van internet af man.

Haal van internet af man.

Het zit er qua aantal tussenin. Het gaat om de verkiezingen sinds 1960 tot van alle districten. Een naam komt uiteraard vaker voor, wanneer iemand vaker heeft meegedaan aan verkiezingen, maar het zijn zeker duizenden namen.quote:Op donderdag 11 juni 2015 14:13 schreef wimjongil het volgende:

[..]

Zijn dat 20 000 verschillende namen of maar een paar? Je kunt wel een scriptje schrijven waarin je alle namen een nummer geeft, waarna je met dat nummer gaat rekenen en er na afloop weer die naam aan koppelt. In R is dat niet bijzonder moeilijk weet ik, Stata zou ook wel te doen zijn. SPSS en eviews heb ik niet genoeg kennis van.

life is what happens to you, while you're busy making other plans.

Ah ja, dat dacht ik al.quote:Op donderdag 11 juni 2015 14:15 schreef superkimmi het volgende:

[..]

Het zit er qua aantal tussenin. Het gaat om de verkiezingen sinds 1960 tot van alle districten. Een naam komt uiteraard vaker voor, wanneer iemand vaker heeft meegedaan aan verkiezingen, maar het zijn zeker duizenden namen.

Voorbeeld in R pseudocode:

| 1 2 3 4 5 6 7 8 9 10 11 | data$nieuwekolom <- NA for(i in 1:20000){ for(j in 1:i){ if(naam[i] == naam[j]{ data$nieuwekolom[i] = j } else{ data$nieuwekolom[i] = i } } } |

Aan zoiets moet je denken. Die if statement moet je even mee opletten want strings vergelijken gaat niet zomaar.

Op dinsdag 23 november 2010 02:22 schreef Braddie het volgende:

Haal van internet af man.

Haal van internet af man.

Ok dankje  Het is fijn om te weten dat er in ieder geval methodes bestaan om er mee te puzzelen. Alles handmatig leek me een tikkeltje overdreven.

Het is fijn om te weten dat er in ieder geval methodes bestaan om er mee te puzzelen. Alles handmatig leek me een tikkeltje overdreven.

life is what happens to you, while you're busy making other plans.

Dag mensen,

kunnen jullie mij helpen? Ik wil (denk ik) een logregressie uitvoeren. Hierbij is de log de dependent variable, oftewel de abnormal return (abnormalret). thirtysix, ninetysix, hundredfiftysix en hunfiftysixPLUS zijn dummy variabelen die gelijk staan aan 1 indien de waardes van tenure respectievelijk 0-35, 36-95, 96-155 en 156+ zijn. Ten slotte is er ook nog de marktcapitalisatie die ik als variabele in wil voeren in het model.

Mijn model moet worden: logabnormalret = b1*thirtysix + b2*ninetysix + b3*hundredfiftysix + b4*hunfiftysixPLUS + b5*marketcap.

Hoe doe ik dit? Ik probeer ten eerste de normale abnormalret in mijn edit tabel te replacen met logabnormalret, maar volgens mij kan logabnormalret niet bestaan zonder abnormalret? Ten tweede wil ik tenure niet in mijn model maar moet ik het volgens mij wel invoeren in de edit tabel omdat de dummyvariabelen anders niet werken?

Ik heb net geprobeerd regressies te doen maar ik kreeg steeds de melding dat er geen observaties waren? Bij die regressie probeerde ik logabnormal ret te regresseren op de 4 dummies en marketcap.

Kunnen jullie mij helpen? Ben een zieke STATA noob en weet niet wat wel en niet kan, en wat ik fout doe. Vriendelijke groet.

http://i.imgur.com/ckQYiow.png

kunnen jullie mij helpen? Ik wil (denk ik) een logregressie uitvoeren. Hierbij is de log de dependent variable, oftewel de abnormal return (abnormalret). thirtysix, ninetysix, hundredfiftysix en hunfiftysixPLUS zijn dummy variabelen die gelijk staan aan 1 indien de waardes van tenure respectievelijk 0-35, 36-95, 96-155 en 156+ zijn. Ten slotte is er ook nog de marktcapitalisatie die ik als variabele in wil voeren in het model.

Mijn model moet worden: logabnormalret = b1*thirtysix + b2*ninetysix + b3*hundredfiftysix + b4*hunfiftysixPLUS + b5*marketcap.

Hoe doe ik dit? Ik probeer ten eerste de normale abnormalret in mijn edit tabel te replacen met logabnormalret, maar volgens mij kan logabnormalret niet bestaan zonder abnormalret? Ten tweede wil ik tenure niet in mijn model maar moet ik het volgens mij wel invoeren in de edit tabel omdat de dummyvariabelen anders niet werken?

Ik heb net geprobeerd regressies te doen maar ik kreeg steeds de melding dat er geen observaties waren? Bij die regressie probeerde ik logabnormal ret te regresseren op de 4 dummies en marketcap.

Kunnen jullie mij helpen? Ben een zieke STATA noob en weet niet wat wel en niet kan, en wat ik fout doe. Vriendelijke groet.

http://i.imgur.com/ckQYiow.png

Het heeft met multicollinearity te maken maar zelfs als ik dingen verander ervaar ik hetzelfde!!

http://i.imgur.com/RlIKye9.png

Zou de formule: log(abnormal return) = constant + b1*tenure0-3jaar + b2*tenure13+jaar + b3*marketcap dit oplossen? Omdat er dan niet per se een dummy variabele is? Of, omdat de constant dan eigenlijk de waarde van de vorige dummy variabeles die nu zijn verdwenen meeneemt (3-8 jaar en 8-13 jaar) krijg ik nog steeds hetzelfde probleem? Zo niet, verklaart de constante dan in het nieuwe geval het effect van 3-13 jaar tenure?

[ Bericht 52% gewijzigd door haha94boem op 14-06-2015 03:13:54 ]

http://i.imgur.com/RlIKye9.png

Zou de formule: log(abnormal return) = constant + b1*tenure0-3jaar + b2*tenure13+jaar + b3*marketcap dit oplossen? Omdat er dan niet per se een dummy variabele is? Of, omdat de constant dan eigenlijk de waarde van de vorige dummy variabeles die nu zijn verdwenen meeneemt (3-8 jaar en 8-13 jaar) krijg ik nog steeds hetzelfde probleem? Zo niet, verklaart de constante dan in het nieuwe geval het effect van 3-13 jaar tenure?

[ Bericht 52% gewijzigd door haha94boem op 14-06-2015 03:13:54 ]

Het is bijna altijd slim om de constant er gewoon in te laten. Dit gebeurt automatisch in stata.

Daarnaast is het slim om eerst de dummy variabelen te creëren voordat je je model schat.

Als je abnormalret in je dataset hebt en je wilt de log is dit de syntax:

gen logabnormalret=Log(abnormalret)

Daarnaast is het slim om eerst de dummy variabelen te creëren voordat je je model schat.

Als je abnormalret in je dataset hebt en je wilt de log is dit de syntax:

gen logabnormalret=Log(abnormalret)

Ik zie je screenshot nu pas, en je probleem zit hem waarschijnlijk in het lage aantal observaties. Daardoor is er geen variantie tussen observatie en kan er niks geschat worden.

In dit geval is dus een regressie geen optie.

In dit geval is dus een regressie geen optie.

Die foutmelding 'no observations' heeft er waarschijnlijk mee te maken dat stata altijd alleen observaties meeneemt zonder missings. Misschien wil je de missings in een 0 veranderen? Tenminste, als dat dummies zijn.

Overigens kan je ook originele variabelen gebruiken en in er 'ib2.' voor zetten (als de tweede categorie je referentie is, anders ib1. of ib3 of wat dan ook).

Overigens kan je ook originele variabelen gebruiken en in er 'ib2.' voor zetten (als de tweede categorie je referentie is, anders ib1. of ib3 of wat dan ook).

'Expand my brain, learning juice!'

<a href="http://www.last.fm/user/crossover1" rel="nofollow" target="_blank">Last.fm</a>

<a href="http://www.last.fm/user/crossover1" rel="nofollow" target="_blank">Last.fm</a>

Dag mensen,

Bedankt voor jullie reacties. Ik heb inmiddels geprobeerd om gewoon alle data in te voeren en nu lukte het wel. Weet niet of het dan daadwerkelijk ligt aan een te lage hoeveelheid observaties in het eerste geval.

In ieder geval, ik heb nog een vraag. Ik denk dat ik log(abnormalreturn) wil regressen ipv abnormal return. Echter, als ik gen logabnormalreturn = log(abnormalreturn) doe, worden mijn negatieve waardes 'verwijderd' bij log: http://i.imgur.com/LT5PI8c.png

Hoe kan ik nu een logregressie doen? Ik moet ook de negatieve abnormal returns meenemen voor mijn onderzoek, maar ik weet niet wat ik nu moet doen om dit op te lossen. Heeft iemand tips?

Bedankt voor jullie reacties. Ik heb inmiddels geprobeerd om gewoon alle data in te voeren en nu lukte het wel. Weet niet of het dan daadwerkelijk ligt aan een te lage hoeveelheid observaties in het eerste geval.

In ieder geval, ik heb nog een vraag. Ik denk dat ik log(abnormalreturn) wil regressen ipv abnormal return. Echter, als ik gen logabnormalreturn = log(abnormalreturn) doe, worden mijn negatieve waardes 'verwijderd' bij log: http://i.imgur.com/LT5PI8c.png

Hoe kan ik nu een logregressie doen? Ik moet ook de negatieve abnormal returns meenemen voor mijn onderzoek, maar ik weet niet wat ik nu moet doen om dit op te lossen. Heeft iemand tips?

Probeer gen logabnormalreturn=ln(abnormalreturn)quote:Op zondag 14 juni 2015 18:07 schreef haha94boem het volgende:

Dag mensen,

Bedankt voor jullie reacties. Ik heb inmiddels geprobeerd om gewoon alle data in te voeren en nu lukte het wel. Weet niet of het dan daadwerkelijk ligt aan een te lage hoeveelheid observaties in het eerste geval.

In ieder geval, ik heb nog een vraag. Ik denk dat ik log(abnormalreturn) wil regressen ipv abnormal return. Echter, als ik gen logabnormalreturn = log(abnormalreturn) doe, worden mijn negatieve waardes 'verwijderd' bij log: http://i.imgur.com/LT5PI8c.png

Hoe kan ik nu een logregressie doen? Ik moet ook de negatieve abnormal returns meenemen voor mijn onderzoek, maar ik weet niet wat ik nu moet doen om dit op te lossen. Heeft iemand tips?

'Expand my brain, learning juice!'

<a href="http://www.last.fm/user/crossover1" rel="nofollow" target="_blank">Last.fm</a>

<a href="http://www.last.fm/user/crossover1" rel="nofollow" target="_blank">Last.fm</a>

Gebeurt hetzelfde, helaas.quote:Op zondag 14 juni 2015 18:44 schreef crossover het volgende:

[..]

Probeer gen logabnormalreturn=ln(abnormalreturn)

Indexeren of een ratio maken. Logaritmes van negatieve getallen is niet mogelijk namelijk.quote:Op zondag 14 juni 2015 18:07 schreef haha94boem het volgende:

Dag mensen,

Bedankt voor jullie reacties. Ik heb inmiddels geprobeerd om gewoon alle data in te voeren en nu lukte het wel. Weet niet of het dan daadwerkelijk ligt aan een te lage hoeveelheid observaties in het eerste geval.

In ieder geval, ik heb nog een vraag. Ik denk dat ik log(abnormalreturn) wil regressen ipv abnormal return. Echter, als ik gen logabnormalreturn = log(abnormalreturn) doe, worden mijn negatieve waardes 'verwijderd' bij log: http://i.imgur.com/LT5PI8c.png

Hoe kan ik nu een logregressie doen? Ik moet ook de negatieve abnormal returns meenemen voor mijn onderzoek, maar ik weet niet wat ik nu moet doen om dit op te lossen. Heeft iemand tips?

Bedankt.quote:Op zondag 14 juni 2015 19:58 schreef Banaanensuiker het volgende:

[..]

Indexeren of een ratio maken. Logaritmes van negatieve getallen is niet mogelijk namelijk.

Weet je misschien het antwoord op de volgende vraag: als ik van mijn dummyvariabelen een log maak, dus b1*log(tenure0-3years) ipv b1*tenure0-3years, krijg ik dan een correcte interpretatie? Als ik ln(1) op mijn rekenmachine intype krijg ik namelijk 0, dus klopt mijn stata model dan wel?

Een doube log specificatie betekent dat de beta's geinterpreteerd kunnen worden als point elasticities. Met een dummy variable is dit niet echt logisch, gezien dit discrete waarden zijn, dus 0 of 1. Met waarden die continu zijn is dit een stuk logischer.quote:Op zondag 14 juni 2015 20:12 schreef haha94boem het volgende:

[..]

Bedankt.

Weet je misschien het antwoord op de volgende vraag: als ik van mijn dummyvariabelen een log maak, dus b1*log(tenure0-3years) ipv b1*tenure0-3years, krijg ik dan een correcte interpretatie? Als ik ln(1) op mijn rekenmachine intype krijg ik namelijk 0, dus klopt mijn stata model dan wel?

Je moet je afvragen waarom je een log log specificatie wilt doen, en of dit thereotisch gezien ergens op slaat.

Onjuist, dat is wel mogelijk.quote:Op zondag 14 juni 2015 19:58 schreef Banaanensuiker het volgende:

[..]

Indexeren of een ratio maken. Logaritmes van negatieve getallen is niet mogelijk namelijk.

Op dinsdag 23 november 2010 02:22 schreef Braddie het volgende:

Haal van internet af man.

Haal van internet af man.

Natuurlijk logaritme van negatief getal is niet gedefinieerd, en daar gaat het in dit geval om. Maar anderzijds heb je gelijk ja.quote:

Dat is ook niet correct. Het natuurlijk logartime van een negatief is namelijk wel gedefinieerd, te weten als een complex getal.quote:Op maandag 15 juni 2015 14:18 schreef Banaanensuiker het volgende:

[..]

Natuurlijk logaritme van negatief getal is niet gedefinieerd, en daar gaat het in dit geval om. Maar anderzijds heb je gelijk ja.

Op dinsdag 23 november 2010 02:22 schreef Braddie het volgende:

Haal van internet af man.

Haal van internet af man.

Ha iedereen!

Ik loop behoorlijk vast met SPSS. Het gaat om het volgende:

Mijn enquete is (voornamelijk) op Likert-schaal afgenomen. De y = gemiddelde behaalde cijfer op Likert schaal:

1 = <4,

2 = 4,1 t/m 5

3 = 5,1 t/m 6

4 = 6,1-7

etc.

Al onze x'en zijn ook op Likert schaal afgenomen (van 0=helemaal oneens naar 5=helemaal eens)

Volgens mijn docent mag ik gewoon een Likert-schaal op interval/ratio niveau gebruiken.

Ik heb de y en alle x'en op schaalniveau ingesteld en (na SomScores te hebben gemaakt van meerdere variabelen) deze ingevoerd en getest voor lineariteit en normaliteit. De bijlagen geven mijn resultaten weer. Klopt het dat ik iets totaal verkeerd heb gedaan? En zo niet, op welke toets moet ik nu overstappen?

http://nl.tinypic.com/r/b665gj/8

http://nl.tinypic.com/r/1zf78tg/8

http://nl.tinypic.com/r/260er9i/8

Ik loop behoorlijk vast met SPSS. Het gaat om het volgende:

Mijn enquete is (voornamelijk) op Likert-schaal afgenomen. De y = gemiddelde behaalde cijfer op Likert schaal:

1 = <4,

2 = 4,1 t/m 5

3 = 5,1 t/m 6

4 = 6,1-7

etc.

Al onze x'en zijn ook op Likert schaal afgenomen (van 0=helemaal oneens naar 5=helemaal eens)

Volgens mijn docent mag ik gewoon een Likert-schaal op interval/ratio niveau gebruiken.

Ik heb de y en alle x'en op schaalniveau ingesteld en (na SomScores te hebben gemaakt van meerdere variabelen) deze ingevoerd en getest voor lineariteit en normaliteit. De bijlagen geven mijn resultaten weer. Klopt het dat ik iets totaal verkeerd heb gedaan? En zo niet, op welke toets moet ik nu overstappen?

http://nl.tinypic.com/r/b665gj/8

http://nl.tinypic.com/r/1zf78tg/8

http://nl.tinypic.com/r/260er9i/8

Even een vraagje. Ik heb zo'n 200 respondenten een kennisquiz laten afnemen. Die resultaten heb ik verwerkt en ik wil ze nu verdelen in drie categoriëen. Hoog scorend, laagscorend en gemiddeld scorend.

Nu is mijn vraag: hoe verdeel ik die. Doe ik dat zo gelijk mogelijk (dus 3 ongeveer even grote groepen) of moet ik dan werken met standaarddeviaties. Want ook dat heb ik ergens gelezen in een artikel.

Ter verduidelijking, die tweede methode is als volgt:

LOW 0 tot (median-standaarddeviatie)

MED (median-standaarddeviatie) tot (median+standaarddeviatie)

HIGH (median+standaarddeviatie) tot 10

Die drie groepen wil ik dan constant met elkaar vergelijken met andere resultaten uit mijn enquete.

Ik weet dus wel hoe ik die groepen verdeel, maar wil graag weten wat beter is.

Nu is mijn vraag: hoe verdeel ik die. Doe ik dat zo gelijk mogelijk (dus 3 ongeveer even grote groepen) of moet ik dan werken met standaarddeviaties. Want ook dat heb ik ergens gelezen in een artikel.

Ter verduidelijking, die tweede methode is als volgt:

LOW 0 tot (median-standaarddeviatie)

MED (median-standaarddeviatie) tot (median+standaarddeviatie)

HIGH (median+standaarddeviatie) tot 10

Die drie groepen wil ik dan constant met elkaar vergelijken met andere resultaten uit mijn enquete.

Ik weet dus wel hoe ik die groepen verdeel, maar wil graag weten wat beter is.

Dan moet je splitsen op het 33ste percentiel en 66e percentiel.quote:Op dinsdag 16 juni 2015 14:45 schreef Rumille het volgende:

Even een vraagje. Ik heb zo'n 200 respondenten een kennisquiz laten afnemen. Die resultaten heb ik verwerkt en ik wil ze nu verdelen in drie categoriëen. Hoog scorend, laagscorend en gemiddeld scorend.

Nu is mijn vraag: hoe verdeel ik die. Doe ik dat zo gelijk mogelijk (dus 3 ongeveer even grote groepen) of moet ik dan werken met standaarddeviaties. Want ook dat heb ik ergens gelezen in een artikel.

Ter verduidelijking, die tweede methode is als volgt:

LOW 0 tot (median-standaarddeviatie)

MED (median-standaarddeviatie) tot (median+standaarddeviatie)

HIGH (median+standaarddeviatie) tot 10

Die drie groepen wil ik dan constant met elkaar vergelijken met andere resultaten uit mijn enquete.

Ik weet dus wel hoe ik die groepen verdeel, maar wil graag weten wat beter is.

'Expand my brain, learning juice!'

<a href="http://www.last.fm/user/crossover1" rel="nofollow" target="_blank">Last.fm</a>

<a href="http://www.last.fm/user/crossover1" rel="nofollow" target="_blank">Last.fm</a>

In je tweede foto (en trouwens ook je derde) zie je dat je verdeling sterk afwijkt van een normale verdeling. Daarmee schendt je een assumptie van regressie. Je kan eens proberen om alles te hercoderen naar een log schaalquote:Op maandag 15 juni 2015 23:04 schreef fetX het volgende:

Ha iedereen!

Ik loop behoorlijk vast met SPSS. Het gaat om het volgende:

Mijn enquete is (voornamelijk) op Likert-schaal afgenomen. De y = gemiddelde behaalde cijfer op Likert schaal:

1 = <4,

2 = 4,1 t/m 5

3 = 5,1 t/m 6

4 = 6,1-7

etc.

Al onze x'en zijn ook op Likert schaal afgenomen (van 0=helemaal oneens naar 5=helemaal eens)

Volgens mijn docent mag ik gewoon een Likert-schaal op interval/ratio niveau gebruiken.

Ik heb de y en alle x'en op schaalniveau ingesteld en (na SomScores te hebben gemaakt van meerdere variabelen) deze ingevoerd en getest voor lineariteit en normaliteit. De bijlagen geven mijn resultaten weer. Klopt het dat ik iets totaal verkeerd heb gedaan? En zo niet, op welke toets moet ik nu overstappen?

http://nl.tinypic.com/r/b665gj/8

http://nl.tinypic.com/r/1zf78tg/8

http://nl.tinypic.com/r/260er9i/8

'Expand my brain, learning juice!'

<a href="http://www.last.fm/user/crossover1" rel="nofollow" target="_blank">Last.fm</a>

<a href="http://www.last.fm/user/crossover1" rel="nofollow" target="_blank">Last.fm</a>

Eerdere vragen van mij zijn grotendeels wel besproken met begeleider inmiddels. Nu even een simpele (denk ik) vraag die wat makkelijker beantwoord kan worden gok ik:

In m'n theoretisch framework heb ik 6 predictors/antecedenten. Ik gebruik multiple regression. Er zijn guidelines die zeggen van bv 20 cases per predictor variable nodig. In dit geval dus 120.

Maar als ik nu in SPSS bij de regressie nog bv 3 dummies erbij opneem (waarvan 1 als reference gebruikt zal worden) en 18 interacties (de 6 antecedenten elk keer de 3 dummies) waarvan 6 als reference, en ook nog 3 controle variabelen...

.. Dan geeft SPSS weer dat ik 23 predictors heb (telt reference dus niet mee)

Gaat diezelfde guideline dan op en moet ik dan idealiter 460 cases hebben? Of tellen sommige niet mee zoals bijvoorbeeld interactie termen? Of mss zelfs zo dat ik de reference van de dummies er ook nog bij moet tellen omdat ie daar berekeningen voor maakt en ik 30 x 20 = 600 cases moet hebben?

In m'n theoretisch framework heb ik 6 predictors/antecedenten. Ik gebruik multiple regression. Er zijn guidelines die zeggen van bv 20 cases per predictor variable nodig. In dit geval dus 120.

Maar als ik nu in SPSS bij de regressie nog bv 3 dummies erbij opneem (waarvan 1 als reference gebruikt zal worden) en 18 interacties (de 6 antecedenten elk keer de 3 dummies) waarvan 6 als reference, en ook nog 3 controle variabelen...

.. Dan geeft SPSS weer dat ik 23 predictors heb (telt reference dus niet mee)

Gaat diezelfde guideline dan op en moet ik dan idealiter 460 cases hebben? Of tellen sommige niet mee zoals bijvoorbeeld interactie termen? Of mss zelfs zo dat ik de reference van de dummies er ook nog bij moet tellen omdat ie daar berekeningen voor maakt en ik 30 x 20 = 600 cases moet hebben?

We nemen 3 ballen zonder teruglegging

De kans op 2 zwarte en 1 witte bal is

In totaal zijn er 14 ballen waarvan 8 zwart en 6 wit. Hoe kan ik deze bewerking uitvoeren op mijn TI-83?

De kans op 2 zwarte en 1 witte bal is

In totaal zijn er 14 ballen waarvan 8 zwart en 6 wit. Hoe kan ik deze bewerking uitvoeren op mijn TI-83?

"Fifty years ago the Leningrad street taught me a rule - if a fight is inevitable, you have to throw the first punch."

Vladimir Putin

“To forgive the terrorists is up to God, but to send them there is up to me.”

Vladimir Putin

Vladimir Putin

“To forgive the terrorists is up to God, but to send them there is up to me.”

Vladimir Putin

Je zit in het verkeerde topic. Wat jij nodig hebt, is het kansrekeningtopic.quote:Op woensdag 24 juni 2015 14:57 schreef phpmystyle het volgende:

We nemen 3 ballen zonder teruglegging

De kans op 2 zwarte en 1 witte bal is

In totaal zijn er 14 ballen waarvan 8 zwart en 6 wit. Hoe kan ik deze bewerking uitvoeren op mijn TI-83?

Op dinsdag 23 november 2010 02:22 schreef Braddie het volgende:

Haal van internet af man.

Haal van internet af man.

Ik zit nog steeds met mjin onderzoek over Gerrymandering (zie paar pagina's terug). Ben inmiddels wel een stuk verder, alles met de data is gelukt. Maar nu wil ik een bepaalde regressie invoeren in stata (ik kan geen ander programma gebruiken, omdat mijn data correct getransformeerd is met stata en niet met andere programma's). De regressie is als volgt:

Probit(gerrymandering_t)=Delta(voteshare_(t-1)-voteshare_t)+e_t

Probit is een stata commando, gerrymandering is een van mijn variabelen (net als voteshare overigens). t staat uiteraard voor tijd en delta voor verandering. Het gene wat hiermee uitgerekend moet worden is de kans dat een verandering in de hoeveelheid stemmen die een winnende partij krijgt dit keer ten opzichte van de vorige keer, (deels) komt door gerrymandering.

De vraag uiteindelijk is: hoe laat je stata deze bewerking uitvoeren? probit is dus een bestaande commando maar ik weet niet hoe je in stata werkt met verandering (delta) en met het deel ' voteshare_(t-1)-voteshare_t'

Probit(gerrymandering_t)=Delta(voteshare_(t-1)-voteshare_t)+e_t

Probit is een stata commando, gerrymandering is een van mijn variabelen (net als voteshare overigens). t staat uiteraard voor tijd en delta voor verandering. Het gene wat hiermee uitgerekend moet worden is de kans dat een verandering in de hoeveelheid stemmen die een winnende partij krijgt dit keer ten opzichte van de vorige keer, (deels) komt door gerrymandering.

De vraag uiteindelijk is: hoe laat je stata deze bewerking uitvoeren? probit is dus een bestaande commando maar ik weet niet hoe je in stata werkt met verandering (delta) en met het deel ' voteshare_(t-1)-voteshare_t'

life is what happens to you, while you're busy making other plans.

Goedemiddag, weet iemand hoe ik de volgende twee vragen kan maken? Ik loop vast met het feit dat er sprake is van een correlatie in plaats van dat het onafhankelijke variabelen zijn:

Ten slotte een vraag over een opgave :

Waarom kom ik wel op het goede antwoord uit als ik de variantie bereken en vervolgens de wortel hiervan neem, maar kom ik op een fout antwoord uit als ik de standaarddeviatie direct wil berekenen?

Ten slotte een vraag over een opgave :

Waarom kom ik wel op het goede antwoord uit als ik de variantie bereken en vervolgens de wortel hiervan neem, maar kom ik op een fout antwoord uit als ik de standaarddeviatie direct wil berekenen?

mijn vraag: nvm, het is al gelukt inmiddels

life is what happens to you, while you're busy making other plans.

Hoi allen,

Ik ben momenteel hard bezig met mijn masterscriptie. Loop nu alleen tegen een probleempje op. Ik heb een groep respondenten een vragenlijst voorgelegd met daarin (onder andere) drie schalen voor drie soorten leiderschapsstijl.

In dit geval authentiek leiderschap, transformationeel leiderschap en transactioneel leiderschap. Dit heb ik ordinaal gemeten. Een van mijn hypotheses is dat authentiek leiderschap een autonoom concept is en dus gezien kan worden als ''echte leiderschapsstijl''.

Nu wil ik dus gaan controleren of personen die hoog scoren op Authentiek leiderschap laag scoren op de twee andere vormen van leiderschap en vice versa.

Nu weet ik alleen niet precies hoe ik dit kan toetsen.. Heb een hele lijst met data maar weet niet hoe ik de mensen aan de hand van hun score kan categoriseren bij een van de drie stijlen. M'n begeleider gaf aan dat hij het zelf ook niet zo goed wist en dat hij dacht dat ik iets van een betrouwbaarheidsinterval voor ieder van de drie stijlen moest uitvoeren en vervolgens moest kijken of deze overlap hebben... Maar volgens mij moet dit ook anders kunnen toch?

Heeft een van jullie een idee?

Ik ben momenteel hard bezig met mijn masterscriptie. Loop nu alleen tegen een probleempje op. Ik heb een groep respondenten een vragenlijst voorgelegd met daarin (onder andere) drie schalen voor drie soorten leiderschapsstijl.

In dit geval authentiek leiderschap, transformationeel leiderschap en transactioneel leiderschap. Dit heb ik ordinaal gemeten. Een van mijn hypotheses is dat authentiek leiderschap een autonoom concept is en dus gezien kan worden als ''echte leiderschapsstijl''.

Nu wil ik dus gaan controleren of personen die hoog scoren op Authentiek leiderschap laag scoren op de twee andere vormen van leiderschap en vice versa.

Nu weet ik alleen niet precies hoe ik dit kan toetsen.. Heb een hele lijst met data maar weet niet hoe ik de mensen aan de hand van hun score kan categoriseren bij een van de drie stijlen. M'n begeleider gaf aan dat hij het zelf ook niet zo goed wist en dat hij dacht dat ik iets van een betrouwbaarheidsinterval voor ieder van de drie stijlen moest uitvoeren en vervolgens moest kijken of deze overlap hebben... Maar volgens mij moet dit ook anders kunnen toch?

Heeft een van jullie een idee?

Fantasie is belangrijker dan kennis, want kennis is begrensd.

Heb je al de Likertschalen samengevoegd tot één ratiovariabele (mits de cronbachs alpha goed zit natuurlijk)? Dan kan je wel mikken of ze significant van elkaar verschillen.

Wat je zou kunnen doen, maar dat is maar een hersenscheetje, is vaststellen wat 'hoog' is. Bijvoorbeeld, boven de 3,5 gemiddeld. Dan maak je drie nieuwe dichotome variabelen (stijl 1 hoog of laag, etc). Vergelijk dan de gemiddelden van stijl 2 tussen de twee groepen 'stijl 1 hoog' en 'stijl 1 laag'. Als daar significant verschil in zit, heb je een conclusie.

Maar nogmaals, is maar een hersenscheetje.

Wat je zou kunnen doen, maar dat is maar een hersenscheetje, is vaststellen wat 'hoog' is. Bijvoorbeeld, boven de 3,5 gemiddeld. Dan maak je drie nieuwe dichotome variabelen (stijl 1 hoog of laag, etc). Vergelijk dan de gemiddelden van stijl 2 tussen de twee groepen 'stijl 1 hoog' en 'stijl 1 laag'. Als daar significant verschil in zit, heb je een conclusie.

Maar nogmaals, is maar een hersenscheetje.

Er zat WEL genoeg koriander in.

Hoe bedoel je dat precies? In de spoiler is mijn factoranalyse te zien.. hierin moeten de eerste 16 items de eerste leiderschapsstijl meten, de volgende 19 items de 2e leiderschapsstijl en de laatste 10 items de 3e leiderschapsstijlquote:Op vrijdag 3 juli 2015 10:12 schreef Anosmos het volgende:

Heb je al de Likertschalen samengevoegd tot één ratiovariabele (mits de cronbachs alpha goed zit natuurlijk)? Dan kan je wel mikken of ze significant van elkaar verschillen.

Wat je zou kunnen doen, maar dat is maar een hersenscheetje, is vaststellen wat 'hoog' is. Bijvoorbeeld, boven de 3,5 gemiddeld. Dan maak je drie nieuwe dichotome variabelen (stijl 1 hoog of laag, etc). Vergelijk dan de gemiddelden van stijl 2 tussen de twee groepen 'stijl 1 hoog' en 'stijl 1 laag'. Als daar significant verschil in zit, heb je een conclusie.

Maar nogmaals, is maar een hersenscheetje.

SPOILEROm spoilers te kunnen lezen moet je zijn ingelogd. Je moet je daarvoor eerst gratis Registreren. Ook kun je spoilers niet lezen als je een ban hebt.De cronbach's alphas zijn allemaal boven de 0.6 dus acceptabel. Alleen hoe moet ik nu precies verder? Het lastige is dus dat een stijl uit meerdere dimensies (=factoren?) bestaat.Fantasie is belangrijker dan kennis, want kennis is begrensd.

Kan je niet gewoon het gemiddelde nemen van elke stijl? Dus dat je van de eerste zestien items een gemiddelde neemt, waarmee je verder gaat rekenen?

En trouwens, vaak ligt de Cronbach's Alpha-grens op de 0,7 en niet de 0,6, maar dat verschilt nog per studie denk ik.

En trouwens, vaak ligt de Cronbach's Alpha-grens op de 0,7 en niet de 0,6, maar dat verschilt nog per studie denk ik.

Er zat WEL genoeg koriander in.

Hmm ja dat zou nog wel eens kunnen.. Dan moet ik per respondent zijn gemiddelde score nemen van de eerste 16 items, de volgende items behorende bij de andere leiderschapsstijl en van de laatste itemsquote:Op vrijdag 3 juli 2015 11:29 schreef Anosmos het volgende:

Kan je niet gewoon het gemiddelde nemen van elke stijl? Dus dat je van de eerste zestien items een gemiddelde neemt, waarmee je verder gaat rekenen?

En trouwens, vaak ligt de Cronbach's Alpha-grens op de 0,7 en niet de 0,6, maar dat verschilt nog per studie denk ik.

Fantasie is belangrijker dan kennis, want kennis is begrensd.

Dat is volgens mij wel het idee van een Likertschaal, dat je het gemiddelde daarvan als ratiovariabele kan beschouwen. Is het een soort Likertschaal?quote:Op vrijdag 3 juli 2015 13:29 schreef erniee het volgende:

[..]

Hmm ja dat zou nog wel eens kunnen.. Dan moet ik per respondent zijn gemiddelde score nemen van de eerste 16 items, de volgende items behorende bij de andere leiderschapsstijl en van de laatste items

Er zat WEL genoeg koriander in.

Yes! 7 punts likertschalen inderdaad. Heb via compute nu voor iedere leiderschapsstijl een nieuwe variabele gemaakt met het gemiddelde van alle bijbehorende itemscores. Dus nu drie nieuwe variabelen. Eens kijken wat ik nu moet gaan doen om dit te vergelijkenquote:Op vrijdag 3 juli 2015 16:57 schreef Anosmos het volgende:

[..]

Dat is volgens mij wel het idee van een Likertschaal, dat je het gemiddelde daarvan als ratiovariabele kan beschouwen. Is het een soort Likertschaal?

Fantasie is belangrijker dan kennis, want kennis is begrensd.

Er wordt geen hypothese getest en wordt slechts om een betrouwbaarheidsinterval gevraagdquote:Op zondag 5 juli 2015 16:04 schreef Super-B het volgende:

Goedemiddag! Ik zit met een kleine vraag waar ik momenteel geen antwoord op weet, vandaar dat ik het hier kom vragen:

Bij het antwoord op het volgende vraagstuk wordt een z-score gebruikt van 1.960 (bijbehorend bij een betrouwbaarheidsinterval van 95% en een one-sided P van 0,025). Waarom wordt daarentegen geen z-score van 1.645 gebruikt (bijbehorend bij een one-sided P van 0,05 en een betrouwbaarheidsinterval van 90%). Het is immers een eenzijdige hypothese test?:

[ afbeelding ]

[ afbeelding ]

Bij deze vraag, ook een eenzijdige hypothese test, wordt wel een z-score van 1.645 genomen (one-sided p van 0,05 en een betrouwbaarheidsinterval van 90%).

Zo ver ik weet kijk je naar de rij van betrouwbaarheidsintervallen bij tweezijdige hypothese testen, waartegen je kijkt naar de rij van one-sided p bij eenzijdige hypothese testen (?).

Heeft iemand enig idee?

Op dinsdag 1 november 2016 00:05 schreef JanCees het volgende:

De polls worden ook in 9 van de 10 gevallen gepeild met een meerderheid democraten. Soms zelf +10% _O-

De polls worden ook in 9 van de 10 gevallen gepeild met een meerderheid democraten. Soms zelf +10% _O-

Ik heb een vraag mbt de standaarddeviatie:

Hoe moet vraag 14 berekend worden?

Het antwoord is het volgende:

Ik begrijp er alleen niks van.

Hoe moet vraag 14 berekend worden?

Het antwoord is het volgende:

Ik begrijp er alleen niks van.

Weet iemand hoe ik vraag 19 kan berekenen?

[ Bericht 82% gewijzigd door GeschiktX op 13-07-2015 18:14:24 ]

[ Bericht 82% gewijzigd door GeschiktX op 13-07-2015 18:14:24 ]

Hoi!

Stel ik krijg de vraag op een tentamen om onderstaand te ordenen op basis van de kans waarop de nulhypothese wordt verworpen (van klein naar groot).

Je zou dan met tabel B.11 en de niet-centraliteitsparameter voor elke apart kunnen berekenen wat het onderscheidend vermorgen is en het op die manier ordenen, maar volgens mij moet je deze vraag ook zonder kunnen beantwoorden. Weet iemand een handige manier om dat te kunnen doen/benaderen? De vorige keer hadden ze die tabel en formule er nml niet bij gegeven.

Stel ik krijg de vraag op een tentamen om onderstaand te ordenen op basis van de kans waarop de nulhypothese wordt verworpen (van klein naar groot).

Je zou dan met tabel B.11 en de niet-centraliteitsparameter voor elke apart kunnen berekenen wat het onderscheidend vermorgen is en het op die manier ordenen, maar volgens mij moet je deze vraag ook zonder kunnen beantwoorden. Weet iemand een handige manier om dat te kunnen doen/benaderen? De vorige keer hadden ze die tabel en formule er nml niet bij gegeven.

Dat is een beetje een vreemde vraag want de nulhypothese wordt wel of niet verworpen, daar zit geen "kans" in. Met de informatie die je hebt kun je een t-value uitrekenen (verschil in means gedeeld door standaard-deviatie gedeeld door wortel n). Om van de t-value naar een p-waarde te gaan of om op tezoeken of dat extremer dan de alpha is heb je een tabel of grafische rekenmachine of internet / spss nodig. Als de alphas overal hetzelfde waren geweest had je het op t-waarde kunnen rangschikken.quote:Op zondag 19 juli 2015 11:37 schreef -Strawberry- het volgende:

Hoi!

Stel ik krijg de vraag op een tentamen om onderstaand te ordenen op basis van de kans waarop de nulhypothese wordt verworpen (van klein naar groot).

[ afbeelding ]

Je zou dan met tabel B.11 en de niet-centraliteitsparameter voor elke apart kunnen berekenen wat het onderscheidend vermorgen is en het op die manier ordenen, maar volgens mij moet je deze vraag ook zonder kunnen beantwoorden. Weet iemand een handige manier om dat te kunnen doen/benaderen? De vorige keer hadden ze die tabel en formule er nml niet bij gegeven.

Op dinsdag 1 november 2016 00:05 schreef JanCees het volgende:

De polls worden ook in 9 van de 10 gevallen gepeild met een meerderheid democraten. Soms zelf +10% _O-

De polls worden ook in 9 van de 10 gevallen gepeild met een meerderheid democraten. Soms zelf +10% _O-

Klopt, maar het onderscheidend vermogen is natuurlijk niet overal even hoog.quote:Op zondag 19 juli 2015 17:01 schreef oompaloompa het volgende:

[..]

Dat is een beetje een vreemde vraag want de nulhypothese wordt wel of niet verworpen, daar zit geen "kans" in. Met de informatie die je hebt kun je een t-value uitrekenen (verschil in means gedeeld door standaard-deviatie gedeeld door wortel n). Om van de t-value naar een p-waarde te gaan of om op tezoeken of dat extremer dan de alpha is heb je een tabel of grafische rekenmachine of internet / spss nodig. Als de alphas overal hetzelfde waren geweest had je het op t-waarde kunnen rangschikken.

Grafische rekenmachine en SPSS/internet zijn geen optie helaas. Het moet echt uit het hoofd door de steekproefgroottes, standaardafwijkingen en significanties te vergelijken. Dat de kans bij C bijvoorbeeld kleiner is dan D is logisch, aangezien de nulhypothese bij een significantie van 0.05 eerder zal worden verworpen dan bij een significantie van 0.02. Als ik zo het antwoord zie 'snap' ik het wel. Maar om dat onderling allemaal te ordenen bij verschillende steekproefgroottes en dergelijke vind ik op een tentamen niet te doen.

Het beroerde is dat ik gewoon vrij zeker weet dat die vraag gaat komen en dat ik hem niet precies goed ga ordenen.

Ik gok dat je statistiekdocent wil dat je inzicht hebt in hoe statistische toetsen werken. Als je dan eerst kijkt naar de gemiddelden, dan zie je dat in twee gevallen de drie gemiddeldes hetzelfde zijn. Daarnaast zie je dat bij A-D de verschillen in principe hetzelfde zijn. A-D zullen dan een hogere "kans" op significantie hebben (tussen aanhalingstekens wegens oompa's terechte post). Vervolgens kun je bij die verschillende varianten gaan kijken naar de andere gegevens en op basis van de formules die doorgaans gebruikt worden schatten wat het meeste de "kans" beïnvloed etc.quote:Op zondag 19 juli 2015 17:12 schreef -Strawberry- het volgende:

[..]

Klopt, maar het onderscheidend vermogen is natuurlijk niet overal even hoog.

[ afbeelding ]

Grafische rekenmachine en SPSS/internet zijn geen optie helaas. Het moet echt uit het hoofd door de steekproefgroottes, standaardafwijkingen en significanties te vergelijken. Dat de kans bij C bijvoorbeeld kleiner is dan D is logisch, aangezien de nulhypothese bij een significantie van 0.05 eerder zal worden verworpen dan bij een significantie van 0.02. Als ik zo het antwoord zie 'snap' ik het wel. Maar om dat onderling allemaal te ordenen bij verschillende steekproefgroottes en dergelijke vind ik op een tentamen niet te doen.

Het beroerde is dat ik gewoon vrij zeker weet dat die vraag gaat komen en dat ik hem niet precies goed ga ordenen.

Ik hoop niet dat de vraag gaat komen, want de vraag klopt nietquote:Op zondag 19 juli 2015 17:12 schreef -Strawberry- het volgende:

[..]

Klopt, maar het onderscheidend vermogen is natuurlijk niet overal even hoog.

[ afbeelding ]

Grafische rekenmachine en SPSS/internet zijn geen optie helaas. Het moet echt uit het hoofd door de steekproefgroottes, standaardafwijkingen en significanties te vergelijken. Dat de kans bij C bijvoorbeeld kleiner is dan D is logisch, aangezien de nulhypothese bij een significantie van 0.05 eerder zal worden verworpen dan bij een significantie van 0.02. Als ik zo het antwoord zie 'snap' ik het wel. Maar om dat onderling allemaal te ordenen bij verschillende steekproefgroottes en dergelijke vind ik op een tentamen niet te doen.

Het beroerde is dat ik gewoon vrij zeker weet dat die vraag gaat komen en dat ik hem niet precies goed ga ordenen.

Bij welke opleiding hoort dit?

Je kunt met berederen redelijk ver komen. Bv E en F hebben identieke gemiddeldes, daar zit dus zeker geen verschil tussen.

G en A zijn in essentie hetzelfde, de ene heeft een verschil van 10 met een sd van 10, de andere een verschil van 20 met een sd van 20. Als je die in de formule zou stoppen zou er (aangezien de n bij allebei 100 is) exact dezelfde t waarde uit moeten komen, etc.

B is hetzelfde als A maar met een grotere sd, dus B zal minder sig zijn dan A.

D is hetzelfde als B, maar met een lagere n, als je dat in de formule zou stoppen zou er dus een lagere t uitkomen dus is nog minder sig.

C is als D maar met een strengere alfa die is dus nog minder significant.

Kom je uit op:

E&F, C, D, B, A&G

Het antwoord dat gegeven wordt klopt niet, E&F zouden de laagste plaats moeten delen.

[ Bericht 6% gewijzigd door oompaloompa op 19-07-2015 18:25:47 ]

Op dinsdag 1 november 2016 00:05 schreef JanCees het volgende:

De polls worden ook in 9 van de 10 gevallen gepeild met een meerderheid democraten. Soms zelf +10% _O-

De polls worden ook in 9 van de 10 gevallen gepeild met een meerderheid democraten. Soms zelf +10% _O-

Klopt wel, tussen de gemiddeldes van E en F zit namelijk geen verschil (alle drie 100). De nulhypothese dat de gemiddeldes van elkaar verschillen zal dus niet verworpen worden bij een hoog onderscheidend vermogen. Gezien de steekproeven van n=500 en n=1000 zal het onderscheidend vermogen hoog zijn, waardoor de kans van E & F om verworpen te worden kleiner is dan bij de rest.quote:Op zondag 19 juli 2015 18:17 schreef oompaloompa het volgende:

[..]

Ik hoop niet dat de vraag gaat komen, want de vraag klopt niet

Bij welke opleiding hoort dit?

Je kunt met berederen redelijk ver komen. Bv E en F hebben identieke gemiddeldes, daar zit dus zeker geen verschil tussen.

G en A zijn in essentie hetzelfde, de ene heeft een verschil van 10 met een sd van 10, de andere een verschil van 20 met een sd van 20. Als je die in de formule zou stoppen zou er (aangezien de n bij allebei 100 is) exact dezelfde t waarde uit moeten komen, etc.

B is hetzelfde als A maar met een grotere sd, dus B zal minder sig zijn dan A.

D is hetzelfde als B, maar met een lagere n, als je dat in de formule zou stoppen zou er dus een lagere t uitkomen dus is nog minder sig.

C is als D maar met een strengere alfa die is dus nog minder significant.

Kom je uit op:

E&F, C, D, B, A&G

Het antwoord dat gegeven wordt klopt niet, E&F zouden de laagste plaats moeten delen.

Bedankt voor je reactie iig.

Dat is niet waar, de formule is:quote:Op zondag 19 juli 2015 18:42 schreef -Strawberry- het volgende:

[..]

Klopt wel, tussen de gemiddeldes van E en F zit namelijk geen verschil (alle drie 100). De nulhypothese dat de gemiddeldes van elkaar verschillen zal dus niet verworpen worden bij een hoog onderscheidend vermogen. Gezien de steekproeven van n=500 en n=1000 zal het onderscheidend vermogen hoog zijn, waardoor de kans van E & F om verworpen te worden kleiner is dan bij de rest.

Bedankt voor je reactie iig.Ik zie het morgen wel.

verschil in means / vanalles.

Het verschil in means is in beide gevallen 0, 0/whatever is 0. de "kans" dat het verworpen wordt is voor beide situaties 0

Het is echt een extreem slechte opgave van de docent, de vraag slaat nergens op en het leert de studenten gewoon een verkeerde interpretstie van statistiek aan.

edit: sorry dit frustreert me maar het is niet richting jou. Ik geef workshops etc. statistiek en mensen interpreteren het al zo vaak verkeerd dat het zien dat docenten het verkeerd aanleren me nogal opgefokt maakt.

Op dinsdag 1 november 2016 00:05 schreef JanCees het volgende:

De polls worden ook in 9 van de 10 gevallen gepeild met een meerderheid democraten. Soms zelf +10% _O-

De polls worden ook in 9 van de 10 gevallen gepeild met een meerderheid democraten. Soms zelf +10% _O-

Sorry ik had verkeerd gelezen. Dacht dat je bedoelde dat E & F in de ordening achteraan moesten staan.quote:Op zondag 19 juli 2015 18:49 schreef oompaloompa het volgende:

[..]

Dat is niet waar, de formule is:

verschil in means / vanalles.

Het verschil in means is in beide gevallen 0, 0/whatever is 0. de "kans" dat het verworpen wordt is voor beide situaties 0

Het is echt een extreem slechte opgave van de docent, de vraag slaat nergens op en het leert de studenten gewoon een verkeerde interpretstie van statistiek aan.

edit: sorry dit frustreert me maar het is niet richting jou. Ik geef workshops etc. statistiek en mensen interpreteren het al zo vaak verkeerd dat het zien dat docenten het verkeerd aanleren me nogal opgefokt maakt.

Ik vind het ook een belachelijke vraag voor een tentamen verder.

Hallo allemaal,

Op dit moment voer ik een lezersonderzoek uit en loop tegen een aantal zaken aan. Ik vroeg mij af of op dit forum toevallig mensen zijn die meer ervaring hebben met marktonderzoek/statistiek en voor mij iets kunnen verhelderen.

De online enquête heb ik verstuurd naar de e-mailadressen uit het adressenbestand. Na het versturen van de enquête en een herinnering blijft de respons enorm achter. Ik had gehoopt op minstens 171 respondenten, zodat ik een uitspraak zou kunnen doen met 90% betrouwbaarheid en een nauwkeurigheidsmarge van 6%. Maar omdat ik maar 101 reacties heb gekregen zit ik nu weer te rekenen met het betrouwbaarheidsniveau en de nauwkeurigheidsmarge.

Ik weet dat 5% nauwkeurigheidsmarge gangbaar is, maar voor mijn onderzoek is dat niet haalbaar. Online kan ik nergens vinden wat de consequentie is voor uitspraken in een onderzoek als de nauwkeurigheidsmarge tussen de 6-10% ligt.

In mijn specifieke geval kan ik de marges en het niveau als volgt aanpassen:

Bij 95% betrouwbaarheid en 10% nauwkeurigheidsmarge heb ik 92 respondenten nodig.

Bij 90% betrouwbaarheid en 8% nauwkeurigheidsmarge heb ik 100 respondenten nodig.

Kan ik met deze betrouwbaarheid en nauwkeurigheid nog wel uitspraken doen over het adressenbestand? Maakt een hogere nauwkeurigheidsmarge een onderzoek minder valide of een lager betrouwbaarheidsniveau? Wat is het meest verstandige om te doen?

Op dit moment voer ik een lezersonderzoek uit en loop tegen een aantal zaken aan. Ik vroeg mij af of op dit forum toevallig mensen zijn die meer ervaring hebben met marktonderzoek/statistiek en voor mij iets kunnen verhelderen.

De online enquête heb ik verstuurd naar de e-mailadressen uit het adressenbestand. Na het versturen van de enquête en een herinnering blijft de respons enorm achter. Ik had gehoopt op minstens 171 respondenten, zodat ik een uitspraak zou kunnen doen met 90% betrouwbaarheid en een nauwkeurigheidsmarge van 6%. Maar omdat ik maar 101 reacties heb gekregen zit ik nu weer te rekenen met het betrouwbaarheidsniveau en de nauwkeurigheidsmarge.

Ik weet dat 5% nauwkeurigheidsmarge gangbaar is, maar voor mijn onderzoek is dat niet haalbaar. Online kan ik nergens vinden wat de consequentie is voor uitspraken in een onderzoek als de nauwkeurigheidsmarge tussen de 6-10% ligt.

In mijn specifieke geval kan ik de marges en het niveau als volgt aanpassen:

Bij 95% betrouwbaarheid en 10% nauwkeurigheidsmarge heb ik 92 respondenten nodig.

Bij 90% betrouwbaarheid en 8% nauwkeurigheidsmarge heb ik 100 respondenten nodig.

Kan ik met deze betrouwbaarheid en nauwkeurigheid nog wel uitspraken doen over het adressenbestand? Maakt een hogere nauwkeurigheidsmarge een onderzoek minder valide of een lager betrouwbaarheidsniveau? Wat is het meest verstandige om te doen?

Delivered without an information leaflet

Ik doe vaak marktonderzoek met relatief lage n-en en kies er altijd voor 95% betrouwbaarheid. Dan kan je uiteraard niet al te stellige uitspraken doen, maar er zullen überhaupt bijna geen significante verschillen zijn. Wel significante verschillen met een lager betrouwbaarheid (of een hogere onbetrouwbaarheid) vind ik niet interessant.

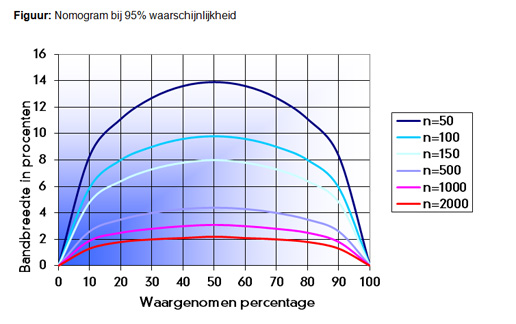

Onderstaand figuur is wel inzichtelijk:

Bij 50% is de marge altijd het grootst. Dus in jouw geval, als je het onderzoek nog een keer zou uitvoeren, zal een uitkomst van 50% in ene herhalingsonderzoek ergens tussen de 40% en 60% liggen.

Let wel, dit is een mening van een marktonderzoeker, de wetenschappers hier denken er wellicht anders over.

Onderstaand figuur is wel inzichtelijk:

Bij 50% is de marge altijd het grootst. Dus in jouw geval, als je het onderzoek nog een keer zou uitvoeren, zal een uitkomst van 50% in ene herhalingsonderzoek ergens tussen de 40% en 60% liggen.

Let wel, dit is een mening van een marktonderzoeker, de wetenschappers hier denken er wellicht anders over.

Aldus.

Thanks, Z. Maar om heel eerlijk te zijn begrijp ik niet zo goed wat het verschil is tussen een grotere nauwkeurigheid of een kleinere betrouwbaarheid. Kan jij het mij uitleggen in jip en janneke taal? Ik wil het heel graag begrijpen, zodat ik mijn keuze ook goed kan verantwoorden. Het enige dat ik weet is dat je bij een nauwkeurigheid niet meer dan 10% neemt en bij een betrouwbaarheid nooit lager dan 90% gaat.. Maar wat het wezenlijke verschil nou is en "belangrijker"?quote:

Kan ik überhaupt wel afstuderen met zulke betrouwbaarheidsniveaus (95/90%) en foutmarges (10/8%)?

Delivered without an information leaflet

Heb gedaan wat jij suggereerde. Dus 3 dichtome variabelen gemaakt (hoge score/lage score per leiderschapsstijl) en vervolgens deze via een independent t-test vergeleken met de gemiddelde scores op de andere leiderschapsstijl. (uitkomst is niet significant). Maar vraag me nog altijd wel af of ik wel mag concluderen dat ze dan wel (of in dit geval dus niet) significant van elkaar verschillen..quote:Op vrijdag 3 juli 2015 10:12 schreef Anosmos het volgende:

Heb je al de Likertschalen samengevoegd tot één ratiovariabele (mits de cronbachs alpha goed zit natuurlijk)? Dan kan je wel mikken of ze significant van elkaar verschillen.

Wat je zou kunnen doen, maar dat is maar een hersenscheetje, is vaststellen wat 'hoog' is. Bijvoorbeeld, boven de 3,5 gemiddeld. Dan maak je drie nieuwe dichotome variabelen (stijl 1 hoog of laag, etc). Vergelijk dan de gemiddelden van stijl 2 tussen de twee groepen 'stijl 1 hoog' en 'stijl 1 laag'. Als daar significant verschil in zit, heb je een conclusie.

Maar nogmaals, is maar een hersenscheetje.

Maar nogmaals bedankt! Ben in ieder geval al verder dan ik voorheen was

Fantasie is belangrijker dan kennis, want kennis is begrensd.

Wat voor studie doe je?quote:Op maandag 27 juli 2015 15:34 schreef gekke_sandra het volgende:

[..]

Thanks, Z. Maar om heel eerlijk te zijn begrijp ik niet zo goed wat het verschil is tussen een grotere nauwkeurigheid of een kleinere betrouwbaarheid. Kan jij het mij uitleggen in jip en janneke taal? Ik wil het heel graag begrijpen, zodat ik mijn keuze ook goed kan verantwoorden. Het enige dat ik weet is dat je bij een nauwkeurigheid niet meer dan 10% neemt en bij een betrouwbaarheid nooit lager dan 90% gaat.. Maar wat het wezenlijke verschil nou is en "belangrijker"?

Kan ik überhaupt wel afstuderen met zulke betrouwbaarheidsniveaus (95/90%) en foutmarges (10/8%)?

Aldus.

Ik wil de volgende hypotheses van het onderstaande model testen (groen = significant, rood = niet significant)

Ik wil geen Sobel test gebruik om het indirect effect te berekenen, maar een bootstrap of de t/p-values. Alleen ik loop vast met het toepassen ervan, sterker nog, ik heb gewoon geen idee hoe ik dit moet berekenen.

Het model heb ik getest in SmartPLS, weet iemand hoe ik dit kan berekenen

Ik wil geen Sobel test gebruik om het indirect effect te berekenen, maar een bootstrap of de t/p-values. Alleen ik loop vast met het toepassen ervan, sterker nog, ik heb gewoon geen idee hoe ik dit moet berekenen.

Het model heb ik getest in SmartPLS, weet iemand hoe ik dit kan berekenen

BlaBlaBla

Ik heb ook nog een andere vraag, ik heb in mijn onderzoek enkele P waardes die hoger liggen dan de algemeen geaccepteerde cut-off point van p=0.05, namelijk p=0.054 en p=0.056.

Ondanks dat ze hoger dan de cut-off point liggen, wil ik er wel iets over zeggen, maar niet in de trant van: 'a nonsignificant trend' of 'a small trend'.

Tips?

Ondanks dat ze hoger dan de cut-off point liggen, wil ik er wel iets over zeggen, maar niet in de trant van: 'a nonsignificant trend' of 'a small trend'.

Tips?

BlaBlaBla

quote:Op donderdag 30 juli 2015 09:59 schreef Soldier2000 het volgende:

Ik heb ook nog een andere vraag, ik heb in mijn onderzoek enkele P waardes die hoger liggen dan de algemeen geaccepteerde cut-off point van p=0.05, namelijk p=0.054 en p=0.056.

Ondanks dat ze hoger dan de cut-off point liggen, wil ik er wel iets over zeggen, maar niet in de trant van: 'a nonsignificant trend' of 'a small trend'.

Tips?

SPOILEROm spoilers te kunnen lezen moet je zijn ingelogd. Je moet je daarvoor eerst gratis Registreren. Ook kun je spoilers niet lezen als je een ban hebt.legio mogelijkheden!

'Expand my brain, learning juice!'

<a href="http://www.last.fm/user/crossover1" rel="nofollow" target="_blank">Last.fm</a>

quote:Op vrijdag 31 juli 2015 08:23 schreef crossover het volgende:

[..]Maar dat is allemaal ongeveer hetzelfde in andere bewoording. Ik denk dat hij eerder iets zoekt als groepsgrootte net te klein om significantie aan te tonen. Grotere groep waarschijnlijk wel significant.SPOILEROm spoilers te kunnen lezen moet je zijn ingelogd. Je moet je daarvoor eerst gratis Registreren. Ook kun je spoilers niet lezen als je een ban hebt.legio mogelijkheden!

"Happiness is not getting more, but wanting less"

Ja, of het effect/verschil is te klein voor deze groep.quote:Op vrijdag 31 juli 2015 09:50 schreef ssebass het volgende:

[..]

Maar dat is allemaal ongeveer hetzelfde in andere bewoording. Ik denk dat hij eerder iets zoekt als groepsgrootte net te klein om significantie aan te tonen. Grotere groep waarschijnlijk wel significant.

'Expand my brain, learning juice!'

<a href="http://www.last.fm/user/crossover1" rel="nofollow" target="_blank">Last.fm</a>

<a href="http://www.last.fm/user/crossover1" rel="nofollow" target="_blank">Last.fm</a>

Ik wil iets over die hypothese zeggen, niet simpel weg, hoger dan 0.05, dus niet significant, niet bewezen and that's it. Maar wel iets dat aanvaardbaar is.

BlaBlaBla

Wat we hierboven dus zeggen. Dat het effect (net) te klein is om met deze groep aan tonen, maar met een iets grotere groep waarschijnlijk wel significant is. Je kunt het nu niet significant lullen, tenzij je je data gaat aanpassen maar dan moet je Diederik Stapel maar even om advies vragen...quote:Op vrijdag 31 juli 2015 11:16 schreef Soldier2000 het volgende:

Ik wil iets over die hypothese zeggen, niet simpel weg, hoger dan 0.05, dus niet significant, niet bewezen and that's it. Maar wel iets dat aanvaardbaar is.

"Happiness is not getting more, but wanting less"

Beste forumlezers,

Ik heb een vraag voor mijn scriptie. Ik heb de correlatie berekend tussen een onafhankelijke en een afhankelijke variabele. Deze samenhang bleek laag (+ niet significant). Nu wil ik graag weten of een andere variabele, namelijk leeftijd (continue variabele), dit verband beïnvloedt. Kan ik dit uberhaupt meten wanneer er geen significante samenhang was? En hoe dan? Via een multipele regressieanalyse? En moet ik van de moderatorvariabele dan een categorische variabele maken, of kan dit met een continue variabele? Ter informatie: de onafhankelijke en de afhankelijke variabelen zijn beiden continue, maar ik kan van de afhankelijke variabele ook een categorische variabele maken.

Groetjes,

Iris

Ik heb een vraag voor mijn scriptie. Ik heb de correlatie berekend tussen een onafhankelijke en een afhankelijke variabele. Deze samenhang bleek laag (+ niet significant). Nu wil ik graag weten of een andere variabele, namelijk leeftijd (continue variabele), dit verband beïnvloedt. Kan ik dit uberhaupt meten wanneer er geen significante samenhang was? En hoe dan? Via een multipele regressieanalyse? En moet ik van de moderatorvariabele dan een categorische variabele maken, of kan dit met een continue variabele? Ter informatie: de onafhankelijke en de afhankelijke variabelen zijn beiden continue, maar ik kan van de afhankelijke variabele ook een categorische variabele maken.

Groetjes,

Iris

Even newbie question hoor

Maar hoe kan ik het volgende in excel maken?

in cel a1 staat x, als dan in cel a2 y staat moet cel a1 rood worden.

Hoe doe ik dat met voorwaardelijke opmaak?

Maar hoe kan ik het volgende in excel maken?

in cel a1 staat x, als dan in cel a2 y staat moet cel a1 rood worden.

Hoe doe ik dat met voorwaardelijke opmaak?

"Fifty years ago the Leningrad street taught me a rule - if a fight is inevitable, you have to throw the first punch."

Vladimir Putin

“To forgive the terrorists is up to God, but to send them there is up to me.”

Vladimir Putin

Vladimir Putin

“To forgive the terrorists is up to God, but to send them there is up to me.”

Vladimir Putin

Heb je hiervoor nog een oplossing gevonden? Ik heb voor mijn thesis de process macro van Hayes geïnstalleerd in SPSS. Dat werkt enorm goed alleen heeft wel enige instructie nodig.quote:Op woensdag 29 juli 2015 20:02 schreef Soldier2000 het volgende:

Ik wil de volgende hypotheses van het onderstaande model testen (groen = significant, rood = niet significant)

Ik wil geen Sobel test gebruik om het indirect effect te berekenen, maar een bootstrap of de t/p-values. Alleen ik loop vast met het toepassen ervan, sterker nog, ik heb gewoon geen idee hoe ik dit moet berekenen.

Het model heb ik getest in SmartPLS, weet iemand hoe ik dit kan berekenen

[ afbeelding ]

je kunt gewoon bij conditional formatting A1 selecteren "new rule" -> "use formula to determine which cells to format" ... en dan daar =A2=y in zetten als je het voor een hele kolom wil dan zet je er =$A2=y neerquote:Op dinsdag 11 augustus 2015 15:30 schreef phpmystyle het volgende:

Even newbie question hoor

Maar hoe kan ik het volgende in excel maken?

in cel a1 staat x, als dan in cel a2 y staat moet cel a1 rood worden.

Hoe doe ik dat met voorwaardelijke opmaak?

[ Bericht 2% gewijzigd door Bosbeetle op 18-08-2015 18:42:16 ]

En mochten we vallen dan is het omhoog. - Krang (uit: Pantani)

My favourite music is the music I haven't yet heard - John Cage

Water: ijskoud de hardste - Gehenna

My favourite music is the music I haven't yet heard - John Cage

Water: ijskoud de hardste - Gehenna

Ik heb een aantal vragen over mijn dataverwerking.

-Niet elke respondent heeft op mijn enquête een leeftijd ingevuld. Ik had de keuze om die vraag verplicht te maken, echter heb je dan kans dat men de enquete daar al afbreekt. De andere optie is vragen niet allemaal verplicht maken. Ik zou volgens mijn begeleider die specifieke missende leeftijden niet mee moeten nemen. Je hebt missing-pairwise en missing-listwise maar verder gaf hij geen tips. Iemand anders zei dat je het ook op kunt lossen door op de plaats van de missende leeftijden het gemiddelde / de modus of de mediaan van alle leeftijden neer kan zetten, echter dat dit een mindere optie was. Weet iemand hoe ik deze specifieke missende leeftijden (ik denk bij 10 van de 300 respondenten) eruit laat?

-Ik heb mijn data verzamelt in Qualtrics in aparte mapjes. Dus elk projectteam wat ik ondervraagd heb staat in een aparte map met daarin een enquete. Heeft iemand een idee hoe ik dit makkelijk kan samenvoegen met de teamleider enquêtes (aparte survey).

-Vervolgens moet ik mijn data aggregeren naar team level via ICC. Ik zie wel wat filmpjes, maar welke variabelen moet ik wel en niet meeenemen in de analyse?

-Heeft er iemand verstand van de Hayes process macro waarmee je mediatoren / moderatoren kan testen?

[ Bericht 5% gewijzigd door W00fer op 15-10-2015 15:54:08 ]

-Niet elke respondent heeft op mijn enquête een leeftijd ingevuld. Ik had de keuze om die vraag verplicht te maken, echter heb je dan kans dat men de enquete daar al afbreekt. De andere optie is vragen niet allemaal verplicht maken. Ik zou volgens mijn begeleider die specifieke missende leeftijden niet mee moeten nemen. Je hebt missing-pairwise en missing-listwise maar verder gaf hij geen tips. Iemand anders zei dat je het ook op kunt lossen door op de plaats van de missende leeftijden het gemiddelde / de modus of de mediaan van alle leeftijden neer kan zetten, echter dat dit een mindere optie was. Weet iemand hoe ik deze specifieke missende leeftijden (ik denk bij 10 van de 300 respondenten) eruit laat?

-Ik heb mijn data verzamelt in Qualtrics in aparte mapjes. Dus elk projectteam wat ik ondervraagd heb staat in een aparte map met daarin een enquete. Heeft iemand een idee hoe ik dit makkelijk kan samenvoegen met de teamleider enquêtes (aparte survey).

-Vervolgens moet ik mijn data aggregeren naar team level via ICC. Ik zie wel wat filmpjes, maar welke variabelen moet ik wel en niet meeenemen in de analyse?

-Heeft er iemand verstand van de Hayes process macro waarmee je mediatoren / moderatoren kan testen?

[ Bericht 5% gewijzigd door W00fer op 15-10-2015 15:54:08 ]

Friettent dikke Willie, met Willie

Als je leeftijden alleen gebruikt als onderdeel van de demografische gegevens in je methode sectie, dan zou ik gewoon via SPSS de gemiddelde leeftijd en standaarddeviatie berekenen. Hij neemt dan automatisch (volgens mij, heb even geen SPSS bij de hand om het te proberen) alleen de cases mee waarbij er een waarde is voor die variabele. Als je met de leeftijden wilt gaan rekenen wordt het een ander verhaal, maar dan heb ik meer informatie nodig over je onderzoeksopzet.quote:Op donderdag 15 oktober 2015 15:39 schreef W00fer het volgende:

Ik heb een aantal vragen over mijn dataverwerking.

-Niet elke respondent heeft op mijn enquête een leeftijd ingevuld. Ik had de keuze om die vraag verplicht te maken, echter heb je dan kans dat men de enquete daar al afbreekt. De andere optie is vragen niet allemaal verplicht maken. Ik zou volgens mijn begeleider die specifieke missende leeftijden niet mee moeten nemen. Je hebt missing-pairwise en missing-listwise maar verder gaf hij geen tips. Iemand anders zei dat je het ook op kunt lossen door op de plaats van de missende leeftijden het gemiddelde / de modus of de mediaan van alle leeftijden neer kan zetten, echter dat dit een mindere optie was. Weet iemand hoe ik deze specifieke missende leeftijden (ik denk bij 10 van de 300 respondenten) eruit laat?

Klinkt alsof elke enquete door Qualtrics als uniek wordt gezien (met daarbinnen de data van elk projectteam). In dat geval is het handigste (denk ik) om alle data te exporteren naar SPSS, zorgen dat de variabelen hetzelfde heten en meten en dan merge files (add cases, niet variables).quote:-Ik heb mijn data verzamelt in Qualtrics in aparte mapjes. Dus elk projectteam wat ik ondervraagd heb staat in een aparte map met daarin een enquete. Heeft iemand een idee hoe ik dit makkelijk kan samenvoegen met de teamleider enquêtes (aparte survey).

ICC zegt me zo 1 2 3 niets, wat bedoel je hier precies?quote:-Vervolgens moet ik mijn data aggregeren naar team level via ICC. Ik zie wel wat filmpjes, maar welke variabelen moet ik wel en niet meeenemen in de analyse?

Geen idee, sorry.quote:-Heeft er iemand verstand van de Hayes process macro waarmee je mediatoren / moderatoren kan testen?

Om de teams uit elkaar te houden heb ik het zo gedaanquote:Op donderdag 15 oktober 2015 16:02 schreef Operc het volgende:

[..]

Als je leeftijden alleen gebruikt als onderdeel van de demografische gegevens in je methode sectie, dan zou ik gewoon via SPSS de gemiddelde leeftijd en standaarddeviatie berekenen. Hij neemt dan automatisch (volgens mij, heb even geen SPSS bij de hand om het te proberen) alleen de cases mee waarbij er een waarde is voor die variabele. Als je met de leeftijden wilt gaan rekenen wordt het een ander verhaal, maar dan heb ik meer informatie nodig over je onderzoeksopzet.

[..]

Klinkt alsof elke enquete door Qualtrics als uniek wordt gezien (met daarbinnen de data van elk projectteam). In dat geval is het handigste (denk ik) om alle data te exporteren naar SPSS, zorgen dat de variabelen hetzelfde heten en meten en dan merge files (add cases, niet variables).

[..]

ICC zegt me zo 1 2 3 niets, wat bedoel je hier precies?

[..]

Geen idee, sorry.

Mapje HEMA team

-Teamleden enquete

-Teamleider enquete

Mapje Bart Smit team

-Teamleden enquete

-Teamleider enquete

ICC is ervoor om de resultaten van teamleden te aggregeren naar teamniveau, aangezien de variabelen in mijn onderzoeksmodel op teamniveau conclusies geven (Unit of Analysis is teamlevel, unit of observation individual level).

Wat bedoel je met die merge files met cases, voegt hij anders kolommen toe als ik voor variables kies?

Friettent dikke Willie, met Willie

Oké, ik neem aan dat je de vragenlijst dus gekopieerd hebt naar die mapjes? Dan zijn het voor Qualtrics (denk ik) onafhankelijke vragenlijsten geworden, ieder met de eigen deelnemers (HemaLeden/HemaLeider/BartLeden/BartLeider). Het is dan het handigste om dit na het downloaden van de data samen te voegen denk ik.quote:Op donderdag 15 oktober 2015 16:07 schreef W00fer het volgende:

[..]

Om de teams uit elkaar te houden heb ik het zo gedaan

Mapje HEMA team

-Teamleden enquete

-Teamleider enquete

Mapje Bart Smit team

-Teamleden enquete

-Teamleider enquete

Ik heb geen ervaring met multi-level analysis helaas, misschien dat anderen je hier daar beter mee kunnen helpen.quote:ICC is ervoor om de resultaten van teamleden te aggregeren naar teamniveau, aangezien de variabelen in mijn onderzoeksmodel op teamniveau conclusies geven (Unit of Analysis is teamlevel, unit of observation individual level).

Ja. Dus als je bijvoorbeeld een dataset hebt met leeftijd en geslacht van deelnemers 1-50 en een andere dataset met leeftijd en geslacht van deelnemers 51-100, dan kun je die tweede met die eerste 'mergen' op 'cases' om deelnemers 51-100 aan de dataset van deelnemers 1-50 toe te voegen. Als je op variabele zou mergen zou je opeens 4 variabelen hebben, geslacht, leeftijd en nog eens geslacht en leeftijd. Dat wordt een redelijke bende.quote:Wat bedoel je met die merge files met cases, voegt hij anders kolommen toe als ik voor variables kies?

Ja ik heb de lege surveys vooraf gekopieerd.quote:Op donderdag 15 oktober 2015 16:11 schreef Operc het volgende:

[..]

Oké, ik neem aan dat je de vragenlijst dus gekopieerd hebt naar die mapjes? Dan zijn het voor Qualtrics (denk ik) onafhankelijke vragenlijsten geworden, ieder met de eigen deelnemers (HemaLeden/HemaLeider/BartLeden/BartLeider). Het is dan het handigste om dit na het downloaden van de data samen te voegen denk ik.

[..]

Ik heb geen ervaring met multi-level analysis helaas, misschien dat anderen je hier daar beter mee kunnen helpen.

[..]

Ja. Dus als je bijvoorbeeld een dataset hebt met leeftijd en geslacht van deelnemers 1-50 en een andere dataset met leeftijd en geslacht van deelnemers 51-100, dan kun je die tweede met die eerste 'mergen' op 'cases' om deelnemers 51-100 aan de dataset van deelnemers 1-50 toe te voegen. Als je op variabele zou mergen zou je opeens 4 variabelen hebben, geslacht, leeftijd en nog eens geslacht en leeftijd. Dat wordt een redelijke bende.

Enig idee hoe ik de teamleider survey aan de teamleden survey moet koppelen?

De teamleider heeft dmv 12 vragen zijn teamleden beoordeeld, de teamleden hebben dmv 19 vragen hun werkzaamheden beoordeeld. Ik neem aan dat je linaire regressie doet door bijv independent variable "werkzaamheden" op "teamprestaties" toch zijn dit compleet andere vragenlijsten? Ik wil kijken in hoeverre de werkzaamheden van invloed zijn op de prestaties.

Friettent dikke Willie, met Willie

In de SPSS bestanden even een variabele aanmaken met proefpersoonnummer van de teamleden. Daarna merge -> add variables en dan kun je als het goed is ergens aanklikken dat het gebaseerd moet zijn op dat proefpersoonnummer, dan krijg je (als het goed is) een dataset met de antwoorden van je teamleden en daarnaast de beoordelingen van de teamleider.quote:Op donderdag 15 oktober 2015 16:36 schreef W00fer het volgende:

Enig idee hoe ik de teamleider survey aan de teamleden survey moet koppelen?

Het ligt eraan of alle vragen van elke lijst hetzelfde meten (factoranalyse enzo). Als dat zo is kun je eventueel totaalscores maken en vervolgens correlaties berekenen of andere regressie-analyses uitvoeren. Dat ligt aan je onderzoeksvragen, precieze data en structuur.quote:De teamleider heeft dmv 12 vragen zijn teamleden beoordeeld, de teamleden hebben dmv 19 vragen hun werkzaamheden beoordeeld. Ik neem aan dat je linaire regressie doet door bijv independent variable "werkzaamheden" op "teamprestaties" toch zijn dit compleet andere vragenlijsten? Ik wil kijken in hoeverre de werkzaamheden van invloed zijn op de prestaties.

Moet je mediation testen of moderation?quote:Op donderdag 15 oktober 2015 15:39 schreef W00fer het volgende:

Ik heb een aantal vragen over mijn dataverwerking.

-Niet elke respondent heeft op mijn enquête een leeftijd ingevuld. Ik had de keuze om die vraag verplicht te maken, echter heb je dan kans dat men de enquete daar al afbreekt. De andere optie is vragen niet allemaal verplicht maken. Ik zou volgens mijn begeleider die specifieke missende leeftijden niet mee moeten nemen. Je hebt missing-pairwise en missing-listwise maar verder gaf hij geen tips. Iemand anders zei dat je het ook op kunt lossen door op de plaats van de missende leeftijden het gemiddelde / de modus of de mediaan van alle leeftijden neer kan zetten, echter dat dit een mindere optie was. Weet iemand hoe ik deze specifieke missende leeftijden (ik denk bij 10 van de 300 respondenten) eruit laat?

-Ik heb mijn data verzamelt in Qualtrics in aparte mapjes. Dus elk projectteam wat ik ondervraagd heb staat in een aparte map met daarin een enquete. Heeft iemand een idee hoe ik dit makkelijk kan samenvoegen met de teamleider enquêtes (aparte survey).

-Vervolgens moet ik mijn data aggregeren naar team level via ICC. Ik zie wel wat filmpjes, maar welke variabelen moet ik wel en niet meeenemen in de analyse?

-Heeft er iemand verstand van de Hayes process macro waarmee je mediatoren / moderatoren kan testen?

Beiden. Ik heb zowel een mediator als moderator.quote:Op donderdag 15 oktober 2015 23:49 schreef MCH het volgende:

[..]

Moet je mediation testen of moderation?

Friettent dikke Willie, met Willie

Ik ga eerst de cronbachs alpha berekenen om te kijken of ik wat vragen eruit kan gooien. Die totaalscores per team hoe werkt dat?quote:Op donderdag 15 oktober 2015 16:53 schreef Operc het volgende:

[..]

In de SPSS bestanden even een variabele aanmaken met proefpersoonnummer van de teamleden. Daarna merge -> add variables en dan kun je als het goed is ergens aanklikken dat het gebaseerd moet zijn op dat proefpersoonnummer, dan krijg je (als het goed is) een dataset met de antwoorden van je teamleden en daarnaast de beoordelingen van de teamleider.

[..]

Het ligt eraan of alle vragen van elke lijst hetzelfde meten (factoranalyse enzo). Als dat zo is kun je eventueel totaalscores maken en vervolgens correlaties berekenen of andere regressie-analyses uitvoeren. Dat ligt aan je onderzoeksvragen, precieze data en structuur.

Friettent dikke Willie, met Willie

Dus eigenlijk heb je moderated mediation? Is je moderator binary?quote:Op vrijdag 16 oktober 2015 10:01 schreef W00fer het volgende:

[..]

Beiden. Ik heb zowel een mediator als moderator.

En misschien is het handig om te vertellen welke van de 76 modellen je wil gaan testen:

http://www.afhayes.com/public/templates.pdf

[ Bericht 3% gewijzigd door #ANONIEM op 16-10-2015 11:23:19 ]

http://www.afhayes.com/public/templates.pdf

[ Bericht 3% gewijzigd door #ANONIEM op 16-10-2015 11:23:19 ]

Dat kan? Nee niet binary. Team tenure is het.quote:Op vrijdag 16 oktober 2015 11:02 schreef MCH het volgende:

[..]

Dus eigenlijk heb je moderated mediation? Is je moderator binary?

[ Bericht 2% gewijzigd door W00fer op 16-10-2015 12:38:15 ]

Friettent dikke Willie, met Willie

Model 5, alleen dan zonder direct effect tussen X en Y. Via Mi en dan W heef een invloed op de relatie tussen X en Mi. Zo dus:quote:Op vrijdag 16 oktober 2015 11:22 schreef MCH het volgende:

En misschien is het handig om te vertellen welke van de 76 modellen je wil gaan testen:

http://www.afhayes.com/public/templates.pdf

Friettent dikke Willie, met Willie