Hier verder met Deel 5.

Links:

http://www.spsslog.com/

http://www.spss.com/nl/

Aha! Ik snap hetquote:Op maandag 9 juli 2012 23:44 schreef oompaloompa het volgende:

Probleem ontdekt en omdat andere mensen hier misschien ook tegenaan kunnen lopen post ik het hier maar.

Als je een multivariate / manova doet, vallen in principe cases met 1 of meer missing values gewoon af. Omdat je dataset zo veel missings heeft, houdt je uiteindelijk minder dan de helft over. Wat nog cru-er is, is dat van 1 conditie je helemaal niemand meer overhoudt. Daarom kun je geen contrasten meer doen.

Nu zijn er 2 opties:

1 je imputeert de missings.

2 je doet allemaal losse univariates

En die losse univariates had ik al gedaan. Nog één vraagje erover. Maakt dat dan veel uit dat ik nu univariates doe? En moet / kan ik dat dan gewoon verantwoorden in mijn discussie of hoeft dat allemaal niet?

Met allemaal losse toetsen vergroot je de kans op een type 1 fout. En ik zou het inderdaad wel vermelden.quote:Op maandag 9 juli 2012 23:47 schreef automatic_ het volgende:

[..]

Aha! Ik snap het

En die losse univariates had ik al gedaan. Nog één vraagje erover. Maakt dat dan veel uit dat ik nu univariates doe? En moet / kan ik dat dan gewoon verantwoorden in mijn discussie of hoeft dat allemaal niet?

Oh God, dat hebben we ook nog jaquote:Op maandag 9 juli 2012 23:51 schreef Sandertje23 het volgende:

[..]

Met allemaal losse toetsen vergroot je de kans op een type 1 fout. En ik zou het inderdaad wel vermelden.

Ah ok, fijn dat je je tabel toegevoegd hebt.quote:Op maandag 9 juli 2012 23:44 schreef VacaLoca het volgende:

[..]

Thanks, stukje 'meand +/- 1.96*sd omvat 0' is helaas nog even onbekende taal voor mij. Ik heb met studie geen statistiek gehad, en probeer nu zelf snel te leren zo goed en zo kwaad als het kan. Heb even uitdraai gemaakt.

[ afbeelding ]

Nu had ik daarover al wel gelezen in SPSS Survival Guide:

While there are tests that you can use to evaluate skewness and kurtosis values, these are too sensitive with large samples. Tabachnick and Fidell (2007, p. 81) recommend inspecting the shape of the distribution (e.g. using a histogram).

Nu zien zij 200+ als een large sample las ik elders in het boek... terwijl ik n=126 heb

Verderop in het boek adviseren ze iig een Normal Q-Q plot als alternatief.

[..]

Maar wanneer zouden mensen ervaren met statistiek het nog 'reasonable' noemen is dan mijn vraag betreffende bv de Q-Q plot die ik liet zien.

Iemand anders een goede website voor basis tot gemiddeld niveau analyses voor surveys? Werken met likert schalen, multiple choise etc. Ik heb alle data-invoer goed zover ik weet, maar niet overzichtelijk wélke analyses het meest relevant zijn voor een dergelijke enquete. Heb helaas zeer beperkt de tijd me goed in te lezen.

Met skewness en kurtosis kun je een beetje fdoen zoals je ook normale andere toetsen doet.

Als ik kijk naar je skewness (even verzonnen, pas zo de nummers aan) dan zie je dat het gemiddelde .500 is (of zo). Dat betekent dat je gemiddelde .5 afligt van de 0 waar het zou moeten zijn als je geen skewness hebt ("scheve normaalverdeling"). Is dat significant anders? Darvoor gebruik je de standaardverdeling van de skewness (laten we zeggen dat die .2 is even) en die doe je keer 1.96. Nu heb je de 95% confidence interval van je 0.5 mean. Als je die erbij optelt & aftrekt heb je dus een confidence interval van 0.1 -- 0.9. Het gemiddelde waar je op hoopt, 0.0, ligt daar niet tussen. Dit betekent dat je significante skewness hebt en je data dus niet normaal verdeeld is.

Hiervoor zijn een aantal oplossingen.

1. negeren en gewoon doorgaan. Je resultaten zijn minder betrouwbaar, maar als je resultaten heel erg sterk zijn maakt dat niet heel erg veel uit.

2. Je data hercoderen waardoor ze normaal verdeeld raken. Bijvoorbeeld door een log0transformatie of er de wortel van te nemen.

3. Een nonparametrische toets er op toepassen. Deze zijn wat conservatiever maar hebben, bij data die in de buurt van een normaalverdeling liggen minder power.

Als handige guide kan ik Pallant aanraden.

Ja gewoon in je discussie zeggen; vanwege missing values niet mogelijk multivariate te doen dus daarom 4 univariates. Zolang je eerlijk rapporteert is er geen probleem. Als je hypothese per los construct had is er ook geen type-1 probleem, als je alleen overall effect voorspeld had en op ene wel vindt en op andere niet, heb je wel een probleem qua zowel type 1 als type 2 :pquote:Op maandag 9 juli 2012 23:47 schreef automatic_ het volgende:

[..]

Aha! Ik snap het

En die losse univariates had ik al gedaan. Nog één vraagje erover. Maakt dat dan veel uit dat ik nu univariates doe? En moet / kan ik dat dan gewoon verantwoorden in mijn discussie of hoeft dat allemaal niet?

Thank you very muchquote:Op maandag 9 juli 2012 23:53 schreef oompaloompa het volgende:

[..]

Ah ok, fijn dat je je tabel toegevoegd hebt.

Met skewness en kurtosis kun je een beetje fdoen zoals je ook normale andere toetsen doet.

Als ik kijk naar je skewness (even verzonnen, pas zo de nummers aan) dan zie je dat het gemiddelde .500 is (of zo). Dat betekent dat je gemiddelde .5 afligt van de 0 waar het zou moeten zijn als je geen skewness hebt ("scheve normaalverdeling"). Is dat significant anders? Darvoor gebruik je de standaardverdeling van de skewness (laten we zeggen dat die .2 is even) en die doe je keer 1.96. Nu heb je de 95% confidence interval van je 0.5 mean. Als je die erbij optelt & aftrekt heb je dus een confidence interval van 0.1 -- 0.9. Het gemiddelde waar je op hoopt, 0.0, ligt daar niet tussen. Dit betekent dat je significante skewness hebt en je data dus niet normaal verdeeld is.

Hiervoor zijn een aantal oplossingen.

1. negeren en gewoon doorgaan. Je resultaten zijn minder betrouwbaar, maar als je resultaten heel erg sterk zijn maakt dat niet heel erg veel uit.

2. Je data hercoderen waardoor ze normaal verdeeld raken. Bijvoorbeeld door een log0transformatie of er de wortel van te nemen.

3. Een nonparametrische toets er op toepassen. Deze zijn wat conservatiever maar hebben, bij data die in de buurt van een normaalverdeling liggen minder power.

Als handige guide kan ik Pallant aanraden.

[..]

Ja gewoon in je discussie zeggen; vanwege missing values niet mogelijk multivariate te doen dus daarom 4 univariates. Zolang je eerlijk rapporteert is er geen probleem. Als je hypothese per los construct had is er ook geen type-1 probleem, als je alleen overall effect voorspeld had en op ene wel vindt en op andere niet, heb je wel een probleem qua zowel type 1 als type 2 :p

Nog één vraag voor ik weer zelf de boeken in zal duiken: wat doen jullie met enquetes met antwoorden ahv een likert schaal. Behandelen jullie het als numerieke data (1 t/m 5) met Scale dus als measurement type, en daar de passende analyses op loslaten. Of als categorische data met Ordinal als measurement type?

(bonusvraag: als je 5-schalige likert hebt maar tevens een 'geen mening/niet van toepassing' optie, kan je het dan nog wel als ordinal behandelen? Want de optie geen mening/nvt ligt dan niet in lijn met de likert data.

Yeap, als je helemaal een goede indruk wilt maken, interpreteer je nog even op welke wijze dat minder nauwkeurig is. Kan ik je wel mee helpen. In principe komt het er op neer dat je de spreiding aan de ene kant overschat en aan de andere kant onderschat. Afhankelijk van de vergelijking is je toets dus óf te strikt (= goed voor je, zelfs met een te strenge test nog verschil) of een tikkie te zwak (dan moet je uitleggen dat je significantiewaarde waarschijnlijk iets hoger is dan wat spss rapporteert)quote:Op dinsdag 10 juli 2012 00:04 schreef VacaLoca het volgende:

[..]

Thank you very muchHet is voor HBO, dus ze zijn wat makkelijker impressed denk ik; dus met dat in achterhoofd zou ik denk ik goed voor optie 1 kunnen gaan en kort uitleggen dat de betrouwbaarheid iets lager ligt omdat de normality niet helemaal voldoet aan de eisen, toch?

Nog één vraag voor ik weer zelf de boeken in zal duiken: wat doen jullie met enquetes met antwoorden ahv een likert schaal. Behandelen jullie het als numerieke data (1 t/m 5) met Scale dus als measurement type, en daar de passende analyses op loslaten. Of als categorische data met Ordinal als measurement type?

(bonusvraag: als je 5-schalige likert hebt maar tevens een 'geen mening/niet van toepassing' optie, kan je het dan nog wel als ordinal behandelen? Want de optie geen mening/nvt ligt dan niet in lijn met de likert data.

Likertschaal is officieel ordinaal maar kun je als scale benaderen (zijn wat simulatiepapers over)

bonusvraag: nee

Moet ik die vragen met likertschaal en de geen mening/nvt recoden zodat alleen likert overblijft? De geen mening/nvt bijvoorbeeld een 'Missing' value geven?

Dit even aannemende dat als men likertschaal vragen in zn enquete heeft, je de beste analyses kan doen met Ordinal en niet met Nominal.

bron kan b.v.http://xa.yimg.com/kq/gro(...)9%25E2%2580%2599.pdf zijn. (dubbelcheck het even, heb alleen net ter plekke abstract bekeken)

Graciasquote:Op dinsdag 10 juli 2012 00:29 schreef oompaloompa het volgende:

Ik zou het gewoon als scale doen, doet iedereen. dan voor bonuspunten nog even slim doen en zeggen "is officieel ordinaal, maar (bron) heeft aangetoond dat ook dan scale toegepast kan worden.

bron kan b.v.http://xa.yimg.com/kq/gro(...)9%25E2%2580%2599.pdf zijn. (dubbelcheck het even, heb alleen net ter plekke abstract bekeken)

(de geen mening/nvt nog wel even recoden naar Missing dus? of is daar betere oplossing voor?)

Succes!

Je mag alles doen wat je wilt met getransformeerde variabelen zolang je maar vervolgens bij de interpratie rekening houdt met je transformatie.quote:Op dinsdag 10 juli 2012 01:16 schreef Brembo het volgende:

Even een vraag over transformaties, ik heb een logtransformatie gedaan voor de afhankelijke variabele. Voor toetsen mag dit allemaal zonder problemen, tegen niet getransformeerde variabelen? Maar geldt dit ook voor een ANOVA?

Als je een single paired comparison ANOVA moet doen, dan kan dat toch gewoon via general linear model --> univariate en dan optie 'single' bij contrasts? Ik heb data uit 3 surveys die ik moet vergelijken, vandaar. Ik heb alle data in 1 groot bestand, met een nieuwe variabele die bij elke respondent aangeeft uit welke survey hij komt.

Volgens mijn begeleider moet ik met allemaal formules en hercoderingen gaan zitten werken

huh? Er van uitgaande dat jij je begeleider goed hebt begrepen heb jij gelijkquote:Op dinsdag 10 juli 2012 14:01 schreef Omnifacer het volgende:

Pfff

Als je een single paired comparison ANOVA moet doen, dan kan dat toch gewoon via general linear model --> univariate en dan optie 'single' bij contrasts? Ik heb data uit 3 surveys die ik moet vergelijken, vandaar. Ik heb alle data in 1 groot bestand, met een nieuwe variabele die bij elke respondent aangeeft uit welke survey hij komt.

Volgens mijn begeleider moet ik met allemaal formules en hercoderingen gaan zitten werken

Then again, in principe kun je verschillende surveys niet zo maar met elkaar vergelijken..

Gister zei de begeleider echter: je kunt die drie groepen niet zomaar met elkaar vergelijken vanwege verschil in grootte, je moet een paired comparison ANOVA doen. Nu heb ik me scheel zitten lezen in zo'n kutboek en allemaal zitten kutten met SPSS, maar ik kom niet verder. Dat boek komt met allemaal formules aanzetten (geen idee waar je die zou moeten invoeren), en volgens de tutorials op YouTube kun je gewoon dus doen wat ik omschreef: contrasts --> single selecteren.

Jij ziet er uit als iemand die er meer van weet dan ik: hoe zie jij dat?

Heh? Dat klopt gewoon echt niet.quote:Op dinsdag 10 juli 2012 14:20 schreef Omnifacer het volgende:

Thanks voor je antwoord. Dit is de situatie: ik heb drie surveys afgenomen, en wil deze vergelijken op een bepaalde variabele, bijvoorbeeld 'competence'. Wat ik had gedaan: een variabele gemaakt waarin elke respondent getagd wordt uit welke survey hij afkomstig is. Daarmee had ik ANOVA's gemaakt, door gewoon univariate ANOVA te doen. Daar kwam dan een significantie van .182 uit.

Gister zei de begeleider echter: je kunt die drie groepen niet zomaar met elkaar vergelijken vanwege verschil in grootte, je moet een paired comparison ANOVA doen. Nu heb ik me scheel zitten lezen in zo'n kutboek en allemaal zitten kutten met SPSS, maar ik kom niet verder. Dat boek komt met allemaal formules aanzetten (geen idee waar je die zou moeten invoeren), en volgens de tutorials op YouTube kun je gewoon dus doen wat ik omschreef: contrasts --> single selecteren.

Jij ziet er uit als iemand die er meer van weet dan ik: hoe zie jij dat?Als ik het op die laatste manier doe, wordt er dan rekening gehouden met verschil in aantal respondenten?

Als eerste doe je een anova, als daar geen verschil uit blijkt houdt het eigenlijk op.

Je kunt ook nog contrasten tussen de losse groepen doen. je kunt of post-hocs doen (hoef je niks aan te passen) of planned contrasts. Voor planned contrasts is groepsgrootte alleen relevant (volgens mij & collega naast me) als je meerdere groepen samen vergelijkt met andere groepen samen.

Ter illustratie, stel ik heb de volgende groepen

1: n=25

2: n = 50

3: n = 100

4: n = 250

Je kunt gewoon 2 and 3 met elkaar vergelijken.

Wat wel een probleem wordt is als je 1&2 met 3&4 samen zou willen vergelijken, dan moet je binnen die paren rekening houden met groepsgrootte.

wat voor iemand moetik je voorstellen bij je begeleider, wetenschappelijk onderzoeker of eerder mbo-methodologiedocent en zelfgetrained enqueteur?

Ik ben vrij zeker van mijn antwoord, maar het is een beetje afhankelijk van het relatief verschil in expertise op wie je beter af kunt gaan ^^

In mijn geval heb ik hypothesen die over verschil tussen survey1 en survey 2+3 gaan, en hypothesen die tussen verschil tussen survey 1, 2 en 3 gaan.

Survey 1: n=36

Survey 2: n=40

Survey 3: n=28.

Volgens mijn begeleider kan ik deze dus niet zomaar met elkaar vergelijken omdat n teveel verschilt.

Ik had bij alle hypothesen een ANOVA gedaan en nergens kwam trouwens verschil uit.

Ik snap er zelf dus helemaal geen kut van. Godver wat een gezeik

Je begeleider heeft gelijk m.b.t. je eerste toetsquote:Op dinsdag 10 juli 2012 14:41 schreef Omnifacer het volgende:

Begeleider is een AIO.

In mijn geval heb ik hypothesen die over verschil tussen survey1 en survey 2+3 gaan, en hypothesen die tussen verschil tussen survey 1, 2 en 3 gaan.

Survey 1: n=36

Survey 2: n=40

Survey 3: n=28.

Volgens mijn begeleider kan ik deze dus niet zomaar met elkaar vergelijken omdat n teveel verschilt.

Ik had bij alle hypothesen een ANOVA gedaan en nergens kwam trouwens verschil uit.

Ik snap er zelf dus helemaal geen kut van. Godver wat een gezeik

daarvoor moet je groep 1 op -1 zetten

groep 2 op 40/68 en groep 3 op 28/68

Omdat groep 2 en 3 een andere grootte hebben moet je ze anders wegen. Overigens is het een beetje zinloos planned contrasts te doen als je geen plan had en de anova sowieso al niet sig is, maar dat terzijde.

Tsjah, het slaat ook nergens op. Al die tijd die in die zinloze analyses gaat zitten, terwijl in beginsel al niks significant isquote:Op dinsdag 10 juli 2012 14:47 schreef oompaloompa het volgende:

[..]

Je begeleider heeft gelijk m.b.t. je eerste toets

daarvoor moet je groep 1 op -1 zetten

groep 2 op 40/68 en groep 3 op 28/68

Omdat groep 2 en 3 een andere grootte hebben moet je ze anders wegen. Overigens is het een beetje zinloos planned contrasts te doen als je geen plan had en de anova sowieso al niet sig is, maar dat terzijde.

Ik heb je even PM gestuurd over hoe dat 'op -1 zetten' etc werkt. Hoop dat je er even naar wil kijken. Thanks alvast

De hypothese is dat het verschil tussen survey 1 en 2/3 voor var1 groter is dan voor var2.

Hoe moet ik dit nu doen? Als ik snel een repeated measure ANOVA doe dan komen er allemaal dingen uit waarvan ik niet echt snap wat ze betekenen. Ik kan ook geen onderscheid zien tussen survey 1 en 2/3. Is er iemand die me kan helpen?

Was je hier al uitgekomen of heb je nog steeds hulp nodig?quote:Op dinsdag 10 juli 2012 18:16 schreef Omnifacer het volgende:

Mensen, ben ik weer. Ik ben er bijna helemaal uit, ik moet alleen nog een repeated measure ANOVA doen voor twee variabelen. Laat ik ze even var1 en var2 noemen. Ik wil de score van de respondenten uit survey 1 op deze variabelen vergelijken met de score van de respondenten op survey2+3 samen. Var1 en var2 zijn within-subject variabelen, en survey1 en survey2+3 zijn natuurlijk between-variabelen, dus moet ik van mijn begeleider een repeated measure doen. Zoals ik hier al zei: ik heb een grote dataset met alle respondenten erin, en zelf een soort variabele aangemaakt die aangeeft uit welke survey mensen afkomstig zijn.

De hypothese is dat het verschil tussen survey 1 en 2/3 voor var1 groter is dan voor var2.

Hoe moet ik dit nu doen? Als ik snel een repeated measure ANOVA doe dan komen er allemaal dingen uit waarvan ik niet echt snap wat ze betekenen. Ik kan ook geen onderscheid zien tussen survey 1 en 2/3. Is er iemand die me kan helpen?

Zo ja, kun je even een screenshot maken van wat je in het eerste en wteede scherm van repeated in hebt gevuld?

Bedankt!

Hoe moet ik dit precies interpreteren en is het gewoon invoegen van year-dummies de beste manier om te controleren op jaarinvloeden op data?

Nice, hoop dat het allemaal goedgekeurd wordtquote:Op woensdag 11 juli 2012 22:47 schreef Omnifacer het volgende:

Ik denk dat ik eruit ben, ik zal morgen even laten weten wat de begeleider ervan zei... Misschien moet ik het wel opnieuw doen (weet niet zeker of ik het goed heb gedaan), als dat zo is dan geef ik weer even een sein.

Bedankt!

Interpretatie; verschillen op dv worden verklaard door jaar-verschillen.quote:Op donderdag 12 juli 2012 09:45 schreef VreemdeEend het volgende:

Ik heb ook even een vraag over een onderzoek van mij. Ik heb van mijn afhankelijke variabele data verzameld over 10 jaar verspreid. Vervolgens een een regressieanalyse met 7 onafhankelijke variabelen. Uitkomsten hiervan waren prachtig ook al omdat ik wist dat die zaken een sterk effect zouden hebben op mijn afhankelijke variabele. Nu wilt mijn begeleider alleen dat ik ook jaar-dummies gebruik. Als ik dit echter doe is het effect van een jaar enorm op mijn afhankelijke variabele en de effecten van al mijn eerste onafhankelijke variabelen zijn nu nihil.

Hoe moet ik dit precies interpreteren en is het gewoon invoegen van year-dummies de beste manier om te controleren op jaarinvloeden op data?

Dummies is waarschijnlijk niet het beste, het geeft je erg veel degrees of freedom. Is er een reden warom je jaar niet als continue kunt zien? En heb je niet per proefpersoon een meting per jaar?

Overigens is 17 IV's echt enorm veel, hoe groot is je dataset?

Ik probeer het aantal fusie's en overnames in Europa over 11 jaar gezien (per maand bekeken) te verklaren door 7 economische indicatoren. Ik heb dus voor 132 maanden het aantal fusies en overnames en daarbij dan die waarden van de indicatoren voor de betreffende periode. Ik begrijp dat 17 IV's echt heel veel is, maar mijn begeleider blijft maar doorzeuren over het controleren op jaarinvloeden. Is er dan nog een andere manier waarop ik iets kan doen met de invloed van het jaar zelf zonder dummies te gebruiken?quote:Op donderdag 12 juli 2012 09:53 schreef oompaloompa het volgende:

[..]

Interpretatie; verschillen op dv worden verklaard door jaar-verschillen.

Dummies is waarschijnlijk niet het beste, het geeft je erg veel degrees of freedom. Is er een reden warom je jaar niet als continue kunt zien? En heb je niet per proefpersoon een meting per jaar?

Overigens is 17 IV's echt enorm veel, hoe groot is je dataset?

Dit is echt totaal niet wat ik normaal doe, dus ik kan het moeilijk beantwoorden. Aangenomen dat jaar geen linear verband heeft kun je het niet als losse variabele meenemen, maar dummies lijkt me ook echt een waardeloze oplossing, moet ik even over nadenken. (ik doe voornamelijk experimenteel onderzoek dus ben minder thuis in correlationeel onderzoek en modelleren, alhoewel ik wel wat relevante statistiek vakken er over heb gehad, maar dat is ondertussen een beetje weggezaktquote:Op donderdag 12 juli 2012 10:13 schreef VreemdeEend het volgende:

[..]

Ik probeer het aantal fusie's en overnames in Europa over 11 jaar gezien (per maand bekeken) te verklaren door 7 economische indicatoren. Ik heb dus voor 132 maanden het aantal fusies en overnames en daarbij dan die waarden van de indicatoren voor de betreffende periode. Ik begrijp dat 17 IV's echt heel veel is, maar mijn begeleider blijft maar doorzeuren over het controleren op jaarinvloeden. Is er dan nog een andere manier waarop ik iets kan doen met de invloed van het jaar zelf zonder dummies te gebruiken?

Dan een andere vraag, het lijkt me logisch dat jaar samenhant met veel van die economische indicatoren, ik weet niet welke indicatoren je gebruikt maar als er een effect van jaar is, zou ik juist verwachten dat dat via die economische factoren gaat (2001 was een slecht jaar economische gezien, daardoor waren er meer overnames). Als dat zo is, en je controleert voor jaar, controleer je onbedoeld ook juist voor de dingen waarin je geinteresseerd bent, lijkt me ook niet de bedoeling..

En ik heb dichotomous gedaan, dus 1tjes en nulletjes. Maar heb ook cases erbij die de hele vraag niet beantwoord hebben, daar heb ik nu allemaal 0 staan. Maakt dat nog wat uit voor de analyses? Moet ik die vervangen met bv 99 - missing value? Of kijkt SPSS sowieso alleen naar de 1tjes en maakt het niet uit?

Nog een vraag over MPR:

Als je bijvoorbeeld de vraag hebt 'In welk(e) land(en) bent u op vakantie geweest in 2011?' en men kan meerdere antwoorden aanvinken.

En frequentietabel van de MPR geeft bijvoorbeeld aan dat 60% van de cases in Spanje is geweest en 40% van de cases in Italië....

.. is het dan vervolgens ook mogelijk om te kijken hoeveel cases er zowel in Spanje als Italië zijn geweest in 2011?

En zoja kan je die dan vervolgens in een variabele stoppen zodat je analyses kan doen over het segment dat in beide landen is geweest?

BVD!

Select cases klikken en dan select cases if... Daar kun je aangeven dat alleen cases meedoen die in een bepaald land zijn geweest. Ook kun je met het AND commando alleen de cases selecteren die in beide landen zijn geweest. Bijvoorbeeld: if Spanje = 1 AND Italië = 1. Ik ga er even vanuit dat zo je variabelen heten en dat 1 staat voor "er op vakantie geweest". Dan selecteer je dus alleen cases die in beide landen zijn geweest.quote:Op zaterdag 14 juli 2012 21:05 schreef VacaLoca het volgende:

Lijkt niet uit te maken, wat betreft die missing values...

Nog een vraag over MPR:

Als je bijvoorbeeld de vraag hebt 'In welk(e) land(en) bent u op vakantie geweest in 2011?' en men kan meerdere antwoorden aanvinken.

En frequentietabel van de MPR geeft bijvoorbeeld aan dat 60% van de cases in Spanje is geweest en 40% van de cases in Italië....

.. is het dan vervolgens ook mogelijk om te kijken hoeveel cases er zowel in Spanje als Italië zijn geweest in 2011?

En zoja kan je die dan vervolgens in een variabele stoppen zodat je analyses kan doen over het segment dat in beide landen is geweest?

BVD!

Succes!

De onafhankelijke variabelen in het model heb ik ingedeeld in vier groepen (fysieke, sociale, locatie en prijs variabelen). Om uiteindelijk statistisch het sterkste model te vinden gebruik ik de zgn. 'enter methode' voor het toevoegen van de variabelen (groepen) aan het model. Het komt er op neer dat ik uiteindelijk vier regressie modellen heb. Het eerste model heeft slechts 1 groep onafhankelijke variabelen in het model, terwijl het vierde model alle vier de groepen in het model meeneemt.

Dit vierde model is dan ook het sterkste. Althans dat heeft de hoogste verklarende waarde (R-square).

Dit is ook uit te lezen in de 'model summary' die hier beneden is afgebeeld. Wat ik graag wil weten is wat de individuele verklarende waarde is per groep in het laatste model. Dus wat is de statistisch verklarende waarde van groep 1, 2, 3 en 4 in model 4. Dus welk percentage van 73,8% (R-square) verklaart elke groep individueel. De model summary geeft deze statistiek alleen cumulatief. Is er in SPSS een manier om dit te vinden? Zo ja, hoe?

Als het goed is heb je in de output nog een tabel staan met de regressiecoefficienten (betas en B waarden) per predictor.quote:Op donderdag 19 juli 2012 09:21 schreef bart1074 het volgende:

Ook ik heb wat SPSS hulp nodig. Voor mijn scriptie onderzoek voer ik regressies uit in SPSS.

De onafhankelijke variabelen in het model heb ik ingedeeld in vier groepen (fysieke, sociale, locatie en prijs variabelen). Om uiteindelijk statistisch het sterkste model te vinden gebruik ik de zgn. 'enter methode' voor het toevoegen van de variabelen (groepen) aan het model. Het komt er op neer dat ik uiteindelijk vier regressie modellen heb. Het eerste model heeft slechts 1 groep onafhankelijke variabelen in het model, terwijl het vierde model alle vier de groepen in het model meeneemt.

Dit vierde model is dan ook het sterkste. Althans dat heeft de hoogste verklarende waarde (R-square).

Dit is ook uit te lezen in de 'model summary' die hier beneden is afgebeeld. Wat ik graag wil weten is wat de individuele verklarende waarde is per groep in het laatste model. Dus wat is de statistisch verklarende waarde van groep 1, 2, 3 en 4 in model 4. Dus welk percentage van 73,8% (R-square) verklaart elke groep individueel. De model summary geeft deze statistiek alleen cumulatief. Is er in SPSS een manier om dit te vinden? Zo ja, hoe?

[ afbeelding ]

Ja dat klopt en zelfs nog een hele hoop andere output. Maar het is mij niet duidelijk hoe ik die kan gebruiken om hetgeen te vinden waarnaar ik op zoek ben. De verklarende waarde per groep variabelen dus. Kan jij me dat uitleggen?quote:Op donderdag 19 juli 2012 09:25 schreef oompaloompa het volgende:

[..]

Als het goed is heb je in de output nog een tabel staan met de regressiecoefficienten (betas en B waarden) per predictor.

Dank

Kun je even de tabel copy pasten van model 4 met de regressiecoefficienten?quote:Op donderdag 19 juli 2012 09:36 schreef bart1074 het volgende:

[..]

Ja dat klopt en zelfs nog een hele hoop andere output. Maar het is mij niet duidelijk hoe ik die kan gebruiken om hetgeen te vinden waarnaar ik op zoek ben. De verklarende waarde per groep variabelen dus. Kan jij me dat uitleggen?

Dank

Het percentage dat zo'n extra variabele verklaart is het verschil tussen de R2 met en zonder die variabele(volgens mij, of anders dat getal met een verwaarloosbaar verschil).quote:Op donderdag 19 juli 2012 09:21 schreef bart1074 het volgende:

Ook ik heb wat SPSS hulp nodig. Voor mijn scriptie onderzoek voer ik regressies uit in SPSS.

De onafhankelijke variabelen in het model heb ik ingedeeld in vier groepen (fysieke, sociale, locatie en prijs variabelen). Om uiteindelijk statistisch het sterkste model te vinden gebruik ik de zgn. 'enter methode' voor het toevoegen van de variabelen (groepen) aan het model. Het komt er op neer dat ik uiteindelijk vier regressie modellen heb. Het eerste model heeft slechts 1 groep onafhankelijke variabelen in het model, terwijl het vierde model alle vier de groepen in het model meeneemt.

Dit vierde model is dan ook het sterkste. Althans dat heeft de hoogste verklarende waarde (R-square).

Dit is ook uit te lezen in de 'model summary' die hier beneden is afgebeeld. Wat ik graag wil weten is wat de individuele verklarende waarde is per groep in het laatste model. Dus wat is de statistisch verklarende waarde van groep 1, 2, 3 en 4 in model 4. Dus welk percentage van 73,8% (R-square) verklaart elke groep individueel. De model summary geeft deze statistiek alleen cumulatief. Is er in SPSS een manier om dit te vinden? Zo ja, hoe?

[ afbeelding ]

Het staat trouwens gewoon theoretisch vast dat je met een extra variabele nooit slechter kan verklaren, dus dat zou geen verrassing moeten zijn dat een model met meer variabelen een hogere R2 heeft.

Nee dat i niet helemaal waar. Stel dat je twee variabelen hebt, A en B. A en B correleren met elkaar met .5quote:Op donderdag 19 juli 2012 09:49 schreef Fingon het volgende:

[..]

Het percentage dat zo'n extra variabele verklaart is het verschil tussen de R2 met en zonder die variabele(volgens mij, of anders dat getal met een verwaarloosbaar verschil).

Het staat trouwens gewoon theoretisch vast dat je met een extra variabele nooit slechter kan verklaren, dus dat zou geen verrassing moeten zijn dat een model met meer variabelen een hogere R2 heeft.

Als je alleen A in het model toevoegt zal de verklaarde variantie van A overschat worden omdat dat gedeelte dat door B verklaard wordt maar niet in het model meegenomen is, voor die .5 door A vrklaard zal worden.

Dat is dus niet waar, want het is sterk afhankelijk van de volgorde waarin de groepen van variabelen worden toegevoegd. Via die 'enter methode' heb ik dus de beste volgorde gevonden en daarmee het definitieve model. Nu wil ik weten wat de verklarende waarde per groep is in dit definitieve model. Volgens mij is dit dus niet zo simpel als verschillen in R2...quote:Op donderdag 19 juli 2012 09:49 schreef Fingon het volgende:

[..]

Het percentage dat zo'n extra variabele verklaart is het verschil tussen de R2 met en zonder die variabele(volgens mij, of anders dat getal met een verwaarloosbaar verschil).

Het staat trouwens gewoon theoretisch vast dat je met een extra variabele nooit slechter kan verklaren, dus dat zou geen verrassing moeten zijn dat een model met meer variabelen een hogere R2 heeft.

Klopt, dus post die tabel eventjes dan kan ik het uitleggen ^^quote:Op donderdag 19 juli 2012 09:54 schreef bart1074 het volgende:

[..]

Dat is dus niet waar, want het is sterk afhankelijk van de volgorde waarin de groepen van variabelen worden toegevoegd. Via die 'enter methode' heb ik dus de beste volgorde gevonden en daarmee het definitieve model. Nu wil ik weten wat de verklarende waarde per groep is in dit definitieve model. Volgens mij is dit dus niet zo simpel als verschillen in R2...

Feit is wel dat je nooit een hogere R2 kan krijgen met minder (van dezelfde) variabelen.quote:Op donderdag 19 juli 2012 09:54 schreef oompaloompa het volgende:

[..]

Nee dat i niet helemaal waar. Stel dat je twee variabelen hebt, A en B. A en B correleren met elkaar met .5

Als je alleen A in het model toevoegt zal de verklaarde variantie van A overschat worden omdat dat gedeelte dat door B verklaard wordt maar niet in het model meegenomen is, voor die .5 door A vrklaard zal worden.

Alvast bedankt voor je hulp. Hier kan je een excel file downloaden met de volledige output.quote:Op donderdag 19 juli 2012 09:43 schreef oompaloompa het volgende:

[..]

Kun je even de tabel copy pasten van model 4 met de regressiecoefficienten?

Klopt. Daarom heb je helemaal op het einde van de tabel de sig. F change. Die kijkt of de toegenomen verklaarde variantie t.o.v. de toegenomen degrees of freedom wel significant is.quote:Op donderdag 19 juli 2012 09:56 schreef Fingon het volgende:

[..]

Feit is wel dat je nooit een hogere R2 kan krijgen met minder (van dezelfde) variabelen.

In de excell file staat alleen dezelfde tabel als die je hier gepost hebt.quote:Op donderdag 19 juli 2012 09:58 schreef bart1074 het volgende:

[..]

Alvast bedankt voor je hulp. Hier kan je een excel file downloaden met de volledige output.

Edit: ik kan niet lezen

Ik probeer het wel even zonder de tabel.

bij de regression coefficients heb je als het goed is een B (ongestandaardiseerd) en een beta.

De B betekent ongeveer dat elke toename van 1 in die variabele leidt tot een toename van B in je afhankelijke.

Voor de betas zijn alle onafhankelijken gestandaardiseerd, is de variantie van alke onafhankelijke op 1 gezet. Dat betekent dus dat de beta laat zien hoeveel een toename van 1 standaardeviatie uitmaakt voor de afhankelijke. Omdat die allemaal gestandaardiseerd zijn, kun je je onafhankelijken vergelijken op de betas. Heeft bv onafhankelijke a een beta van 2, en onafhankelijke b eentje van 1. Dan is het effect van onafhankelijke 1 twee keer zo groot (per toename van 1 std) als het effect van onafhankelijke b.

Hopelijk is dat een beetje begrijpelijk

Over dat fijne programma gesproken; ik heb in mijn enquete een vraag die met ja / nee beantwoord kan worden en vervolgens ook een veld met toelichting eraan gekoppeld (maar niet verplicht om in te vullen). Hoe verwerk ik dit in mijn variable view? Kom er niet echt aan uit..

Thanks!

Hm, alleen dit zijn Kaplan-meier plots en heb geen zin om alle data en vervolgens de grafieken etc ook weer aan te passen in excel..quote:Op vrijdag 27 juli 2012 14:59 schreef oompaloompa het volgende:

Ik maak mijn grafieken altijd in excell omdat je daar veel flexibeler in kunt zijn, geen oplossing voor je probleem maar misschien wle een goede b-optie.

Macro's in word ken ik niet?

1) een Westers land

2) een Opkomende Economie

3) maakt niet uit

Hiervoor heb ik aan de hand van theorie 6 variabelen ontwikkelt en een vragenlijst geconstrueerd, met meerdere items per variabele.

Dit is mijn conceptuele model:

Gezien mijn afhankelijke variabele een categorische(/nominale) is met 3 categorieën, moet ik volgens veel literatuur een Discriminantmieanalyse of een Logistische regressie uitvoeren. Met de uitkomst van deze toetsen krijg ik voornamelijk kansverwachtingen.

Het klinkt voor mij echter intuïtiever om een er een analyse op basis van T-testen op los te laten, zoals een ANOVA. Ik wil uiteindelijk immers de verschillen in gemiddelden weten, om te bepalen of studenten die kiezen voor een Westers land bijvoorbeeld meer aangetrokken worden door een hogere levenskwaliteit, en diegenen die voor opkomende economieën kiezen (bijvoorbeeld) voor de Cultuur.

>>Wat is jullie mening? Heb ik mijn conceptueel model gewoon verkeerd getekend?

Is je DV categorisch? Dus mensen hebben of westers, of opkomend of maakt niet uit, of is het een schaal?quote:Op zondag 29 juli 2012 23:28 schreef DutchCow het volgende:

Ik ben bezig met mijn bachelorscriptie, waarin ik onderzoek doe naar de verschillen tussen studenten die een internationale carriere nastreven in

1) een Westers land

2) een Opkomende Economie

3) maakt niet uit

Hiervoor heb ik aan de hand van theorie 6 variabelen ontwikkelt en een vragenlijst geconstrueerd, met meerdere items per variabele.

Dit is mijn conceptuele model:

[ link | afbeelding ]

Gezien mijn afhankelijke variabele een categorische(/nominale) is met 3 categorieën, moet ik volgens veel literatuur een Discriminantmieanalyse of een Logistische regressie uitvoeren. Met de uitkomst van deze toetsen krijg ik voornamelijk kansverwachtingen.

Het klinkt voor mij echter intuïtiever om een er een analyse op basis van T-testen op los te laten, zoals een ANOVA. Ik wil uiteindelijk immers de verschillen in gemiddelden weten, om te bepalen of studenten die kiezen voor een Westers land bijvoorbeeld meer aangetrokken worden door een hogere levenskwaliteit, en diegenen die voor opkomende economieën kiezen (bijvoorbeeld) voor de Cultuur.

>>Wat is jullie mening? Heb ik mijn conceptueel model gewoon verkeerd getekend?

(Als je met DV Dependent Variabele bedoelt): Ik heb dit inderdaad een beetje onduidelijk aangeven.quote:Op zondag 29 juli 2012 23:32 schreef oompaloompa het volgende:

[..]

Is je DV categorisch? Dus mensen hebben of westers, of opkomend of maakt niet uit, of is het een schaal?

Ik heb een vragenlijst uitgedeeld waarin de respondenten eerst 7 voorkeurslanden mochten aangeven. Daaruit heb ik de drie categorieën gemaakt:

Als er 6 of 7 Westerse landen werden gemarkeerd: Klasse = Westers

Als er 6 of 7 Opkomende landen werden gemarkeerd: Klasse = Opkomend

Als dit niet het geval was: Geen specifieke voorkeur.

Ik zou dit natuurlijk ook als een metrische schaal kunnen zien (Westers met de waarden 1,2,3,4,5,6 of 7)..

Ik heb de oplossing zelf gevonden, dus voor iedereen die hier ook problemen mee heeft:quote:Op vrijdag 27 juli 2012 14:47 schreef June. het volgende:

Iemand enig idee hoe je verschillende grafieken op dezelfde grootte kan maken? Dus als je ze dan in word plakt, ze dan precies op 1 lijn naast elkaar komen staan. Height en width hetzelfde maken werkt op 1 of andere manier niet..

In je graph editor kun je van een bestaande grafiek een template maken (ergens onder file) en deze kun je dan weer toepassen op je andere grafieken

Ik zou gewoon 0-7 doen en anovas / t-toetsen. Zodra je het hercategoriseert verlies je waardevolle informatie (6 is niet hetzelfde als 7 net zomin als 0 hetzelfde als 5 niet-westers) vraag is alleen of je westers v.s. opkomend als 1 categorie met twee uitersten kunt zien of dat je westers en opkomend als twee losse Dependents moet nemen.quote:Op zondag 29 juli 2012 23:46 schreef DutchCow het volgende:

[..]

(Als je met DV Dependent Variabele bedoelt): Ik heb dit inderdaad een beetje onduidelijk aangeven.

Ik heb een vragenlijst uitgedeeld waarin de respondenten eerst 7 voorkeurslanden mochten aangeven. Daaruit heb ik de drie categorieën gemaakt:

Als er 6 of 7 Westerse landen werden gemarkeerd: Klasse = Westers

Als er 6 of 7 Opkomende landen werden gemarkeerd: Klasse = Opkomend

Als dit niet het geval was: Geen specifieke voorkeur.

Ik zou dit natuurlijk ook als een metrische schaal kunnen zien (Westers met de waarden 1,2,3,4,5,6 of 7)..

Nice, goed om te weten als ik ooit tegen dit probleem aanloop!quote:Op zondag 29 juli 2012 23:58 schreef June. het volgende:

[..]

Ik heb de oplossing zelf gevonden, dus voor iedereen die hier ook problemen mee heeft:

In je graph editor kun je van een bestaande grafiek een template maken (ergens onder file) en deze kun je dan weer toepassen op je andere grafieken.

Ik zit er nog even overna te denken waarom ik destijds in mijn onderzoeksopzet voor de categorieën gekozen heb. Ik denk dat de 0-7 oplossing inderdaad duidelijker is. Ik zit alleen nog met een klein probleem: er zijn meer 'westerse' landen in de landenlijst dan 'opkomende landen'.. De kans dat men voor een westers land kiest is dus groter. Moet en kan ik hiervoor corrigeren?quote:Op maandag 30 juli 2012 00:04 schreef oompaloompa het volgende:

[..]

Ik zou gewoon 0-7 doen en anovas / t-toetsen. Zodra je het hercategoriseert verlies je waardevolle informatie (6 is niet hetzelfde als 7 net zomin als 0 hetzelfde als 5 niet-westers) vraag is alleen of je westers v.s. opkomend als 1 categorie met twee uitersten kunt zien of dat je westers en opkomend als twee losse Dependents moet nemen.

Zolang je mensen onderling vergelijkt niet, als je absolute claims wilt maken wel, maar dat gaat nogal moeilijk. Zou het alleen noemen in de discussie.quote:Op maandag 30 juli 2012 00:11 schreef DutchCow het volgende:

[..]

Ik zit er nog even overna te denken waarom ik destijds in mijn onderzoeksopzet voor de categorieën gekozen heb. Ik denk dat de 0-7 oplossing inderdaad duidelijker is. Ik zit alleen nog met een klein probleem: er zijn meer 'westerse' landen in de landenlijst dan 'opkomende landen'.. De kans dat men voor een westers land kiest is dus groter. Moet en kan ik hiervoor corrigeren?

Sorry dat ik weet terugkom met mijn vraag, maar ik kom er echt niet meer uit

Het komt erop neer dat ik onderzoek:

->Welke factoren van invloed zijn op de keuze tussen een westers of een opkomend land (deze deelvraag is reeds onderzocht in het literaire deel, daaruit heb ik zes variabelen gemaakt en gemeten)

Een volgende deelvraag is:

Wat de verschillen in motieven zijn om in een opkomend- of een westers land te willen werken. Hierbij verwacht ik dus dat op sommige variabelen de westerse groep hoger scoort dan de andere groep (de opkomende landen).

Simpel zou je zeggen: Gooi er in SPSS een ANOVA overheen, de 6 variabelen worden dan ingevuld als dependent, en de landklasse (westers, opkomend, geen voorkeur) als 'factor' waarop wordt gegroepeerd. Ik krijg dan ook netjes de significante verschillen in gemiddelden, hiep hiep hoera!

Maarrr.. Kijkend naar mijn conceptuele model (zie figuur in mijn post hierboven) mag ik toch helemaal geen ANOVA gebruiken? De onafhankelijke variabelen zijn in mijn SPSS invoer ingevoerd als de AFhankelijke? Ik keer als het ware mijn hele conceptuele model om, dat is toch vreemd?

[edit]: verder lees ik dat ANOVA gebruikelijk is in experimenten, terwijl mijn onderzoek natuurlijk de werkelijkheid tracht te omschrijven, zonder als onderzoeker deze te beïnvloeden[/edit]

Mijn data bestaat uit kinderen van 5 - 18 jaar met een ziekte. In de leeftijdsgroep van 8-12 jaar heb ik data van gezonde kinderen. Ik heb daarom deze kinderen in één bestand gezet met mijn zieke kinderen van 8-12 jaar en daarbij heb ik gekeken of er verschillen zijn. Dit ging gewoon prima.

Nu heb ik een artikel gevonden waar ook data in staat van gezonde kinderen, in dezelfde leeftijdsgroep en deze ga ik als (extra) referentie-groep gebruiken.

Ik heb deze gemiddelden nu in een SPSS bestand gezet en daarbij ook mijn eigen gemiddelden. Hier heb ik een t-test op los gelaten (totale groep van 5-18 jaar, gezond/ziek) en daar kwamen de nodige getallen uit. Prima.

Maar... Nu wil ik nog de gemiddelde toetsen van 5-7 jaar en 13-18 jaar met deze referentiegroep. Echter, ik snap niet goed hoe ik dat moet doen

Ik heb daarbij de data (dus alleen de gemiddelden van de vier variabelen van gezonde als zieke kinderen) van 5-7 in een bestand gezet.

Als ik het namelijk doe zoals ik het bij de hele groep heb gedaan (dus 5-18 gezond en 5-18 ziek), dan rekent hij verder niets uit.

Neem dit niet verkeerd op, maar het klinkt alsof je eigenlijk niet zo goed weet wat je aan het doen bent.quote:Op maandag 30 juli 2012 12:26 schreef DutchCow het volgende:

(echt bedankt voor je snelle reacties oompaloompa!)

Sorry dat ik weet terugkom met mijn vraag, maar ik kom er echt niet meer uit

Het komt erop neer dat ik onderzoek:

->Welke factoren van invloed zijn op de keuze tussen een westers of een opkomend land (deze deelvraag is reeds onderzocht in het literaire deel, daaruit heb ik zes variabelen gemaakt en gemeten)

Een volgende deelvraag is:

Wat de verschillen in motieven zijn om in een opkomend- of een westers land te willen werken. Hierbij verwacht ik dus dat op sommige variabelen de westerse groep hoger scoort dan de andere groep (de opkomende landen).

Simpel zou je zeggen: Gooi er in SPSS een ANOVA overheen, de 6 variabelen worden dan ingevuld als dependent, en de landklasse (westers, opkomend, geen voorkeur) als 'factor' waarop wordt gegroepeerd. Ik krijg dan ook netjes de significante verschillen in gemiddelden, hiep hiep hoera!

Maarrr.. Kijkend naar mijn conceptuele model (zie figuur in mijn post hierboven) mag ik toch helemaal geen ANOVA gebruiken? De onafhankelijke variabelen zijn in mijn SPSS invoer ingevoerd als de AFhankelijke? Ik keer als het ware mijn hele conceptuele model om, dat is toch vreemd?

[edit]: verder lees ik dat ANOVA gebruikelijk is in experimenten, terwijl mijn onderzoek natuurlijk de werkelijkheid tracht te omschrijven, zonder als onderzoeker deze te beïnvloeden[/edit]

Anovas en regressies zijn techinisch hetzelfde, statistiek is niets anders dan formules dus de analyse die je gebruikt zal niet opeens de werkelijkheid beinvloeden o.i.d.

Als je gemeten motieven continu zijn kun je waarschijnlijk het beste een regressie doen met het aantal landen als adhankelijke (test wel eerst even de assumpties, kijk of er daadwerkelijk een linear verband is etc.)

Als je motiven enkele categorien zijn is het gemakkelijker een anova te doen.

Ik snap totaal niet wat je bedoeltquote:Op maandag 30 juli 2012 12:50 schreef automatic_ het volgende:

Oke... Ik voel mijzelf nu echt onwijs stom

Mijn data bestaat uit kinderen van 5 - 18 jaar met een ziekte. In de leeftijdsgroep van 8-12 jaar heb ik data van gezonde kinderen. Ik heb daarom deze kinderen in één bestand gezet met mijn zieke kinderen van 8-12 jaar en daarbij heb ik gekeken of er verschillen zijn. Dit ging gewoon prima.

Nu heb ik een artikel gevonden waar ook data in staat van gezonde kinderen, in dezelfde leeftijdsgroep en deze ga ik als (extra) referentie-groep gebruiken.

Ik heb deze gemiddelden nu in een SPSS bestand gezet en daarbij ook mijn eigen gemiddelden. Hier heb ik een t-test op los gelaten (totale groep van 5-18 jaar, gezond/ziek) en daar kwamen de nodige getallen uit. Prima.

Maar... Nu wil ik nog de gemiddelde toetsen van 5-7 jaar en 13-18 jaar met deze referentiegroep. Echter, ik snap niet goed hoe ik dat moet doen

Ik heb daarbij de data (dus alleen de gemiddelden van de vier variabelen van gezonde als zieke kinderen) van 5-7 in een bestand gezet.

Als ik het namelijk doe zoals ik het bij de hele groep heb gedaan (dus 5-18 gezond en 5-18 ziek), dan rekent hij verder niets uit.

Je hebt alle data toch of alleen gemiddelde en sd?

Kun je even precies zeggen wat je probeert te doen en wat je van spss terug krijgt?

Nee, van de referentiegroep uit het artikel heb ik alleen de gemiddelde (en eventueel ook de SD, maar ik heb nu alleen de gemiddelde in een bestand gezet).

En ik probeerde een t-test te doen. Ik kom er zo even op terug!

Maar hoe doe je een t-test zonder sd?quote:Op maandag 30 juli 2012 13:18 schreef automatic_ het volgende:

Uitleg is niet mijn sterkte kant

Nee, van de referentiegroep uit het artikel heb ik alleen de gemiddelde (en eventueel ook de SD, maar ik heb nu alleen de gemiddelde in een bestand gezet).

En ik probeerde een t-test te doen. Ik kom er zo even op terug!

je kunt niet gewoon een 1-sample doen

Weet ik veelquote:Op maandag 30 juli 2012 13:40 schreef oompaloompa het volgende:

[..]

Maar hoe doe je een t-test zonder sd?

je kunt niet gewoon een 1-sample doen

Dat van die one-sample was ik al achter. Momentje. Ik ga het even openen.

Tuurlijk, ben alleen wel zo weg van internet, dus alvast een tip. Om een t-test te doen heb je een gemiddelde en spreiding nodig. Als je geen raw data hebt, is het waarschijnlijk het gemakkelijkste gewoon een t-test met de hand (excell/rekenmachine) te doen.quote:Op maandag 30 juli 2012 13:48 schreef automatic_ het volgende:

Mag ik het anders even "duidelijk" (althans... dat probeer ik) in een mailtje zetten?

Een t-test met de hand?! Oh hemel... Heb ik dat ooit geleerd?

Als je methodenonderwijs een beetje goed is, heb je dat gehad jaquote:Op maandag 30 juli 2012 13:53 schreef automatic_ het volgende:

Mailtje is al onderweg, haha. Geen probleem als het niet lukt om er naar te kijken!

Een t-test met de hand?! Oh hemel... Heb ik dat ooit geleerd?

Ja, dat is vast goed geweest, maar ook jij kent mijn SPSS / Statistiek / MTO kunstenquote:Op maandag 30 juli 2012 15:12 schreef Sandertje23 het volgende:

[..]

Als je methodenonderwijs een beetje goed is, heb je dat gehad ja

Ik heb een soort van Counts tabel waarin staat hoe vaak een variabele is gekozen (f) hoe vaak die voorkwam (b) en percentueel (%) tov de andere variabelen. Zo dus:

Sample Size 229 229 100,00

Groep 1:.................................f .......... b.....%

1............................................103... 203....50,74

2 ............................................ 71 203 34,98

3............................................ 29 203 14,29

Groep 2:

1............................................63 170 37,06

2 ............................................48 170 28,24

3 ............................................ 59 170 34,71

Nou is me aangeraden om een chi² toets te doen om te kijken of er een significant verschil in aantal keer gekozen zit. Ik dacht dit gedaan te hebben in Excel, door te verwachten dat ze allemaal gelijk werden gekozen (per groep) en dan een chi square per groep. Maar, steeds als ik het in SPSS doe, en nu ik het in een excel macro doe, heb je 2 datasets nodig om de chi² te doen.

Hoe moet ik hem dan doen? Oftewel: welke variabelen moet ik invoeren? HELP!

Of ben ik al klaar als ik de variabelen in kolommen zet ipv rijen?

Edit: layout probleempje..

(1) geeft aan of het om groep 1 of 2 gaat

(2) geeft aan of het 1, 2 of 3 betreft

(3) de aantallen, die je vervolgens weegt via data - weigh variables of zo. Ergens onderaan de lijst.

Bij crosstabs geeft je dan de variabele van groep 1 en groep twee als layer op.

Maar, ik heb dat onduidelijk weergegeven, de variabelen in groep 1 en 2 zijn andere variabelen. Het gaat om een conjunct analyse waarbij Groep 1 een type kamer is, waarvan 1 = eenpersoonskamer, 2 = tweepersoonskamer en 3 is 4 of meer persoonskamer. En Groep twee is Uitzicht met 1 landschap, 2 stad, 3 park. Mensen die een eenpersoonskamer kiezne kunnen dus ook kiezen voor een landschap maar daar heb ik geen informatie over. Dan mag ik ze toch niet op die manier vergelijken?quote:Op dinsdag 7 augustus 2012 10:13 schreef crossover het volgende:

Volgens mij moet je drie variabelen maken.

(1) geeft aan of het om groep 1 of 2 gaat

(2) geeft aan of het 1, 2 of 3 betreft

(3) de aantallen, die je vervolgens weegt via data - weigh variables of zo. Ergens onderaan de lijst.

Bij crosstabs geeft je dan de variabele van groep 1 en groep twee als layer op.

Ik wil juist weten binnen een zo'n groep of daar inderdaad grote verschillen zitten in de frequentie van keuze..

Oke, geeft niets! Ik had er professionele hulp voor ingeschakeld, maar zei had eigenlijk alleen gezegd dat ik een chi² kon doen hierop om te kijken of ze verschilden maar nu ben ik zelf enorm gaan twijfelen en is zij op vakantie.. Paniek hier dus!quote:Op dinsdag 7 augustus 2012 10:46 schreef crossover het volgende:

Ik zou hier dieper op in moeten gaan om hier goed antwoord op te geven en daar heb ik helaas geen tijd voor.. misschien kan je professionele hulp inschakelen of een collega(-student) vragen?

Toch bedankt voor je hulp.

deze vraag is vooral naar Vreemdeeend gericht, maar anderen mogen natuurlijk ook antwoorden.

Ik heb in SPSS (wat anders) een onafhankelijke variabele "jaar". Deze variabele bestaat uit de jaren 1999, 2006 en 2010. Ik gebruik namelijk data van deze drie jaren om mijn onderzoek te verrichten. Ik wil onderzoeken of deze variabele ook een invloed heeft op mijn afhankelijke variabele.

Ik vraag me nu echter af hoe ik deze variabele moet coderen? Gebruik ik hem als continue variabele en steek ik hem "gewoon" in mijn model OF zet ik het over in dummy's waarbij ik een referentiecategorie kies?

Alvast bedankt!

Heb je alleen jaar als onafhankelijke variabele? Dan is het een simpele 1-way-ANOVA en hoef je niets te hercoderen.quote:Op woensdag 8 augustus 2012 23:33 schreef Melli7 het volgende:

Hey allemaal,

deze vraag is vooral naar Vreemdeeend gericht, maar anderen mogen natuurlijk ook antwoorden.

Ik heb in SPSS (wat anders) een onafhankelijke variabele "jaar". Deze variabele bestaat uit de jaren 1999, 2006 en 2010. Ik gebruik namelijk data van deze drie jaren om mijn onderzoek te verrichten. Ik wil onderzoeken of deze variabele ook een invloed heeft op mijn afhankelijke variabele.

Ik vraag me nu echter af hoe ik deze variabele moet coderen? Gebruik ik hem als continue variabele en steek ik hem "gewoon" in mijn model OF zet ik het over in dummy's waarbij ik een referentiecategorie kies?

Alvast bedankt!

Mijn onafhankelijke variabelen zijn: jaar, arbeidsmarktstatus, opleidingsniveau, inkomen en gezondheidstoestand

Mijn afhankelijke variabele zijn consumptie-uitgaven.

Het is dus de bedoeling om een meervoudige lineaire regressie uit te voeren.

Maar het is met de variabele jaar dat ik vastzit. Ik weet niet goed hoe deze in mijn model thuishoort. Maar het is wel belangrijk aangezien het jaar ook een invloed kan hebben op de consumptie-uitgaven.

[ Bericht 24% gewijzigd door Melli7 op 08-08-2012 23:54:51 (verduidelijking) ]

Maar denk dat ik het probleem dan alleen maar verleg....

Zullen het eens met dummy's proberen!

In ieder geval bedankt!

Welk van de twee methoden zou jij toepassen?

(Sorry voor het lastigvallen he)

Ik zou in dit geval voor de optie gaan met de minste variabelen (en dus minder vrijheidsgraden, dus meer accurate voorspellingen, dus eerder significantie). Dus omrekenen naar leeftijd en vervolgens als één variabele toevoegen.

Het valt me trouwens nu wel op dat je maar drie categorieen hebt, dus bovenstaand verhaal van mij weegt niet zo zwaar omdat je met dummies maar 1 extra variabele hebt.... dit brengt me weer aan het twijfelen.... ik zou er toch dummy's van maken vanwege het gebrek aan variantie.

[ Bericht 3% gewijzigd door crossover op 09-08-2012 12:11:04 ]

Klopt, gewoon dummy-variabelen gebruiken in dit gevalquote:Op donderdag 9 augustus 2012 12:04 schreef crossover het volgende:

Geeft niet ;-)

Ik zou in dit geval voor de optie gaan met de minste variabelen (en dus minder vrijheidsgraden, dus meer accurate voorspellingen, dus eerder significantie). Dus omrekenen naar leeftijd en vervolgens als één variabele toevoegen.

Het valt me trouwens nu wel op dat je maar drie categorieen hebt, dus bovenstaand verhaal van mij weegt niet zo zwaar omdat je met dummies maar 1 extra variabele hebt.... dit brengt me weer aan het twijfelen.... ik zou er toch dummy's van maken vanwege het gebrek aan variantie.

Bedankt allemaal, kan nu tenminste weer verder met zekerheid!

Ik heb bij meerdere regressie analyses enkele onverklaarbare negatieve Beta waarden. Deze horen overduidelijk niet negatief te zijn.

Wat zou er mis kunnen zijn gegaan?

De data is redelijk normaal verdeeld, dus dat is het probleem niet..

Oja en nog een vraagje over de output, als ik dus een lineaire regressie analsye doe, dan komt er een tabel genaamd coefficients (met oa de beta waarden). (na het anova tabel waarin mijn significante r2change in staan)

Ik doe meerdere stappen (dmv Enter), moet ik dan als ik naar de Beta waarden kijk alleen naar het laatste model kijken? (In die tabel staat er een verdeling van model 1, 2 en 3, waarbij alle variabelen er in de 3e in staan). Ik heb namelijk soms in bijv deel 2 wel significante beta waarden, maar dan in deel 3 zijn ze nonsign geworden.

Ik hoop dat iemand mn vragen begrijpt (en antwoorden weet).

Over je eerste vraag vond ik dit op internet. Vrij duidelijk uitgelegd:quote:Op donderdag 9 augustus 2012 22:44 schreef L.J.V. het volgende:

hallo, kan iemand mij met het volgende helpen?

Ik heb bij meerdere regressie analyses enkele onverklaarbare negatieve Beta waarden. Deze horen overduidelijk niet negatief te zijn.

Wat zou er mis kunnen zijn gegaan?

De data is redelijk normaal verdeeld, dus dat is het probleem niet..

Oja en nog een vraagje over de output, als ik dus een lineaire regressie analsye doe, dan komt er een tabel genaamd coefficients (met oa de beta waarden). (na het anova tabel waarin mijn significante r2change in staan)

Ik doe meerdere stappen (dmv Enter), moet ik dan als ik naar de Beta waarden kijk alleen naar het laatste model kijken? (In die tabel staat er een verdeling van model 1, 2 en 3, waarbij alle variabelen er in de 3e in staan). Ik heb namelijk soms in bijv deel 2 wel significante beta waarden, maar dan in deel 3 zijn ze nonsign geworden.

Ik hoop dat iemand mn vragen begrijpt (en antwoorden weet).

Voor die tweede zou ik in mijn statistiek bijbel van Field moeten kijken en die heb ik nu niet bij de hand..SPOILERHi. In a multiple regression, the beta coefficients are technically the same as the partial derivatives with respect to that variable, holding all other independent variables constant. So say I have 3 independent variables, X1, X2, X3.

The beta coefficient B1 of X1 is the expected change in Y(our dependent variable) for each one unit change in X, holding X2 and X3 constant. HOWEVER when your variables are in standardized form, the interpretation is a litte different. With standardized variables, a 1 standard deviation change in X1 equals B1 (the beta 1 coefficient) standard deviations in Y. We standardize our coefficients primarily because it allows us to directly compare the beta coefficients. Normally if we don't standardize the coefficients, each variable must be interpreted on the basis of its own units of measurement. Regardless, standardizing variables will not affect whether or not the coefficients are significant.

A negative beta coefficient means that a 1 unit positive standard deviation change in X is expected to result in a negative beta coefficient change in Y. So if your beta is, say, -3, a 1 unit standard deviation change in X is expected to result in a -3 standard deviation change in Y. It's very similar to the slope (it is the slope of our regression line, keeping all other variables constant).

DO NOT ignore the negative sign! It means your two variables (x,Y) are negatively associated/correlated. However, if you notice that the beta coefficient seems to change sign as you add or subtract other X variables, you may have a problem called multicollinearity, where the X variables are highly correlated with each other. This is especially true if the Betas correlate and the R-Square is high (R-Square tells you how much of the variance in Y the model explains). Normally the beta coefficient should not change sign as you add more independent variables. What is the correlation between X and Y? That is, if you simply doa correlate procedure (which is the same as a simple regression), is the sign still negative? If it is, then that's good, it means the two variables are likely negatively associated.

A negative or positive value on the beta coefficient SAYS NOTHING about significance. The only way to calculate significance is to divide the beta coefficient by its standard error. Usually, the rule of thumb is that any value (t-score) greater than 2 is significant at the usual 95% level of significance.

Heb ook geen idee of je vraag nu is opgelost hoor, maar ik was wel benieuwd wat negatieve Betas betekenden dus had het opgezocht

Ik heb zelf ook field voor mn neus, maar kan het niet vinden.

Ik heb geen multicollinearity volgens mij, zelfs als ik puur alleen 1 trek in de regressie analyse doe, heeft deze een negatieve beta waarde. (al is deze nu niet meer significant....)

Een negatieve beta waarde an sich is geen probleem, als het logisch zou zijn.

Maar bij mij is het soms tegenstrijdig met wereldwijde bekende resultaten, en soms met pure logica.

Dankjewel voor het helpen, ik zoek zelf ook nog verder door uiteraard..

Je tweede vraag ligt aan wat je vraagstelling is.

Als b.v het idee is dat met warmer weer, meer mensen naar het strand gaan, en er dus meer mensen verdrinken,

zou je in model 1 waar je alleen warmte --> verdrinken meet een significante beta verwachten maar nadat je hoeveelheid mensen die naar het strand gaan die beta nonsig moeten worden. Als dat je hypothese is, is die verandering in beta dus verschrikkelijk interessant en moet je dat noemen. Als je een exploratief iets doet waar je gewoon van 10 onafhankeleijke het effect wilt bekijken, neem je alleen je uiteindelijke model.

Verder is het raar dat die betas negatief zijn, aangezien uit de literatuur blijkt dat die positief horen te zijn.

Het is dus zeer tegenstrijdig met alle literatuur die er over dit onderwerp bestaat.

ik denk dat ik dubieuze data heb.

Ik zou even een correlatiematrix maken en die goed bekijken.quote:Op vrijdag 10 augustus 2012 13:18 schreef L.J.V. het volgende:

dankjewel! ik moet dus idd naar het laatste model kijken.

Verder is het raar dat die betas negatief zijn, aangezien uit de literatuur blijkt dat die positief horen te zijn.

Het is dus zeer tegenstrijdig met alle literatuur die er over dit onderwerp bestaat.

ik denk dat ik dubieuze data heb.

Stel bv. je meet inkomen, IQ en openheid t.o.v. andere culturen.

Conceptueel zouden de eerste en de twee positief moeten correleren, maar de eerste twee negatief met de derde. Zoiets kun je ook doen met jouw variabelen en kun je kijken of de basis-relaties overeenkomen met de literatuur. Als dat allemaal klopt, kun je kijken of je de analyse goed uit hebt gevoerd. Als daar al vreemde patronen in zitten, kun je kijken of je misschien toevallig 1-2 vreemde mensen hebt of dat er een geheel onverklaarbaar patroon in je data zit.

Voor het pre-schooljaar heeft mijn zusje een opdracht met SPSS gekregen. Met mijn vroegere studie Technische bedrijfskunde

Situatie: ze heeft een enquête m.b.t. stemgedrag afgenomen bij zo'n 30 personen. Deze personen moesten maximaal 2 antwoorden kiezen uit 4 keuzes. Keuzemogelijkheden A-B-C-D.

Kortom: sommige personen hebben alleen A geantwoord, sommige zowel A en B.

In SPSS (data view) zijn de personen in de linker kolom weergegeven. De variabelen staan in de kolom daarnaast en zijn in de variable view omgezet in: A=1, B=2, C=3, D=4.

Vraag: in SPSS (data view) zijn dus twee kolommen aangemaakt, Kolom 1=bedrijven en Kolom 2= variabele (het antwoord). Echter kan er maar één variabele in het invoerveld worden ingevuld. Ofwel 1, 2, 3, 4. Voor deze opdracht moeten er meerdere variabelen ingevuld kunnen worden. Zo komt het er uit te zien:

Kolom 1 - Kolom 2

Anne - 3, 4

Ben - 2

Carla- 1, 2

Het bovenstaande lukt alleen bij 'Ben' (1 invoer), twee getallen pakt hij niet. Is dit simpel op te lossen? Anders ga ik haar adviseren de vragen nog wat anders op te stellen o.i.d.

bedrijf, A, B, C, D

henkiesgehakt, 0, 1, 0, 0

schoonnmaakexpres 0 , 1, 1, 0

de eerste persoon heeft alleen B aangevinkt, de tweede B en C.

Je zou eventueel om meer info vast te leggen er nog voor kunnen kiezen de mensen die slechts 1 kozen een 2 te geven, de mensen die er twee kozen 1 per antwoord.

Voorbeeld:

Je redenatie verwisselt oorzaak en gevolg. Als het alleen maar zou zijn om moeilijker significant te worden, zou je gewoon een correctie kunnen gebruiken.quote:Op zaterdag 18 augustus 2012 10:00 schreef crossover het volgende:

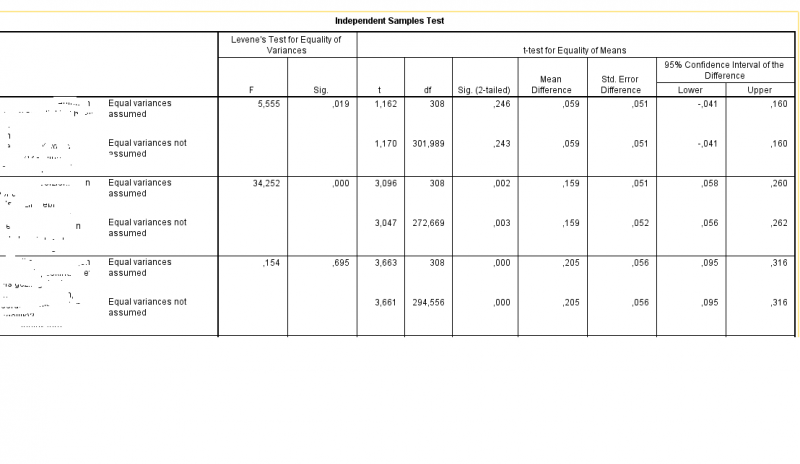

Wie weet er waarom de DF lager wordt wanneer de assumptie van gelijke varianties (Levene's test) wordt geschonden (dus significant is)? Is dit om te compenseren voor een type 1 fout? Mijn redenatie is dat bij verlaging van de df het effect groter moet zijn om een significant verschil te krijgen. Any thoughts?

Voorbeeld:

[ afbeelding ]

De reden achter de lagere DF is dat de variantie van de twee groepen (en het verband daartussen) op een andere manier geschat moet worden. In plaats van geschatte gedeelde variantie moet je het verband tussen de variantie in groep 1 en 2 bepalen. De volgende formule wordt daarvoor gebruikt: http://en.wikipedia.org/wiki/Welch%E2%80%93Satterthwaite_equation

Hmm niet helemaal.quote:Op zaterdag 18 augustus 2012 10:31 schreef crossover het volgende:

Dus het komt er op neer dat niet de reguliere df gebruikt kan worden maar omdat er sprake is van ongelijke varianties moet deze op een andere manier geschat worden?

Stel je voor dat je 4 getallen hebt met een gemiddelde van 10. Dan heb je 3 degrees of freedom. De eerste 3 getallen kunnen zijn wat je wilt, het vierde getal moet een bepaald getal zijn om het gemiddelde van 10 te krijgen.

Bij gedeelde variantie, bepaal je maar 1 ding, er blijft dus heel veel "vrijheid" over. Bij die andere variantie, bepaald je het verband tussen de twee varianties, dat is er definitie een minder "vrije" bepaling. Ik weet niet precies hoe de test werkt, maar ga er van uit dat je meerdere zaken bepaalt, b.v. gemiddelde variantie groep 1, gemiddelde 2 en de correlatie ertussen. Dit beperkt de vrijheid van je groep getallen, daarom kom je terecht op minder degrees of freedom.

Het is dus niet zo dat je iets van reguliere df hebt en dat je dat aan kunt passen, de df die je over houdt is eigenlijk de vrijheid van je data nadat je er beperkingen op hebt losgelaten. De t-test heeft maar weinig beperkingen, je "verliest" 1 df per groepsgemiddelde, die andere test heeft meer beperkingen, naast de groepsgemiddelden beperk je je data ook bij de benadering van de variantie.

Hoop dat dit duidelijk is

Schouderklopjes meldtopic.quote:

Als het goed is kun je op de tabel in je output dubbelclicken. Daarin kun je aanassen hoeveel getallen je achter de comma wilt dus ik vermoed dat je daar ook de max charaters voor strings aan kunt passen.quote:Op maandag 20 augustus 2012 22:45 schreef yozd het volgende:

Ik heb een databestand met strings van 1200 characters. Die wil ik graag "listen", maar in de output krijg ik ze maar tot 255 characters. Hij breekt de informatie dus af in de viewer. Hoe stel ik het in dat ik alles te zien krijg?

Het is me niet gelukt. Ik heb het nu met summarize gedaan.quote:Op maandag 20 augustus 2012 23:54 schreef oompaloompa het volgende:

Als het goed is kun je op de tabel in je output dubbelclicken. Daarin kun je aanassen hoeveel getallen je achter de comma wilt dus ik vermoed dat je daar ook de max charaters voor strings aan kunt passen.

Alleen x1 op y1 geeft een significant verband.

Alleen x2 op y1 geeft een significant verband.

Alleen x3 op y1 geeft een significant verband.

Maar:

x1 en x2 en x3 tegelijk in het model gooien geeft voor allen een niet significant verband.

Kan iemand mij de logica hierachter uitleggen?

-edit-

multicollineariteit...

[ Bericht 2% gewijzigd door yozd op 29-08-2012 14:29:06 ]

Ik vind dit toch nog steeds moeilijk te vatten. Ander voorbeeld;quote:Op woensdag 29 augustus 2012 13:06 schreef yozd het volgende:

Ik heb een dichotome afhankelijke variabele (y1): "wel" of "niet". Nu heb ik 3 (x1, x2, x3) onafhankelijke variabelen (op interval schaal) waarvan ik wil testen wat de invloed van ze is op die afhankelijke.

Alleen x1 op y1 geeft een significant verband.

Alleen x2 op y1 geeft een significant verband.

Alleen x3 op y1 geeft een significant verband.

Maar:

x1 en x2 en x3 tegelijk in het model gooien geeft voor allen een niet significant verband.

Kan iemand mij de logica hierachter uitleggen?

Stel ik voer 3 OLS regressies uit:

(1) Alleen x1 op y1 geeft:

R^2 = 0,28

het totale model is significant (ANOVA-tabel met die F-waarde).

Een significant verband tussen x1 en y1

(2) Alleen x2 op y1 geeft:

R^2 = 0,17

het totale model is significant (ANOVA-tabel met die F-waarde).

Een significant verband tussen x1 en y1

(3) x1 en x2 op y1 geeft:

R^2 adjusted = 0,36

het totale model is significant (ANOVA-tabel met die F-waarde).

Een significant verband tussen x1 en y1(Coefficients-tabel)

Geen significant verband tussen x2 en y1(Coefficients-tabel)

Het totale model is beter, want R^2 adjusted is hoger dan de R^2 van elk van de andere modellen. Het model is significant, maar 1 variabele niet. Hoe interpreteer ik dit?

Ik heb er totaal geen problemen mee, werkt al jaren als een trein.quote:Op maandag 10 september 2012 18:37 schreef Stienn het volgende:

Werkt dat een beetje? Hoor van een aantal mensen dat hij vaak vast loopt e.d.

Het enige waar ik aan kan denken is via een heel ingewikkeld proces de 19 rep-meas columns in een column te plakken en dan in een andere column per conditie de iteratie op te schrijven, maar dat moet toch wel makkelijker kunnen?

Met RV.NORMAL kan ik een normaal verdeelde dataset maken. Maar hoe krijg ik dan een minimum van getal 1 en een maximum van 10? En is bij een normaal verdeelde dataset tussen 1 en 10 het gemiddelde 5?

Met RV.UNIFORM kan ik wel een minimum en een maximum aangeven, maar dan wordt de dataset niet normaal verdeeld.

De letterlijke opdracht is: Simuleer eerst een onafhankelijke variabele zodanig dat deze normaal verdeeld is en een score heeft tussen 1 en 10.

met de volgende syntax maak je een databestand aan met 600 cases, die zijn nodig voordat je data kan genereren:

| 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 | INPUT PROGRAM. LOOP #i=1 to 600. COMPUTE id=#i. COMPUTE x=RV.NORMAL(0,1). END CASE. END LOOP. END FILE. END INPUT PROGRAM. EXECUTE. |

compute Zxnormaalverdeeld = 5.5 + (2.8*x).

execute.

En dan een beetje zoeken naar een juiste verdeling?

Er is vast een manier om dit exact te berekenen, maar dit is misschien voldoende.

[ Bericht 13% gewijzigd door crossover op 21-10-2012 16:52:43 ]

| 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 | INPUT PROGRAM. LOOP #i=1 to 600. COMPUTE id=#i. COMPUTE x=RV.NORMAL(0,1). END CASE. END LOOP. END FILE. END INPUT PROGRAM. EXECUTE. DESCRIPTIVES VARIABLES=x /SAVE /STATISTICS=MEAN STDDEV MIN MAX. compute Zxnormaalverdeeld = 5.5 + (1.80*Zx). execute. EXAMINE VARIABLES=Zxnormaalverdeeld /PLOT BOXPLOT STEMLEAF NPPLOT /COMPARE GROUPS /STATISTICS DESCRIPTIVES /CINTERVAL 95 /MISSING LISTWISE /NOTOTAL. |

De loggers hebben elke 45 minuten te temperatuur gemeten (Niet allemaal op exact hetzelfde moment maar welk dicht bij elkaar, binnen 15 minuten). Misschien hebben jullie wat handige tips waarmee je leuke grafieken kan krijgen en met welke statistische toets ik de temperaturen kan toetsen.

Dan kan ik toch met een indepentend t-test checken of het aantal uren voorbereiden gemiddeld voor de groepen geslaagd of niet-geslaagd verschilt?

Of moet dat met een andere test? Zijn de groepen niet onafhankelijk?

(1). Inderdaad, een onafhankelijke t-toets met geslaagd/niet geslaagd als als onafhankelijke variabele om te kijken of het gemiddelde aantal uren studeren verschilt voor de twee groepen.

(2). Logistische regressie waarbij je bekijkt wat de kans is op slagen bij een stijging van x uren studeren.

Optie 1 ligt het meest voor de hand, tenzij je bij enkelvoudige regressie kan controleren voor andere relevante variabelen.

Links is hoe mijn docent het heeft gedaan. Recht is hoe ik de Boxplot krijg.SPOILER

Mijn vraag is, hoe krijg ik de boxplot zo omgedraaid, dat de assen hetzelfde staan, als de linker boxplot? Het gaat mij niet om lay out etc, echt puur om het draaien van de assen.

Ik heb mij suf gegoogled, het boek geraadpleegd, nergens tref ik ook maar iets hierover aan. Zelfs op google afbeeldingen, staan alle boxplots zo als de rechter boxplot.

Can someone pls help me out?

quote:Op zondag 4 november 2012 20:38 schreef crossover het volgende:

Dubbelklik op de grafiek, Options, Transpose chart.

Kreeg dit zojuist van iemand door.. Tnx.. Begrijp niet dat dit nergens in mijn boek vermeld staat.

Ik ben voor mijn afstuderen bezig met het analyseren van een enquête.

Daar in staan een aantal stellingen en kan men antwoord geven 'helemaal mee ons eens' tot 'helemaal mee eens'.

In SPSS dit in cijfers 1 t/m 5 gezet. Alleen men had ook de keus 'Weet niet' in te vullen, nummert 6.

Nu wil ik deze stellingen vergelijken en via Comput Variable heb ik al die stellingen bij elkaar op laten tellen. Bij lage cijfers kan ik dan zeggen helemaal mee oneens en bij hoge cijfers zijn de respondenten het er mee eens.

Alleen. nu kom ik tot de conclusie dat nummer 6 overal meegerekend wordt en dus hoge cijfers ook een hoop 'Weet niet' kunnen betekenen. Oeps!

Via Select Case geprobeerd om de '6' weg te laten bij élke stelling zodat er maar van 1 tot 5 geteld wordt. Alleen daar kom ik niet uit.

Ik kan meerder stellingen toevoegen bij Select Cases alleen als iemand dan op stelling één een 'Weetniet' geeft maar verder wel de antwoorden 1 tm 5 geeft wordt die gehele respondent niet mee geteld! En dat is natuurlijk niet de bedoeling.

Heeft iemand enig idee hoe ik dit het beste kan oplossen?

Dank is groooot!

Het zou me heel wat analyses opnieuw doen schelen...

Als een SPSS-bestand (.sav) is aangemaakt en opgeslagen op een Windows PC, is dat bestand dan altijd zonder meer te openen op een Mac?

Want krijg net van een Mac gebruiker te horen dat hij alleen maar een rits met verschillende tekens te zien krijgt als hij het bestand opent, terwijl het er bij mij gewoon goed uit ziet.

Iemand een idee wat hier het probleem kan zijn (conversie-programma nodig ofzo)?

Ik werk met de Mac versie en ik kon zonder problemen bestanden uitwisselen met windowsgebruikers toen dat nodig was. Gebruiken jullie een verschillende versie? (qua nummer dan)quote:Op woensdag 21 november 2012 15:26 schreef BrainTeaser het volgende:

Vraagje over SPSS i.c.m. met Windows en Mac:

Als een SPSS-bestand (.sav) is aangemaakt en opgeslagen op een Windows PC, is dat bestand dan altijd zonder meer te openen op een Mac?

Want krijg net van een Mac gebruiker te horen dat hij alleen maar een rits met verschillende tekens te zien krijgt als hij het bestand opent, terwijl het er bij mij gewoon goed uit ziet.

Iemand een idee wat hier het probleem kan zijn (conversie-programma nodig ofzo)?

Dat kan ik inderdaad nog wel even vragen ja! Maar dat zou toch over het algemeen ook geen probleem moeten zijn, of wel?quote:Op woensdag 21 november 2012 16:36 schreef Operc het volgende:

[..]

Ik werk met de Mac versie en ik kon zonder problemen bestanden uitwisselen met windowsgebruikers toen dat nodig was. Gebruiken jullie een verschillende versie? (qua nummer dan)

Bovenstaande vraag staat nog steeds... En inmiddels nog een vraag erbij.quote:Op woensdag 21 november 2012 10:17 schreef Pinklady89 het volgende:

Oké, waarschijnlijk kom ik nu echt met de domste vraag ever.... Maar als ik mijn output opsla op een computer, die output vervolgens mail (en opsla op de harde schijf) en probeer te openen op een andere computer, krijg ik die output niet normaal geopend. Alle grafieken opent 'ie netjes, maar alle tabellen blijven tot in den eeuwigheid op "processing" staan. Ergo: ik doe iets verkeerd. Maar wat....? En hoe doe ik het wel goed?

Het zou me heel wat analyses opnieuw doen schelen...

Het gaat om een (hïerarchische) regressieanalyse.

In mijn model summary heb ik twee F-waardes. Nu dacht ik eigenlijk dat die F-waardes (incl. significantie) gelijk moesten zijn aan de F-waardes in de ANOVA-tabel. Dat is dus niet zo. Alleen de F-waarde van model 1 is gelijk, maar de F-waarde van model 2 wijkt af. Wat is die F-waarde van model 2 in de ANOVA-tabel dan? En waarom gebruik ik bij de beschrijving van mijn resultaten wel de vrijheidsgraden uit de ANOVA-tabel?

Het gaat om:

-Omzetten van stellingen in waarden op vier determinanten

-Deze determinanten linken aan gekozen vormen voor samenwerking

-Deze vormen van samenwerking linken aan stellingen die effectiviteit meten

Ik kom er niet meer uit

heb hier een tijdje geleden veel mensen uit dit topic zelf geholpen met SPSS, maar ik heb mijn laatste vak vijf jaar geleden gehad. Ben er helemaal uit en heb geen tijd om het me weer eigen te maken.

Ik ga er vanuit van niet nee. Je mag hem best even naar mij sturen, dan kijk ik even of ik het op mijn mac gewoon kan uitlezen.quote:Op woensdag 21 november 2012 18:12 schreef BrainTeaser het volgende:

[..]

Dat kan ik inderdaad nog wel even vragen ja! Maar dat zou toch over het algemeen ook geen probleem moeten zijn, of wel?

Die tweede vraag heb ik geen antwoord op. Wat betreft de eerste: Heb je op die andere computer wel SPSS geïnstalleerd staan? En als je analyses liever niet opnieuw wil doen (qua knopjes aanklikken) is het misschien handig om voortaan de syntax ook op te slaan. Dan kun je daarna met 1 druk op de knop alle output genereren van de analyses die je op de data hebt losgelaten.quote:Op woensdag 21 november 2012 18:14 schreef Pinklady89 het volgende:

[..]

Bovenstaande vraag staat nog steeds... En inmiddels nog een vraag erbij.

Ja, ik heb op die computer SPSS staan. Die syntax sla ik nu inderdaad op, maar irritant blijft het. Bedankt voor je input in ieder geval!quote:Op woensdag 21 november 2012 19:01 schreef Operc het volgende:

[..]

Die tweede vraag heb ik geen antwoord op. Wat betreft de eerste: Heb je op die andere computer wel SPSS geïnstalleerd staan? En als je analyses liever niet opnieuw wil doen (qua knopjes aanklikken) is het misschien handig om voortaan de syntax ook op te slaan. Dan kun je daarna met 1 druk op de knop alle output genereren van de analyses die je op de data hebt losgelaten.

Ik zou willen, maar zoals je het hierboven stelt, snap ik er helemaal niets van. Dus ik ben bang dat ik je niet kán helpen.quote:Op woensdag 21 november 2012 18:15 schreef Skv het volgende:

Zijn hier mensen die aardig kunnen SPSSen en willen helpen met analyses?

Het gaat om:

-Omzetten van stellingen in waarden op vier determinanten

-Deze determinanten linken aan gekozen vormen voor samenwerking

-Deze vormen van samenwerking linken aan stellingen die effectiviteit meten

Ik kom er niet meer uit

heb hier een tijdje geleden veel mensen uit dit topic zelf geholpen met SPSS, maar ik heb mijn laatste vak vijf jaar geleden gehad. Ben er helemaal uit en heb geen tijd om het me weer eigen te maken.

Wat bedoel je precies met dat eerste? Omscoren "mee eens" etc naar cijfers?quote:Op woensdag 21 november 2012 18:15 schreef Skv het volgende:

Zijn hier mensen die aardig kunnen SPSSen en willen helpen met analyses?

Het gaat om:

-Omzetten van stellingen in waarden op vier determinanten

-Deze determinanten linken aan gekozen vormen voor samenwerking

-Deze vormen van samenwerking linken aan stellingen die effectiviteit meten

En "linken" bedoel je daarmee het analyseren van het effect van het ene op het andere?

Normaal gezien zou de outputfile wel gewoon moeten werken, misschien computer opnieuw opstarten of iets dergelijks? (Of een versie probleem ofzo?)quote:Op woensdag 21 november 2012 19:06 schreef Pinklady89 het volgende:

[..]